Ce blog n'a d'autre prétention que de me permettre de mettre à la disposition de tous des petits textes que j'écris. On y parle surtout d'informatique mais d'autres sujets apparaissent parfois.

Le mini-PC Shuttle Nano NE10N

Première rédaction de cet article le 29 janvier 2026

J'ai acheté un mini-PC Shuttle Nano NE10N et cet article est là pour documenter cet appareil et parler du problème d'installation avec sa carte Ethernet.

Je voulais ce mini-PC pour un serveur à la maison, restant allumé en permanence. Mon cahier des charges était :

- Peut faire tourner Linux, de préférence Debian,

- Très silencieux (puisque allumé en permanence),

- Faible consommation électrique (puisque allumé en permanence),

- Au moins 100 Go de disque et 2 Go de RAM (le processeur n'est pas important, un ARM aurait parfaitement convenu),

- Ethernet (pas besoin de Wifi). Et cela a été le plus gros problème lors de l'installation.

En outre, je souhaitais :

- Pas sur Amazon ou AliExpress,

- Peu encombrant (bon, c'est le principe du mini-PC),

- Pas de ventilateur,

- Vendu sans Windows pour ne pas payer de licence,

- Dans un seul boitier (pas de bricolage matériel nécessaire).

J'indiquerai plus tard quelques pistes que j'ai suivies. Mais d'abord, la machine.

Voici l'engin de face, de dos et l'intérieur :

Voici le matériel sur le bus PCI :

% lspci 00:00.0 Host bridge: Intel Corporation Alder Lake-N Processor Host Bridge/DRAM Registers 00:02.0 VGA compatible controller: Intel Corporation Alder Lake-N [UHD Graphics] 00:08.0 System peripheral: Intel Corporation GNA Scoring Accelerator 00:0a.0 Signal processing controller: Intel Corporation Platform Monitoring Technology (rev 01) 00:0d.0 USB controller: Intel Corporation Alder Lake-N Thunderbolt 4 USB Controller 00:14.0 USB controller: Intel Corporation Alder Lake-N PCH USB 3.2 xHCI Host Controller 00:14.2 RAM memory: Intel Corporation Alder Lake-N PCH Shared SRAM 00:16.0 Communication controller: Intel Corporation Alder Lake-N PCH HECI Controller 00:17.0 SATA controller: Intel Corporation Alder Lake-N SATA AHCI Controller 00:1c.0 PCI bridge: Intel Corporation Alder Lake-N PCI Express Root Port #4 00:1f.0 ISA bridge: Intel Corporation Alder Lake-N PCH eSPI Controller 00:1f.3 Audio device: Intel Corporation Alder Lake-N PCH High Definition Audio Controller 00:1f.4 SMBus: Intel Corporation Alder Lake-N SMBus 00:1f.5 Serial bus controller: Intel Corporation Alder Lake-N SPI (flash) Controller 01:00.0 Ethernet controller: Motorcomm Microelectronics. YT6801 Gigabit Ethernet Controller (rev 01)

Les caractéristiques du processeur sont en

nano-ne10-cpu.txtnano-ne10-boot.txt

La consommation électrique, mesurée par un wattmètre Chacon est de 5 W au calme et de 15 W quand la machine travaille à fond.

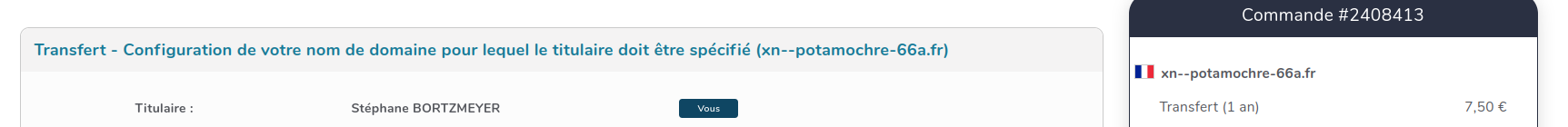

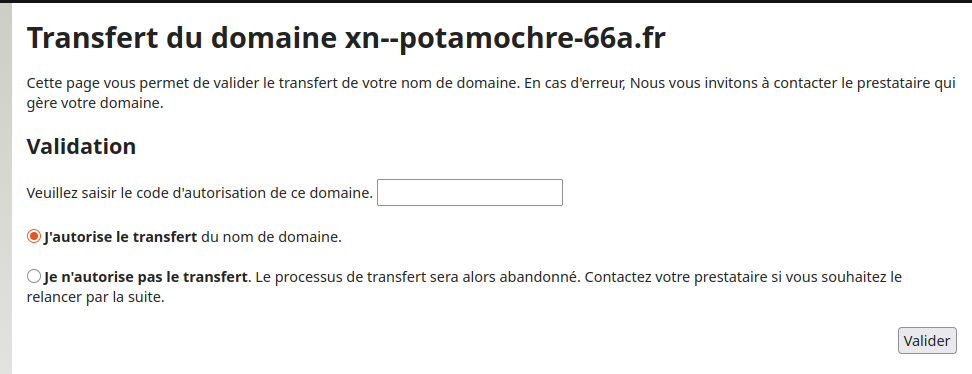

Où trouve-t-on cette machine ? Shuttle ne vend pas en direct. On peut trouver des machines chez des vendeurs en ligne mais je n'avais pas envie d'acheter chez des boites peu sympathiques et puis je voulais davantage de RAM et de disque que dans le cas de l'offre par défaut, et je n'avais pas envie de monter cela moi-même (ce qui aurait été assez facile, le boitier s'ouvre facilement et tout est accessible). Heureusement, des revendeurs de Shuttle rendent ce service. Si MisterOops n'a jamais répondu à mes demandes de devis, M2N a été très réactif et m'a rapidement livré un PC comme je voulais (« Shuttle XPC nano NE1000N Configurable (Sans Système d'exploitation, 8 Go DDR4, 500 Go SSD M.2 (SATA), Aucun) 1,00 Unité(s) »), après passage par le configurateur de Shuttle. (La bonne RAM serait de la DDR5, mais actuellement elle est hors de prix et peu disponible.)

J'avais demandé une machine sans système

d'exploitation en me disant qu'il n'y avait pas de

raison que l'installation pose des problèmes. J'ai téléchargé une

image « netinst » (Network Installation)

Debian, copié sur une clé

USB avec cp debian.iso /dev/sdX

quand soudain, le drame : « A driver for your hardware is

not available. You may need to load drivers from removable

media. Load missing drivers from removable

media? ». L'installateur de l'actuelle version de Debian

n'a en effet pas de pilote pour la carte

Ethernet « YT6801 Gigabit Ethernet ». (Ah, comment on trouve le type

de la carte et donc le pilote nécessaire ? Alt-F2 pour changer de

console puis lspci.)

Je vous donne tout de suite la solution :

- Installer Debian sans le réseau en utilisant l'image dite « DVD » (pas sur un DVD, bien sûr, mais sur une clé USB de bonne capacité car l'image fait 3,7Go),

- Comme il va falloir installer des

paquetages pour compiler un

pilote, mettre dans

/etc/apt/sources.listla lignedeb file:///mnt trixie main(où/mntest l'endroit où vous montez la clé USB), puisapt update, - Installer avec

apt install build-essential kmod dpkg-dev build-essential patch linux-headers-6.12.48+deb13-amd64, - Récupérer le pilote chez Tuxedo,

wget https://deb.tuxedocomputers.com/debian/pool/main/t/tuxedo-yt6801/tuxedo-yt6801_1.0.30tux4_all.deb, et le mettre sur une clé USB, - Récupérer le paquetage

dkms, qui existe chez Debian, et est indispensable pour compiler proprement le pilote, mais n'est pas dans l'image d'installation,wget http://ftp.fr.debian.org/debian/pool/main/d/dkms/dkms_3.2.2-1~deb13u1_all.deb, et le mettre sur une clé USB, - Installer les deux paquetages téléchargés (mettons que la

clé USB ait été montée en

/mnt2) avecapt install /mnt2/tuxedo-yt6801_1.0.30tux4_all.deb /mnt2/dkms_3.2.2-1~deb13u1_all.deb.

Le pilote va alors être compilé et installé, tout est bien qui finit bien, Ethernet marche.

% dpkg -l | grep yt6801

ii tuxedo-yt6801 1.0.29tux0 all Driver for Motorcomm YT6801

% lsmod | grep yt6801

yt6801 163840 0

% ip link show

…

2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000

link/ether 38:f7:cd:ce:22:c6 brd ff:ff:ff:ff:ff:ff

altname enx38f7cdce22c6

Cette approche est également documentée sur le forum de Linux Mint ou bien sur Reddit. Notez que ce pilote réseau fait débat, ce qui peut expliquer son absence de Debian.

Les autres machines que j'avais considérées :

- Le Trigkey Key-N150 (je ne me souviens même plus pourquoi je l'avais écarté),

- Les Raspberry Pi sont cools mais je préférais une solution toute intégrée, pas un SBC,

- Les Tuxedo étaient bien trop chers, trop haut de gamme (j'ai un portable de cette marque),

- Même chose pour le Slimbook,

- Le Geekom aussi est cher,

- Le BMax B5A Pro (16Go de RAM, 512Go de SSD, AMD Ryzen7 5825U) sur AliExpress (un utilisateur m'a raconté qu'il avait dû changer l'alimentation, défaillante),

- Le MiniPC Soyo M4 Plus Intel N150 (je crois que je ne l'avais trouvé que sur AliExpress),

- Le Beelink ME Pro, plutôt pour faire NAS que serveur mais, de toute façon, il ne semble pas encore sorti.

Vous avez aussi un test de la machine que j'ai achetée sur l'excellent site MiniMachines. Notez qu'ils sont sur le fédivers, en @PierreLecourt@oisaur.com.

L'article seul

RFC 9816: Usage and Applicability of BGP Link-State Shortest Path Routing (BGP-SPF) in Data Centers

Date de publication du RFC : Juillet 2025

Auteur(s) du RFC : K. Patel (Arrcus), A. Lindem (LabN Consulting), S. Zandi, G. Dawra (Linkedin), J. Dong (Huawei Technologies)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF lsvr

Première rédaction de cet article le 27 janvier 2026

Le RFC 9815 normalise l'utilisation de l'algorithme de routage SPF avec BGP. Dans quels cas est-ce que ça peut s'appliquer à l'intérieur d'un centre de données ? Ce RFC 9816 donne des éléments de réponse.

Il s'agit donc d'un court complément au RFC 9815 pour un cas courant, le centre de données qui suit la topologie décrite par Charles Clos dans son article de 1952, « A study of non-blocking switching networks ». (On trouve aussi cet article sur Sci-Hub ou à divers endroits sur le Web.) Pour que le trafic circule de n'importe quel nœud d'entrée vers n'importe quel nœud de sortie, on peut connecter tous les nœuds d'entrée à tous les nœuds de sortie mais cela fait beaucoup de connexions, qui coûtent cher. Ou bien on peut connecter tous les nœuds d'entrée à un dispositif de commutation qui ira vers tous les nœuds de sortie. Mais le trafic risque d'être bloqué si ce dispositif est surchargé. Dans un réseau Clos, on met des nœuds intermédiaires, avec une connectivité suffisante pour qu'on ne soit pas bloqué dans la plupart des cas. Il y a donc plusieurs chemins possibles d'un bout à l'autre du tissu ainsi formé (ce qui fait qu'un algorithme de routage comme le spanning tree n'est pas optimal puisqu'il ne trouve qu'un seul chemin). Dans un centre de données moderne, il y a en général une épine dorsale formée des commutateurs rapides et, dans chaque baie, un commutateur ToR (Top of Rack, rien à voir avec Tor). Tous les commutateurs ToR sont connectés à l'épine dorsale (liaison dite Nord-Sud, l'épine dorsale étant représentée en haut, le Nord) alors qu'il n'y a pas forcément de liaison entre les commutateurs ToR (liaison dite Est-Ouest).

Dans un centre de données non public (où toutes les machines appartiennent à la même entité), quel protocole de routage utiliser ? A priori, un IGP, non, puisqu'il s'agit de routage interne ? Mais pour diverses raisons, entre autres pour se simplifier la vie avec un seul protocole pour tout, certains utilisent BGP (RFC 7938) et même EBGP (External BGP), où les routeurs sont dans des AS différents (regardez la section 5 du RFC 7938 pour comprendre ce choix). Mais avec EBGP, les sessions BGP correspondent au chemin des données, ce qui empêche d'utiliser des réflecteurs de route. Et puis l'algorithme de routage classique de BGP ne converge pas assez vite en cas de changement, ce qui n'est pas grave sur l'Internet public mais est plus gênant à l'intérieur du centre de données. C'est là que le BGP-SPF du RFC 9815 devient intéressant, en remplaçant l'algorithme de routage traditionnel par SPF.

Utiliser BGP permet aussi de simplifier l'authentification, en se reposant sur les mécanismes existants comme celui du RFC 5925.

Autre avantage, les équipements réseau de ce centre de données aiment bien avoir de l'information détaillée sur la topologie et c'est justement ce que fournit l'extension BGP Link State, normalisée dans le RFC 9552, et dont BGP-SPF dépend. Il n'y a plus qu'à écouter le trafic BGP pour tout apprendre du réseau et bâtir ainsi divers services.

Plusieurs topologies d'appairage sont possibles entre les routeurs, collant à la topologie physique ou bien s'en écartant. Les routeurs peuvent utiliser BFD (RFC 5880) pour vérifier en permanence qu'ils arrivent bien à se joindre.

Même si le vieux protocole IPv4 est présent, on peut ne s'appairer qu'en IPv6 (cf. le RFC 8950) voire qu'avec des adresses locales (RFC 7404).

Et si un routeur veut jouer à BGP avec les autres routeurs mais sans être utilisé pour transmettre des paquets ? (Par exemple parce qu'il héberge des services applicatifs qui doivent être joignables.) Le TLV SPF status (RFC 9815, section 5.2.1.1) sert à cela : s'il est présent, avec une valeur de 2, le nœud ne sera pas utilisé pour le transit des paquets.

L'article seul

RFC 9815: BGP Link-State Shortest Path First (SPF) Routing

Date de publication du RFC : Juillet 2025

Auteur(s) du RFC : K. Patel (Arrcus), A. Lindem (LabN Consulting), S. Zandi (LinkedIn), W. Henderickx (Nokia)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF lsvr

Première rédaction de cet article le 27 janvier 2026

Vous le savez (peut-être), le protocole de routage BGP est du type « vecteur de chemin ». Mais il peut aussi transporter des états des liens, si on souhaite faire des choses plus proches des protocoles à état des liens. Ce RFC décrit comment, avec ces informations sur l'état des liens, décider du routage par l'algorithme SPF (Shortest Path First) plutôt que par la méthode traditionnelle de BGP.

Pour simplifier, un protocole à état des liens (comme OSPF ou IS-IS) permet à chaque routeur d'avoir l'état complet du réseau, et donc de faire tourner des algorithmes comme SPF, qui nécessite justement cette connaissance totale. Par contre, un protocole à vecteur de distance comme RIP ou à vecteur de chemin comme BGP n'a pas besoin de cette information et consomme donc moins de mémoire (pour BGP, stocker l'état de toutes les liens de l'Internet serait évidemment impossible). Mais le protocole doit développer des mécanismes pour éviter, par exemple, les boucles de routage, qui pourraient arriver puisque chaque routeur décide sur la base d'une information incomplète.

Les deux types de protocole ont des avantages et des inconvénients et il est donc tentant de les combiner. Le RFC 9552 normalise justement un moyen de transporter l'état des liens avec BGP. Cela permet des prises de décision plus « intelligentes », comme dans le cas du RFC 9107 pour un réflecteur ou du RFC 7971 pour le mécanisme de décision ALTO. Pour transporter cet état, le RFC 9552 normalise un AFI (Address Family Identifier, RFC 4760, section 3) et un SAFI (Sub-address Family Identifier, même référence). Ce sont l'AFI 16388 et le SAFI 71. Ce BGP-LS (Border Gateway Protocol - Link State) sert de base à ce nouveau RFC, qui décrit une des manières d'utiliser cette information sur l'état des liens. (Cette technique a plusieurs années mais le développement du RFC a été long.)

Beaucoup de gros centres de données utilisent en interne BGP (RFC 4271) pour distribuer l'information de routage, car la densité des équipements créerait trop de trafic, avec les protocoles plus bavards comme OSPF (c'est documenté dans le RFC 7938 et RFC 9816). (Ces gros centres sont parfois appelés MSDC pour Massively Scaled Data Centers.) En outre, BGP repose sur TCP, ce qui élimine les problèmes de gestion des paquets perdus qu'ont les IGP traditionnels. Et puis cela permet de n'utiliser qu'un seul protocole comme IGP et EGP. Il ne restait qu'à étendre BGP pour pouvoir utiliser l'algorithme SPF de certains IGP, ce que fait notre RFC. Le principal avantage (section 1.2 du RFC) de cet ajout est que tous les routeurs auront désormais une vue complète de tout le réseau, sans qu'il y ait besoin de multiplier les sessions BGP. C'est utile pour des services comme ECMP, le calcul à l'avance de routes de secours (RFC 5286), etc.

Un peu de terminologie s'impose pour suivre ce RFC (section 1.1) :

- Domaine de routage BGP SPF : un ensemble de routeurs sous la même administration (cf. section 10.1) qui échangent de l'information sur l'état des liens via BGP, et calculent la table de routage avec SPF.

- NLRI (Network Layer Reachability Information) BGP-LS-SPF (LS = Link State, état des liens) : les NLRI (RFC 4271, section 3.1) sont les données envoyées dans les messages BGP. Ce type particulier de NLRI sert à transmettre les informations sur l'état des liens. Il a le numéro 80 et est encodé exactement comme le NLRI BGP-LS (tout court) du RFC 9552.

- Algorithme de Dijkstra : un autre nom de SPF (Shortest Path First), la grande nouveauté de notre RFC.

Bon, maintenant, le protocole lui-même. C'est bien sûr le bon vieux BGP du RFC 4271, avec l'extension LS du RFC 9552 et « juste » en plus l'utilisation de SPF pour le mécanisme de décision (« quelle route choisir ? »). Autrement, le RFC insiste, c'est du BGP normal, avec son automate, son format de paquets, ses signalements d'erreurs (RFC 7606), etc. Du fait du nouveau mécanisme de décision, les attributs optionnels des chemins annoncés n'ont pas à être transmis (les attributs obligatoires, comme leur nom l'indique, sont toujours transmis, même si SPF ne les utilise pas). Comme le calcul des routes se fait sur la base de l'information sur l'état des liens, un routeur BGP-LS-SPF n'attend pas d'avoir fait son calcul local avant de transmettre une annonce, il envoie tout (section 2). Le traditionnel mécanisme de décision de BGP (celui de la section 9.1 du RFC 4271) disparait et est remplacé par celui décrit en section 6. Cela implique, entre autres, que le chemin d'AS n'est plus utilisé pour empêcher les boucles.

On l'a dit, BGP-LS-SPF s'appuie sur le BGP-LS du RFC 9552 mais, avec un nouveau SAFI (Subsequent Address Family Identifier), le 80, puisque le SAFI du RFC 9552 supposait le processus de décision traditionnel de BGP (SPF ne doit être utilisé qu'avec les informations obtenues via les NLRI BGP-LS-SPF, cf. section 5.1). Par contre, les autres paramètres de BGP-LS sont utilisés tels quels (section 5.1.1). Il y a aussi des ajouts, par exemple pour indiquer qu'un lien ou un préfixe doit être considéré comme inutilisable par BGP-LS-SPF.

Les messages peuvent être gros, vu qu'on doit transporter l'information au sujet de tout le domaine de routage. Il est donc recommandé de mettre en œuvre le RFC 8654, qui permet d'avoir des messages BGP de plus de 4 096 octets.

La section 4 du RFC explique comment s'appairer pour échanger des informations sur les états des liens. En gros, rien de spécial, appairage direct ou passage par un réflecteur (RFC 4456) sont possibles comme avant.

L'article seul

RFC 9910: Registration Data Access Protocol (RDAP) Regional Internet Registry (RIR) Search

Date de publication du RFC : Janvier 2026

Auteur(s) du RFC : T. Harrison (APNIC), J. Singh (ARIN)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF regext

Première rédaction de cet article le 8 janvier 2026

Le protocole RDAP, successeur de whois, n'est pas utilisé que par les registres de noms de domaine. Il sert aussi chez les RIR, pour obtenir des informations sur les entités qui sont derrière une adresse IP (ou un AS). RDAP dispose dès le début de fonctions de recherche (regardez le RFC 9082) mais ce nouveau RFC ajoute des choses en plus.

Traditionnellement, les serveurs whois des RIR disposaient de fonction de recherche « avancées » comme la possibilité de chercher par valeur (« quels sont tous les préfixes IP de tel titulaire ? »). L'idée de ce RFC est de permettre la même chose en RDAP. RDAP de base permet les recherches des informations associées à une adresse IP :

% curl -s https://rdap.db.ripe.net/ip/2001:41d0:302:2200::180 | jq .

{

"handle": "2001:41d0::/32",

"name": "FR-OVH-20041115",

"country": "FR",

"parentHandle": "2001:4000::/23",

…

"status": [

"active"

],

"entities": [

{

"handle": "OK217-RIPE",

…

"text",

"Octave Klaba"

…

En plus de ip, ce RFC ajoute

ips (section 2.1) qui permet une recherche sur

tous les préfixes dont le nom correspond à un certain motif (ici,

tous ceux d'OVH) :

% curl -s https://rdap.db.ripe.net/ips\?name="FR-OVH-*" | jq '.ipSearchResults.[].handle' "109.190.0.0 - 109.190.255.255" "135.125.0.0 - 135.125.255.255" "137.74.0.0 - 137.74.255.255" "141.94.0.0 - 141.95.255.255" "145.239.0.0 - 145.239.255.255" "147.135.128.0 - 147.135.255.255" "149.202.0.0 - 149.202.255.255" "152.228.128.0 - 152.228.255.255" "159.173.0.0 - 159.173.255.255" "162.19.0.0 - 162.19.255.255" …

J'ai utilisé ici curl et jq mais, évidemment, l'avantage de RDAP est que vous pouvez utiliser un client dédié ou bien n'importe quel logiciel qui sait faire du HTTP et du JSON (voyez plus loin un exemple en Python).

Et chez un autre RIR :

% curl -s https://rdap.arin.net/registry/ips\?name='CLOUDFLARE*' | \

jq '.ipSearchResults.[].handle'

"NET-104-16-0-0-1"

"NET-108-162-192-0-1"

"NET-156-146-101-152-1"

"NET-162-158-0-0-1"

"NET-172-64-0-0-1"

"NET-173-245-48-0-1"

"NET-198-41-128-0-1"

"NET-199-27-128-0-1"

"NET6-2606-4700-1"

De la même façon, vous pouvez chercher par numéro d'AS :

% curl -s https://rdap.db.ripe.net/autnums\?name="*NIC-FR*" | \

jq '.autnumSearchResults.[].handle'

"AS2483"

"AS2484"

"AS2485"

"AS2486"

La section 3 décrit ensuite des moyens de trouver les objets parents et enfants (puisque l'allocation des adresses IP est hiérarchique, toute adresse est dans un préfixe plus général et contient des préfixes plus spécifiques, cf. la section 3.2.1 du RFC) :

% curl -s https://rdap.db.ripe.net/ips/rirSearch1/rdap-up/2001:41d0:302:2200::180 | \

jq '.handle'

"2001:41d0::/32"

% curl -s https://rdap.db.ripe.net/ips/rirSearch1/rdap-down/2001:4000::/23 | \

jq '.ipSearchResults.[].handle'

"2001:4000::/32"

"2001:4010::/32"

"2001:4018::/29"

"2001:4020::/32"

…

Notez la relation (rdap-up et

rdap-down). Notez aussi que

rdap-up renvoie au maximum un objet alors que

rdap-down peut en renvoyer plusieurs

(cf. section 4.2), et c'est pour cela qu'il a fallu itérer en jq (le

.[] parcourt le tableau). Quant au

rirSearch1, le 1 indique la version de cette

extension de recherche chez les RIR (désormais enregistrée

à l'IANA).

Et en Python, ça donnerait :

#!/usr/bin/python

# Example of using search extensions to RDAP (RFC 9910)

# https://requests.readthedocs.io

import requests

# Standard library

import json

import sys

# Yes, we should use the registry documented in RFC 7484…

BASE_URL = "https://rdap.db.ripe.net/ips/rirSearch1/rdap-down"

if len(sys.argv) != 2:

raise Exception("Usage: %s ip-prefix-at-ripe" % sys.argv[0])

arg = sys.argv[1]

response = requests.get("%s/%s" % (BASE_URL, arg))

if response.status_code != 200:

raise Exception("Wrong HTTP return code from %s: %s" % (BASE_URL, response.status_code))

data = json.loads(response.text)

for prefix in data["ipSearchResults"]:

print(prefix["handle"])

Et les recherches inverses, telles que décrites dans le RFC 9536 ? La section 5 du RFC les présente et voici un exemple qui marche (trouver tous les préfixes de Webflow) :

% curl -s 'https://rdap.arin.net/registry/ips/reverse_search/entity?handle=WEBFL' | \

jq '.ipSearchResults.[].handle'

"NET-198-202-211-0-1"

"NET6-2620-CB-2000-1"

Un serveur RDAP qui gère les extensions de ce RFC doit le signaler dans ses réponses (section 6) :

…

"rdapConformance" : [ "geofeed1", "rirSearch1", "ips", "cidr0",

"rdap_level_0", "nro_rdap_profile_0", "redacted" ],

…

Mais aussi dans les liens donnés dans les réponses (ici, en réponse

à une requête traditionnelle ip) :

"links": [

{

"value": "https://rdap.db.ripe.net/ip/2001:41d0:302:2200::180",

"rel": "rdap-up",

"href": "https://rdap.db.ripe.net/ips/rirSearch1/rdap-up/2001:41d0::/32",

"type": "application/rdap+json"

},

Et bien sûr dans les réponses d'aide :

% curl -s https://rdap.arin.net/registry/help

{

"rdapConformance" : [ "nro_rdap_profile_0", "rdap_level_0", "cidr0", "nro_rdap_profile_asn_flat_0", "arin_originas0", "rirSearch1", "ips", "ipSearchResults", "autnums", "autnumSearchResults", "reverse_search" ],

"notices" : [ {

"title" : "Terms of Service",

"description" : [ "By using the ARIN RDAP/Whois service, you are agreeing to the RDAP/Whois Terms of Use" ],

"links" : [ {

"value" : "https://rdap.arin.net/registry/help",

"rel" : "terms-of-service",

"type" : "text/html",

"href" : "https://www.arin.net/resources/registry/whois/tou/"

} ]

…

Les fonctions de recherche, c'est très bien mais c'est, par construction, indiscret. La section 8 de notre RFC détaille les risques de ces extensions de recherche pour la vie privée (relire le RFC 7481 est une bonne idée).

Les extensions de ce RFC, rirSearch1,

ips, autnums,

ipSearchResults et

autnumSearchResults ont été enregistrées

à l'IANA (section 10 du RFC). Les relations

rdap-up, rdap-down,

rdap-top et rdap-bottom

sont dans le registre

des liens (RFC 8288). Et le registre

des recherches inverses inclut désormais

fn, handle,

email et role, avec leur

correspondance en JSONPath.

Et question mise en œuvre et déploiement, on a quoi ? ARIN et RIPE ont annoncé avoir programmé les extensions de ce RFC mais elles ne sont pas forcément accessibles via le serveur RDAP public, entre autre pour les raisons de vie privée discutées dans la section 8. Aujourd'hui, comme vous le voyez dans les exemples ci-dessus, au moins ARIN et RIPE rendent une partie de ces extensions utilisables.

L'article seul

Quel risque que des satellites se tamponnent ?

Première rédaction de cet article le 12 décembre 2025

Il y a beaucoup, mais vraiment beaucoup, de satellites au-dessus de nos têtes, notamment sur les orbites basses. Risquent-ils de se tamponner ? Oui, montre cette étude : en l'absence de réaction de leurs opérateurs, il y aurait une collision tous les 2,8 jours.

Le risque de collision entre satellites est connu depuis longtemps. Le cas le plus fameux est bien sûr la collision du 10 février 2009 (cf. le bilan récent « Subsequent Assessment of the Collision between Iridium 33 and COSMOS 2251 »). Les conséquences d'un choc direct sont évidemment la destruction des deux satellites mais le principal problème est surtout la nuée de débris ainsi créée, et les nombreuses collisions secondaires qu'elle peut entrainer. En cas d'éparpillement des satellites impliqués, l'orbite peut devenir inutilisable.

Mais l'espace est grand et un satellite est petit, non ? Les collisions devraient être rares. Ce serait le cas s'il y avait peu de satellites. Mais de nos jours, avec les méga-constellations, le nombre de satellites est tel que la probabilité de collision a sérieusement augmenté. Et puis un satellite en orbite basse fait beaucoup de tours de la Terre, augmentant le risque. C'est comme jouer à la roulette russe en essayant souvent.

Peut-on quantifier ce risque ? C'est ce que tente l'article « An Orbital House of Cards: Frequent Megaconstellation Close Conjunctions ». Les auteurices ont développé un indice, spirituellement appelé « CRASH clock » (pour Collision Realization And Significant Harm), exprimé sous forme d'une durée, et qui indique l'intervalle moyen entre collisions. Je vous laisse lire l'article pour les détails du calcul (comme toutes les modélisations, c'est compliqué et certains facteurs ne sont pas connus avec précision). Mais ce qui est inquiétant est le résultat : le CRASH clock qui était de 121 jours avant l'arrivée des méga-constellations est descendu à 2,8 jours, en grande partie grâce à Starlink.

Bon mais, en pratique, on ne voit pas de collision tous les 2,8 jours, non ? C'est parce que les opérateurs des satellites surveillent les environs et actionnent de temps en temps les moteurs pour s'éloigner d'un risque de collision. On ne voit donc pas souvent d'accident. Le risque est qu'un événement survienne qui empêche ces réactions pendant quelques jours. Les auteurices imaginent un problème logiciel important chez un des opérateurs, voire sur plusieurs, ou bien une crise socio-politique importante sur Terre, ou tout simplement une tempête solaire, qui pourrait perturber les communications pendant une durée significative par rapport au CRASH clock. (Le risque des tempêtes solaires n'est pas purement théorique.) Le CRASH clock indique donc ce qui se passerait lors d'un de ces événements. Les opérateurs de satellites ne peuvent pas se permettre une interruption de leur travail, même de seulement quelques heures.

En français, vous serez peut-être intéressé par cet article du CNES.

L'article seul

RFC 9824: Compact Denial of Existence in DNSSEC

Date de publication du RFC : Septembre 2025

Auteur(s) du RFC : S. Huque (Salesforce), C. Elmerot

(Cloudflare), O. Gudmundsson

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF dnsop

Première rédaction de cet article le 12 décembre 2025

Plus fort que le chat de Schrödinger qui était à la fois mort et vivant, ce RFC permet à un nom de domaine d'être à la fois existant et non-existant. Plus précisément, il permet de fournir une preuve cryptographique avec DNSSEC, prouvant que le nom existe (alors qu'il n'existe pas) mais n'a pas les données demandées. Cette technique (autrefois connue sous le nom de « black lies », et largement déployée) est particulièrement adaptée au cas des signatures générées dynamiquement, mais a l'inconvénient de « mentir » sur l'existence du nom.

Pour comprendre, il faut revenir à un problème agaçant pour

DNSSEC : le déni d'existence. Ce terme

désigne le fait de prouver qu'un nom, ou qu'un certain type de

données pour un nom, n'existe pas. Car DNSSEC fonctionne en

signant les données. Mais en

cas de non-existence, il n'y a rien à signer. DNSSEC a donc ajouté

un type d'enregistrement nommé NSEC qui encadre le nom manquant. Et

ces enregistrements, eux, sont signés. Un enregistrement NSEC affirme

« ce nom n'existe pas » en donnant le nom précédent et le nom

suivant (ici, la réponse d'un serveur racine

à qui on a demandé www.trump alors que le

TLD

.trump n'existe pas) :

;; ->>HEADER<<- opcode: QUERY, status: NXDOMAIN, id: 65362 ;; flags: qr aa rd; QUERY: 1, ANSWER: 0, AUTHORITY: 6, ADDITIONAL: 1 … travelersinsurance. 86400 IN NSEC trust. NS DS RRSIG NSEC

On obtient un NXDOMAIN (ce nom n'existe pas), zéro réponse (la

section Answer est vide) et l'enregistrement NSEC nous dit qu'il n'y

a rien entre travelersinsurance et

trust. Comme il est signé (je n'ai pas montré

les signatures), nous avons une preuve de non-existence.

Et si le nom existe, mais n'a pas de données du type

demandé ? J'interroge mon résolveur sur la localisation

associée au nom www.iis.se :

% dig +dnssec www.iis.se LOC … ;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 39872 ;; flags: qr rd ra ad; QUERY: 1, ANSWER: 0, AUTHORITY: 4, ADDITIONAL: 1 … www.iis.se. 480 IN NSEC xmpp01.iis.se. A AAAA RRSIG NSEC …

Le NOERROR est normal (le nom existe) mais la section Answer est

vide (puisqu'il n'y a pas d'enregistrement de type LOC) et le NSEC

nous dit que le nom existe bien (le nom suivant étant

xmpp01.iis.se.) mais n'a comme type

d'enregistrement que A, AAAA, RRSIG et NSEC. On a donc prouvé que le

LOC n'existe pas.

Bon, tout ça, c'est du DNSSEC classique, tel que normalisé dans les RFC 4034 et RFC 4035. Ça marche, mais cela a des inconvénients, notamment pour les signatures générées dynamiquement. Cela nécessite plusieurs NSEC (il faut aussi montrer qu'il n'y a pas de joker), avec leurs signatures.

CDE (Compact Denial of Existence, alias

black lies) fonctionne (section 3 du RFC) en

calculant un intervalle minimal entre les noms, comme le faisaient

les white lies du RFC 4470. Mais, contrairement à eux, CDE fait partir cet

intervalle du nom demandé. Par exemple, si on demande

foobar.example et que ce nom n'existe pas, les

white lies fabriqueront un NSEC allant de

~.foobaq~.example à

foobar!.example alors que les black

lies de notre RFC feront un NSEC allant de

foobar.example à

\000.foobar.example. Cet intervalle démarrant

au nom de domaine demandé, il ne faut plus jamais renvoyer de

NXDOMAIN, uniquement des NODATA (NOERROR mais avec une section

Answer vide).

Voici un exemple de black lie chez Cloudflare (qui a déployé CDE il y a longtemps) :

% dig +dnssec doesnotexistcertainly.cloudflare.com … ;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 43853 ;; flags: qr rd ra ad; QUERY: 1, ANSWER: 0, AUTHORITY: 4, ADDITIONAL: 1 … ;; AUTHORITY SECTION: doesnotexistcertainly.cloudflare.com. 300 IN NSEC \000.doesnotexistcertainly.cloudflare.com. RRSIG NSEC TYPE128 … ;; Query time: 14 msec ;; SERVER: 192.168.2.254#53(192.168.2.254) (UDP) ;; WHEN: Fri Dec 12 14:10:39 CET 2025 ;; MSG SIZE rcvd: 400

Mais puisqu'on ne renvoie jamais de NXDOMAIN, comment distinguer

un nom qui n'existe pas d'un nom qui n'a simplement pas le type

demandé ? La section 2 du RFC présente le type NXNAME (enregistré avec le numéro 128, d'où le TYPE128

ci-dessus). Sa présence dans le NSEC indique que le nom n'existe

pas. Comparez la réponse ci-dessus avec celle-ci, où le nom existe,

mais pas le type (hex.pm

est chez

Cloudflare et n'a pas d'adresse

IPv6 associée à son nom) :

% dig +dnssec hex.pm AAAA … ;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 5431 ;; flags: qr aa rd; QUERY: 1, ANSWER: 0, AUTHORITY: 4, ADDITIONAL: 1 … hex.pm. 1800 IN NSEC \000.hex.pm. A NS SOA HINFO MX TXT LOC SRV NAPTR CERT SSHFP RRSIG NSEC DNSKEY TLSA SMIMEA HIP CDS CDNSKEY OPENPGPKEY SVCB HTTPS URI CAA

La longue liste de types dans le NSEC (mais sans le NXNAME/TYPE128) est due au fait que le serveur, qui génère des NSEC (et des signatures) dynamiquement ne connait pas la vraie liste donc il met tout ce qu'il connait.

Un résolveur qui connait les NXNAME peut donc refabriquer un code de retour NXDOMAIN et l'envoyer à ses clients (section 5 du RFC). Un nouveau booléen dans la question envoyée aux serveurs faisant autorité, le CO (Compact Answers OK) peut être utilisé pour dire au serveur faisant autorité qu'il peut répondre avec un NXDOMAIN, le client DNS qui met le CO indique qu'il saura lire et interpréter le NXNAME. (Le CO a été enregistré à l'IANA, le premier booléen d'une requête EDNS à être enregistré depuis DO il y a vingt-quatre ans.) Cette possibilité de rétablissement du NXDOMAIN ne semble pas très souvent mise en œuvre actuellement.

Notez (section 4) qu'on peut utiliser CDE avec NSEC3 mais que cela n'a aucun intérêt, vu que la compacité de l'intervalle des noms empêche déjà l'énumération des noms.

Enfin, si vous aimez les détails, l'annexe A du RFC discute des raisons des choix faits, et des alternatives étudiées (et même testées dans la nature), mais non retenues.

CDE est largement déployé aujourd'hui, notamment chez Cloudflare,

déjà cité, mais aussi chez d'autres hébergeurs utilisant la

signature dynamique, comme NS1. En logiciel libre, Knot permet le CDE. Il y a

aussi une implémentation (mais qui n'a pas été maintenue

synchrone avec le RFC) dans mon serveur Drink. Elle fut

développée lors d'un hackathon

IETF. Elle n'est pas activée par défaut, il faut changer un

paramètre dans le source (lib/drink/dnssec.ex).

L'article seul

RFC 9868: Transport Options for UDP

Date de publication du RFC : Octobre 2025

Auteur(s) du RFC : J. Touch, C. Heard

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF tsvwg

Première rédaction de cet article le 5 décembre 2025

Des protocoles de transport, comme TCP, ont le concept d'options, ajoutées à l'en-tête et permettant de régler divers paramètres. Ce RFC ajoute ce concept à UDP et standardise quelques options. Désormais, il y a des moyens standards de faire du « ping » en UDP.

Mais comment ajouter des options à un vénérable protocole (UDP a été normalisé en 1980, dans le RFC 768), qui n'a pas de place pour cela dans son en-tête très minimal ? L'astuce est que UDP indique une taille de paquet qui peut être différente de celle indiquée par IP. Si elle est supérieure, les octets ainsi disponibles peuvent stocker des options, à la fin du paquet. Ce sera donc un pied (trailer) et pas un en-tête.

Voici un paquet UDP simplifié (j'ai aussi mis une partie de l'en-tête IP) analysé par tshark :

Internet Protocol Version 6, Src: 2a04:cec0:10fc:5bd8:efd1:79bb:7356:4583, Dst: 2001:db8::1

0110 .... = Version: 6

…

Payload Length: 56

Next Header: UDP (17)

Hop Limit: 64

Source Address: 2a04:cec0:10fc:5bd8:efd1:79bb:7356:4583

Destination Address: 2001:db8::1

User Datagram Protocol, Src Port: 57560 (57560), Dst Port: domain (53)

Source Port: 57560 (57560)

Destination Port: domain (53)

Length: 56

…

UDP payload (48 bytes)

Vous avez vu ? Il y a deux champs qui indiquent la longueur du paquet UDP, un dans l'en-tête IP (Payload length) et un dans l'en-tête UDP (Length). Ici, les deux sont identiques, ce qui est le cas « normal ». Mais s'ils sont différents ? C'est le point de départ de ce RFC. Les options se nicheront dans la différence entre la longueur du paquet UDP et celle du paquet IP qui l'encapsule, dans une zone connue sous le nom de surplus (surplus area). Normalement, elles seront ainsi ignorées de tous les vieux programmes (mais il y a parfois eu des bogues).

Comme TCP (RFC 9293), les protocoles de transport SCTP (RFC 9260) et DCCP (RFC 4340) ont dans leur en-tête un espace réservé pour d'éventuelles options. Pas UDP. C'est ce manque que comble notre RFC. Comme UDP est un protocole sans connexion, ces options ne serviront que pour un seul paquet (alors que TCP peut les garder pour toute la connexion). Des options, dans les autres protocoles de transport, il y en a plein. Pour TCP, le RFC cite par exemple, la dilatation de fenêtres (RFC 7323), l'authentification (RFC 5925) et d'autres. On en trouve pour des protocoles avec état (comme TCP, où elles vont s'appliquer à toute la connexion) ou sans état (comme IP, où elles ne s'appliquent qu'au paquet qui les porte). Comme vu plus haut, seul UDP (RFC 768) n'avait pas le moyen d'ajouter des options.

À quoi vont servir ces options (section 5 du RFC) ? À court

terme, à permettre des mécanismes de

fragmentation, de test (« ping UDP »), etc. À

plus long terme (mais ce n'est pas encore normalisé), elles rendront

possible d'ajouter de l'authentification ou

du chiffrement à UDP (DTLS, RFC 9147 chiffre mais ne protège pas l'en-tête de

la couche Transport). On pourra aussi faire de la découverte de la

MTU du

chemin, comme spécifié dans le RFC 9869. Et enfin, cela

pourra permettre d'augmenter la taille des paquets DNS comme proposé dans

draft-heard-dnsop-udp-opt-large-dns-responses.

La section 6 du RFC spécifie le cahier des charges de ces options UDP :

- UDP est sans état (sans connexion) et doit le rester.

- UDP est unidirectionnel et doit le rester. Les protocoles requête/réponse (comme le DNS) sont bâtis sur UDP mais doivent s'occuper de faire correspondre requêtes et réponses sans l'aide d'UDP.

- Les options UDP n'ont pas de taille maximale (à part celle du paquet UDP lui-même, 65 536 octets).

- Les options UDP ne visent pas à remplacer des protocoles existants. Le « ping UDP » ne cherche pas à être équivalent au ping utilisant ICMP. Après tout, UDP est fait pour être minimal, et il doit le rester.

- Les options UDP ne constituent pas un protocole à elles seules : un protocole situé au-dessus d'UDP va devoir spécifier bien des détails (par exemple le RFC 9869 qui décrit le protocole PLPMTUD).

- Tout le mécanisme est conçu pour qu'un logiciel ancien, qui ne connaisse pas ces options, fonctionne comme aujourd'hui.

Un peu de terminologie avant d'attaquer les détails, notamment (section 3) :

- Option sûre (SAFE option) : option qui pourra être ignorée par un receveur qui ne la comprend pas. Elle ne modifie pas la compréhension du paquet.

- Option non sûre (UNSAFE option) : option qui ne doit pas être ignorée, car elle modifie la compréhension du paquet (par exemple car elle indique qu'il est chiffré).

La description technique de l'emplacement des options figure en section 7 du RFC. Le champ Longueur de l'en-tête UDP, qui a toujours été redondant avec celui d'IP, peut désormais prendre une valeur inférieure à celle du champ dans IP (mais supérieure à huit, la taille de l'en-tête UDP). La différence entre les deux longueurs est la taille du surplus, la zone à la fin du paquet où se logent les options (qui ne sont donc pas dans l'en-être mais dans le pied). Notez qu'il n'y a pas d'obligation que le surplus soit aligné sur des multiples (2 ou 4) d'octets. Si les longueurs IP et UDP sont identiques, c'est qu'il n'y a pas d'options.

La structuration du surplus en options est dans la section 8. Le surplus commence avec un champ de deux octets qui est une somme de contrôle. Cet OCS (Option CheckSum) est une somme de contrôle Internet traditionnelle (RFC 791, section 3.1, et RFC 1071). Pourquoi cette somme de contrôle alors qu'UDP en a déjà une ? Pour détecter les cas où un autre mécanisme jouerait avec la différence des champs Longueur d'IP et d'UDP et aurait son propre pied, distinct de celui normalisé dans notre RFC. Simple somme de contrôle, l'OCS ne joue pas un rôle en sécurité, il ne sert qu'à vérifier que le surplus est bien utilisé conformément à la norme sur les options UDP. (Les options sont ignorées si l'OCS n'est pas correcte, voir la section 14.) La section 18 insiste sur ce point : comme cette distinction entre deux champs Longueur est ancienne, il est possible que certains s'en servaient et il faut donc faire face à la possibilité que des paquets UDP aient des champs Longueur différents sans pour autant avoir des options telles que normalisées ici. L'OCS est donc aussi une sorte de nombre magique mais en plus fort, puisqu'il n'est pas statique.

Comme toujours, il faut prévoir le cas de middleboxes boguées qui calculeraient la somme de contrôle UDP sur tout le paquet IP, au lieu de s'arrêter à la longueur indiquée dans l'en-tête UDP. L'OCS est conçu pour annuler l'effet d'une telle bogue (merveille des sommes de contrôle, qui n'ont pas de dispersion des résultats). La somme de contrôle UDP étant optionnelle (mais c'est évidemment très déconseillé), l'OCS l'est aussi (et peut donc valoir zéro). Rappelez-vous que ce qui marchait avant en UDP doit encore marcher avec les options donc, par défaut, même si l'OCS est incorrect, le paquet doit être transmis aux applications réceptrices.

À propos de middleboxes, le RFC précise aussi (section 16) que les options sont de bout en bout et ne doivent pas être modifiées par les équipements intermédiaires (mais cela risque de rester un vœu pieux). Des tests effectués ont montré que des systèmes d'exploitation courants (Linux, macOS, Windows) n'avaient pas de problème en recevant des paquets UDP contenant des options (section 18). Ils n'envoient à l'application que la partie du paquet indiquée par le champ Longueur d'UDP, et ignorent donc les options, qu'on peut donc envoyer sans craindre de perturber les systèmes pré-existants. Toutefois, au moins un objet connecté (non nommé par le RFC) passe tout le datagramme (y compris, donc, le surplus contenant les options) à l'application. Et au moins un IDS, l'Alcatel-Lucent Brick considère les paquets UDP ayant des options comme des attaques (les IDS sont un des facteurs importants de l'ossification de l'Internet car ils interprètent tout ce qui ne colle pas à leur vision étroite comme une attaque).

Les options suivent la somme de contrôle et la plupart sont encodées selon un classique schéma TLV, comme pour la plupart des options TCP (RFC 9293, section 3.1). Les deux exceptions à cet encodage TLV sont les options NOP (un seul octet, qui vaut un, cette option, comme son nom l'indique, ne sert à rien, à part éventuellement à aligner les données) et EOL (End Of Options, un seul octet, qui vaut zéro, elle indique la fin de la liste d'options). Autrement, les options sont en TLV, le premier octet indiquant le type, la longueur faisant un octet (un mécanisme existe pour des options faisant plus de 255 octets). Les options sûres ont un type de 0 à 191, les autres sont non sûres. Parmi les options sûres enregistrées par notre RFC, outre EOL et NOP, on trouve entre autres (section 11) :

- APC (Additional Payload Checksum), type 2, qui ajoute une somme de contrôle plus forte (CRC32c, la même que celle utilisée dans iSCSI, RFC 3385 et SCTP).

- FRAG (Fragmentation), type 3, qui permet une fragmentation au niveau UDP. Peut se combiner avec MDS (Maximum Datagram Size, type 4), qui indique la taille maximale qu'un récepteur peut accepter sans que le datagramme soit fragmenté.

- REQ (Echo Request, type 6) et RES (Echo Response, type 7) permettent de faire un « ping UDP ». (Plus propre que les trucs abusivement baptisés « ping UDP » comme cet exemple ou celui-ci.)

- TIME, type 8, permet d'envoyer et de recevoir l'heure, sous forme d'une estampille temporelle de quatre octets. C'est l'analogue de l'option TCP Timestamp (RFC 7323, section 3). UDP ne garantit pas que ces estampilles correspondent à l'heure officielle, juste qu'elles seront monotones (toujours croissantes).

- AUTH (Authentication), n'est pas

réellement spécifiée. Son type, 9, est réservé mais les autres

points sont repoussés à un futur RFC, peut-être à partir de

l'Internet-Draft

draft-touch-tsvwg-udp-auth-opt.

Les options EOL, NOP et quelques autres doivent normalement être reconnues par toutes les mises en œuvres des options UDP (cf. section 14).

Et les options non sûres ? Rappelons que ce sont celles qui modifient l'interprétation du contenu du paquet. On y trouve (section 12 du RFC) entre autres :

- UCMP (Unsafe Compression), type 192, pour des contenus comprimés.

- UENC (Unsafe Encryption), type 193, pour des contenus chiffrés.

Ces deux options ne sont pas autrement spécifiées, seul un type est réservé. Le reste devra être précisé dans un RFC ultérieur.

De nouvelles options seront peut-être rajoutées dans le futur au registre des options (section 13 du RFC). La politique IANA (section 26) est « action de normalisation » ou « approbation par l'IESG », donc des procédures assez lourdes (RFC 8126) : il ne sera pas facile d'ajouter des options.

Question mise en œuvre, ce n'est pas forcément trivial à faire soi-même. Pour pouvoir lire et à plus forte raison écrire des options UDP, il faut actuellement court-circuiter UDP et écrire directement au-dessus d'IP (raw sockets) ou pire, dans certains cas, directement sur le réseau. Notre RFC propose des extensions à l'API socket pour lire et écrire les options (avec aussi des variables sysctl) mais je ne connais pas encore de système d'exploitation qui les intègre. Notez que ces API ne permettent pas d'influencer l'ordre des options, et c'est exprès.

Une difficulté supplémentaire vient du fait qu'UDP est sans état, sans connexion. D'une part, les options ne peuvent pas être négociées lors de l'établissement de la connexion (puisqu'il n'y a pas de connexion), d'autre part, elles doivent être répétées dans chaque paquet (puisqu'il n'y a pas d'état). Le RFC précise donc (section 19) qu'il faut ignorer les options qu'on ne connait pas (du moins celles marquées comme sûres). D'autre part il impose qu'on passe les données à l'application même si on ne comprend pas les options. Ah, et aussi, les options UDP sont conçues pour l'unicast essentiellement.

Et leurs conséquences pour la sécurité (section 25 du RFC) ? Fondamentalement, les options UDP ne posent pas plus (ou pas moins…) de problèmes de sécurité que les options TCP, qui sont normalisées depuis longtemps. Comme pour TCP, elles ne sont pas sécurisées par TLS (ici, DTLS, RFC 9147), TLS qui protège uniquement les données applicatives. Si vous voulez les protéger, il faudra attendre la spécification des futures options AUTH (qui fournira à peu près le même service que le AO de TCP, normalisé dans le RFC 5925) et UENC. Ou alors, protégez toute la couche transport avec IPsec (RFC 4301).

Mais il y a un autre danger, dans la façon dont vont être traitées les options UDP par le récepteur. Si celui-ci boucle imprudemment, en attendant juste l'option EOL, le risque de débordement est élevé. Ou si le récepteur alloue de la mémoire en utilisant le champ Longueur d'UDP puis y copie tout le paquet, les options faisant alors déborder son tampon.

Voilà, je n'ai pas tout détaillé, la section 25 est longue, lisez-la.

Un petit point d'histoire (section 4) : pourquoi diable UDP a-t-il ce champ Longueur, alors que celui d'IP suffisait, d'autant plus que l'en-tête UDP est de taille fixe ? Aucun autre protocole de transport ne fait cela (à part peut-être Teredo, RFC 6081). Le RFC note que des historiens de l'Internet ont été consultés mais sans résultat. Les raisons de ce choix (qu'on apprécie aujourd'hui mais qui est resté sans utilité pratique pendant 45 ans) restent mystérieuses. Permettre de placer plusieurs paquets UDP dans un seul datagramme IP ? Pour remplir les paquets de manière à ce qu'ils soient alignés sur des multiples d'octets ? Aucune explication ne semble satisfaisante et les archives sont muettes.

Notez aussi que d'autres propositions avaient été faites pour

ajouter des options à UDP, comme celle décrite dans

l'Internet Draft

draft-hildebrand-spud-prototype.

Autre question que vous vous posez peut-être : et UDP-Lite (RFC 3828) ? Lui aussi jouait avec la différence des champs Longueur d'IP et d'UDP, pour indiquer la partie du paquet couverte par la somme de contrôle. De ce fait, le mécanisme d'options ne peut pas être utilisé pour UDP-Lite (section 17).

Et les mises en œuvre concrètes ? Il n'existe pas, à ma connaissance, de serveurs de test publics sur l'Internet. Mais vous avez une liste des programmes existants (je n'en ai pas vu en Python utilisant Scapy, ce qui serait pourtant une expérience intéressante).

D'autres lectures sur ces options UDP ? Vous avez l'article de Raffaele Zullo et les supports d'un de ses exposés, qui expliquent bien la question. Et, sinon ChatGPT, consulté s'en ne s'en est pas trop mal tiré, inventant un mécanisme qui ressemble à celui de TCP.

L'article seul

Fletcher, l'outil de dessin de schémas de Typst

Première rédaction de cet article le 1 décembre 2025

Vous le savez, j'ai expérimenté récemment l'outil de formatage de textes Typst. Un de ses intérêts est de disposer d'un langage pour réaliser des schémas, nommé Fletcher. Voici quelques points intéressants de Fletcher.

Fletcher est sur le même créneau que des systèmes comme Asymptote (que j'utilise jusqu'à présent), Graphviz ou TikZ : un langage pour décrire les schémas techniques, qui évite de passer du temps avec la souris en essayant de placer ses éléments de schémas au bon endroit. Fletcher est écrit avec le langage de programmation de Typst, et s'appuie sur le système CeTZ.

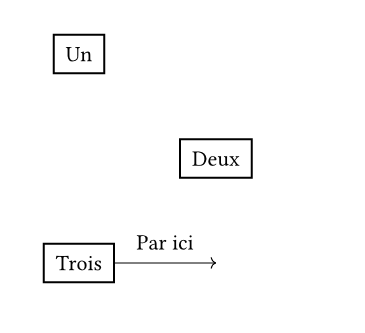

Sans plus tarder, un exemple de code en Fletcher :

#import "@preview/fletcher:0.5.8" as fletcher: diagram, node, edge

#diagram(

{

node([Un], stroke: 1pt)

node((rel: (1, 1)), [Deux], stroke: 1pt)

node((rel: (-1, 1)), [Trois], stroke: 1pt)

edge(auto, auto, [Par ici], "->")

}

)

Compilé avec typst compile --format png

simple-fletcher-1.typ, il donne :

Voyons les détails :

- Il faut importer le paquetage Fletcher (il sera téléchargé la première fois qu'on compile).

- On dessine trois boites ; par défaut, la bordure est de taille nulle donc on demande une bordure d'un point.

- La première boite est, par défaut, placée à l'origine des coordonnées, les deux suivantes sont placées relativement à la boite précédente (l'axe des X va vers la droite, celui des Y vers le bas, ce qui est un peu déconcertant mais c'est documenté).

- On termine avec une flèche, sans s'embêter à indiquer où elle s'accroche donc elle est mise sur le dernier élément dessiné. Notez la façon d'indiquer la forme de la flèche, avec un exemple sous forme d'une chaine de caractères.

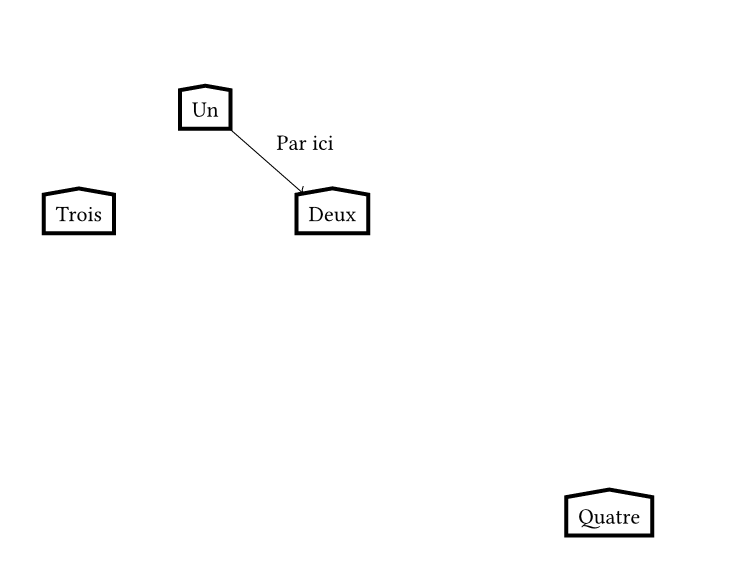

Maintenant, si on veut davantage de contrôle sur le placement, on va donner des noms aux objets (et puis on met des valeurs par défaut pour les boites) :

#import "@preview/fletcher:0.5.8" as fletcher: diagram, node, edge

#diagram(

// Valeurs par défaut pour les nœuds

node-stroke: 2pt,

node-shape: fletcher.shapes.house,

{

node([Un], name: <un>)

node((rel: (1, 1)), [Deux], name: <deux>)

node((rel: (-1, 1), to: <un>), [Trois], name: <trois>)

node((rel: (3, 4), to: <deux>), [Quatre], name: <quatre>)

edge(<un>, <deux>, [Par ici], "->")

}

)

Et cela donne :

Vous noterez, dans le deuxième essai :

- La boite Trois est désormais relative à la boite Un, pas à la dernière boite placée.

- L'image s'agrandit automatiquement (regardez la boite Quatre, qui est placée assez loin).

- La flèche est explicitement accrochée à deux des boites, et placée automatiquement au bon endroit.

Pour un exemple plus réaliste, je vous ai mis un schéma de la

résolution DNS et

un autre de l'arborescence des noms

de domaine, avec le PDF (ce que produit Typst par défaut) et le

source : fletcher-resolution-dns.pdf, fletcher-resolution-dns.typ, fletcher-arbre-domaines.pdf et fletcher-arbre-domaines.typ. La combinaison de coordonnées

relatives, et de flèches qu'on accroche à des boites, sans se

préoccuper de donner des coordonnées, est très agréable.

Voilà, bien sûr, Fletcher est beaucoup plus riche que cela et vous pouvez faire bien d'autres choses, n'hésitez pas à lire la très complète documentation.

L'article seul

Fiche de lecture : Un pacte avec le diable

Auteur(s) du livre : Michel Tedoldi

Éditeur : Espaces Libres

978-2-226-49957-8

Publié en 2023

Première rédaction de cet article le 1 décembre 2025

Après la Seconde Guerre mondiale, la France a récupéré un certain nombre de scientifiques et d'ingénieurs nazis, notamment pour travailler dans l'aéronautique et le spatial. Un phénomène bien moins connu que la récupération analogue faite par les Étatsuniens.

Car tout le monde sait que von Braun et ses complices ont échappé à toute poursuite après la guerre car les États-Unis avaient besoin d'eux pour construire des missiles, domaine où l'Allemagne était très en avance. L'Union Soviétique a fait pareil, quoique plus discrètement. Et la France, qui, ayant été occupée des années par les nazis, aurait pu hésiter à les embaucher ? Elle l'a fait aussi. Ce petit livre résume ce qu'on sait sur ce recrutement de nazis après 1945. Qui étaient-ils ? Combien ? Que sont-ils devenus ? (Ils sont restés à travailler en France et y sont morts tranquillement.)

Un petit mot sur ma famille, à ce sujet : mon père avait travaillé à Vernon, haut lieu de l'aérospatial français, à l'époque où il y avait encore pas mal d'ex-nazis qui y étaient présents. Ils ne se cachaient pas spécialement, et tout le monde savait donc que la France avait recruté des Allemands. Mais l'affaire a été plutôt refoulée de la mémoire collective. L'un des ingénieurs a même eu une rue à son nom, débaptisée il y a seulement un an.

Même le PCF avait bruyamment approuvé cette embauche, le stalinien Jacques Duclos déclarant dans un discours public à Decize « Ceux qui critiquent l'installation des Allemands à Decize ne pourraient être que des collaborateurs. »

Bref, ce livre est un ajout utile à l'histoire de France.

L'article seul

Typst, un compilateur de texte

Première rédaction de cet article le 19 novembre 2025

Au Capitole du Libre de novembre 2025, j'ai suivi l'exposé de Patrick Massot sur Typst, un concurrent possible de LaTeX. Je ne suis pas un expert de Typst, je n'ai pas encore écrit de vrai texte avec donc ce qui suit est un résumé de l'exposé, agrémenté de quelques essais.

Typst est un compilateur de texte, un système où vous tapez du texte et du formatage avec un éditeur quelconque, texte qui sera ensuite traduit dans des formats de distribution comme PDF. Les avantages de ces compilateurs (ou formatteurs), comme noté par Patrick Massot, sont la reproductibilité, la possibilité de choisir librement son éditeur, la flexibilité, et la possibilité d'automatiser la production de documents. Typst est donc une alternative à LaTeX ou à Pandoc+Markdown. C'est évidemment un logiciel libre, sinon on n'en parlerait pas à Capitole du Libre. Il se veut plus perfectionné que Pandoc+Markdown (par exemple pour des documents complexes avec de la mathématique) et plus simple à utiliser que LaTeX, avec une syntaxe moins tordue (pas difficile) et des messages d'erreur plus clairs (pas difficile non plus).

Voici un très simple document (tant que ça reste aussi simple, la syntaxe ressemble vaguement à Markdown) :

= J'essaie Typst Ça marche. Je peux *insister* ou faire des listes : + liberté + égalité + fraternité == Des maths $E = m c^2$ == Du texte plus long #text(red)[ On peut colorier. ] J'ai pas envie de tout taper. #lorem(100)

On le compile :

% typst compile essai.typ

Et on obtient un PDF.

Comme promis, les messages d'erreur sont clairs et précis, grosse différence avec LaTeX :

% typst compile essai.typ error: unclosed delimiter ┌─ essai.typ:15:9 │ 15 │ #set text( │ ^

Si on veut de l'HTML (option actuellement présentée comme expérimentale et, comme vous le verrez dans l'exemple suivant, la mathématique n'est pas traitée) :

% typst compile --features html --format html essai.typ warning: html export is under active development and incomplete = hint: its behaviour may change at any time = hint: do not rely on this feature for production use cases = hint: see https://github.com/typst/typst/issues/5512 for more information warning: equation was ignored during HTML export ┌─ essai.typ:11:0 │ 11 │ $e = m c^2$ │ ^^^^^^^^^^^

Aucun CSS n'est produit, le texte en rouge n'est donc pas colorié. Bref, la production de HTML est à l'heure actuelle très limitée. Pour cela, Pandoc est une meilleure solution, car il sait lire le Typst, même les formules mathématiques :

% pandoc -i essai.typ -o essai.html

Typst dispose d'innombrables autres possibilités, lisez la documentation pour en avoir une idée. On peut créer ses propres fonctions (Typst inclut un langage de programmation complet), définir des gabarits, etc. Il existe déjà plein de paquetages rigolos pour Typst sur le dépôt officiel, notamment pour l'écriture d'articles techniques et scientifiques. Voyons un exemple avec le paquetage atomic :

// (Ceci est un commentaire.) https://typst.app/universe/package/atomic #import "@preview/atomic:1.0.0" = Un essai d'un paquetage Typst *atomic* permet de dessiner des atomes, avec leurs électrons. Ici, le plutonium. // Cf. Article Wikipédia « Électrons par niveau d’énergie 2, 8, 18, 32, 24, 8, 2 » #atomic.atom(94,239, "Pu", (2, 8, 18, 32, 24, 8, 2))

(Attention, à la première utilisation, il faut être connecté à l'Internet, le paquetage étant téléchargé.) Compilé, cela donnera ce joli PDF.

De la même façon, vous pouvez faire des supports de présentation, avec touying qui est donc un concurrent de Beamer :

#import "@preview/touying:0.6.1": * #import themes.simple: * #show: simple-theme = Mon exposé Le sujet de l'exposé == Première diapo Je mets du texte. == Deuxième diapo Je continue. Et encore.

Ah, et comment ai-je installé Typst ? C'est bien documenté. Il n'y a apparemment pas de paquetage de Typst existant, pour aucun système, mais Typst fournit des binaires (déjà compilés). Comme je préfère vérifier que les sources compilent, je l'ai compilé moi-même :

% cargo install --locked typst-cli

Typst est écrit en Rust et compiler du Rust est souvent une expérience frustrante. Sur un Ubuntu stable :

error: cannot install package `typst-cli 0.14.0`, it requires rustc 1.88 or newer, while the currently active rustc version is 1.75.0 `typst-cli 0.11.1` supports rustc 1.74

Eh oui, comme trop souvent avec Rust, il faut la toute, vraiment toute dernière version du compilateur, le langage changeant tout le temps. (J'ai donc fait mes tests sur une Debian unstable.)

Est-ce que je vais utiliser Typst ? Je ne sais pas encore. Le logiciel est déjà très utilisable, en tout cas sur un système d'exploitation très récent. Je vais faire les supports de ma présentation au prochain SplinterCon en Typst, ce sera une occasion de tester. L'une de mes inquiétudes est la gestion du projet. Typst est à 100 % du logiciel libre (licence Apache) mais son développement est apparemment étroitement contrôlé par une seule entreprise, qui commercialise des extensions privatrices à Typst et dont il n'est pas certain qu'ils acceptent d'ouvrir le projet.

Quelques autres ressources :

- Le tutoriel officiel est très bien.

- Typst est bien documenté.

- Les exemples utilisés dans la présentation de Patrick Massot :

git clone https://codeberg.org/pmassot/typst_cdl2025.

L'article seul

Capitole du Libre 2025 (et un exposé sur les types de média)

Première rédaction de cet article le 19 novembre 2025

Dernière mise à jour le 19 décembre 2025

Les 15 et 16 novembre s'est tenue à

Toulouse Capitole du Libre,

conférence consacrée aux logiciels

libres mais pas que. Quelques notes suivent, entre autres

sur l'exposé que j'ai fait sur les types de

média (comme text/html pour ce blog).

Le poète toulousain Louis-Catherine Vestrepain, dont la statue

n'est pas trop éloignée du lieu où se

tient Capitole du Libre :

Capitole du Libre, c'est gros, avec beaucoup de monde, et un programme chargé (93 exposés, 1 400 participants, 10 kg de café, 500 repas aux camions de nourriture, 10 mètres carrés de pizzas pour les bénévoles). Je ne vais donc pas parler de tout. Déjà, j'ai suivi un exposé et un atelier qui font l'objet d'articles séparés :

- L'exposé sur le compilateur de texte Typst, un concurrent de LaTeX,

- L'atelier (donc, avec de la pratique) sur le mécanisme eBPF, qui permet de développer plus facilement des programmes dans le noyau Linux, ici un programme qui intercepte et autorise (ou pas) les requêtes DNS.

Autres moments passionnants :

- L'exposé de Natouille sur « C’est quoi l’UX design et pourquoi le libre aurait à y gagner en intégrant ces profils ? », où elle rappelait que la conception d'UX, ce n'est pas juste pour les cliquodromes et que tout logiciel peut avoir intérêt à avoir une démarche UX, et, entre autres, que les développeureuses devraient parler avec leurs utilisateurices et les observer. « Le design, c'est faire des produits utilisables, limiter frictions, risques et déceptions » et « Il y a utile, utilisable et utilisé. Instagram est utilisé, le site des impôts est utile, un site / logiciel bien conçu est utilisable ».

- La présentation par Bookynette de l'escape game (en cartes) de l'April pour faire connaitre le logiciel libre.

- L'exposé sur Ceph m'a plutôt convaincu que cette solution de stockage réparti n'était pas pour moi, pas parce que le logiciel n'est pas bon mais parce qu'il traite un problème bien précis qui n'est pas forcément le mien : avoir des données qui soient toujours disponibles, en les stockant dans des endroits bien distincts. Chaque fichier confié à Ceph est divisé en objets et chaque objet se retrouve sur plusieurs disques de plusieurs serveurs. L'interface de Ceph peut être du S3, un système de fichiers accessible comme un partage réseau ou même un block device. Ceph en lui-même ne remplace pas les sauvegardes. On peut toutefois utiliser des snapshots qui, à condition qu'ils ne soient pas accessibles aux clients, protègent contre erreurs humaines et rançongiciels.

- La présentation de Skeptikon « Le logiciel libre est un projet politique » insistait sur la lutte contre les mensonges et le discours anti-scientifique. Dans le contexte de la montée de l'extrême-droite, le logiciel libre est une des armes pour préserver sa liberté.

- Et puis, il n'a pas été présenté à Capitole du Libre mais saviez-vous qu'il existe un langage de programmation conçu et maintenu à Toulouse, Smala ?

De mon côté, j'ai fait un exposé sur les types de

médias (également appelés types MIME, vous savez, les

text/plain, image/png et

autres haptics/ivs). Voici les supports et

leur source

(en LaTeX, pas en Typst) et la vidéo.

Et j'ai participé à la table ronde « Souveraineté numérique : pourquoi le logiciel libre est stratégique », avec Ludovic Dubost et Nicolas Vivant, animée par Aline Paponaud. L'idée (assez consensuelle parmi les participants) était qu'il n'y a pas de vraie souveraineté sans logiciel libre, entre autres parce que remplacer un GAFA étatsunien par un GAFA français qui ferait exactement la même chose n'a pas beaucoup d'intérêt. Le logiciel libre permet la souveraineté de l'utilisateurice, pas seulement celle de l'État.

Photos et vidéos sont disponibles, les

photos sur https://photos.capitoledulibre.org/https://videos.capitoledulibre.org/

Ah, et le quotidien la Dépêche a fait un article très louangeur.

Bref, soutenez Capitole du Libre :  .

.

L'article seul

Atelier sur eBPF au Capitole du Libre

Première rédaction de cet article le 19 novembre 2025

Dernière mise à jour le 20 novembre 2025

Au Capitole du Libre de novembre 2025, j'ai participé à un passionnant atelier de Maxime Chevallier et Alexis Lothoré sur la programmation réseau en eBPF. Le but était de mettre en œuvre un bloqueur de publicité (ou autre contenu qu'on ne voulait pas voir), agissant via les requêtes DNS, que le programme va intercepter et analyser.

eBPF désigne à la fois un jeu d'instructions machine, normalisé dans le RFC 9669, et un système permettant de produire des programmes utilisant ce jeu d'instructions, et des les installer dans le noyau Linux. eBPF permet ainsi d'ajouter des fonctions au noyau, sans modifier et recompiler celui-ci (ce qui est vraiment une tâche difficile) et sans redémarrer la machine. Je vous renvoie à mon article sur le RFC 9669 pour plus de détail. Un exemple d'utilisation de eBPF dans le contexte du DNS est dans le serveur NSD.

Le cahier des charges de l'atelier était d'écrire (en C) et de faire tourner un programme

eBPF qui va regarder toutes les requêtes DNS de la machine, les comparer à une liste

de blocage, et stopper ces requêtes si le nom de domaine est dans cette liste. Si vous

avez un peu de temps, je recommande de faire l'exercice vous-même,

téléchargez le support de l'atelier (git clone

https://github.com/bootlin/ebpf-workshop-cdl), lisez le

fichier Readme.md (il est en anglais) et

essayez. Cet article que vous lisez est plutôt destiné aux gens qui

veulent la solution.

Comme le système eBPF sur Linux n'est pas d'une clarté parfaite,

il vaut mieux commencer par un programme trivial. Attention, comme

indiqué dans le Readme.md, ça marchera… ou pas,

selon la version exacte du système d'exploitation que vous utilisez

(j'ai tout fait sur une Ubuntu

stable, la version 24.04). Quelques paquetages à

installer :

% sudo apt install linux-tools-common build-essential clang libbpf-dev

Après cela, si, quand vous essayez de lancer bpftool, vous avez :

% bpftool

WARNING: bpftool not found for kernel 6.14.0-112033

You may need to install the following packages for this specific kernel:

linux-tools-6.14.0-112033-tuxedo

linux-cloud-tools-6.14.0-112033-tuxedo

You may also want to install one of the following packages to keep up to date:

linux-tools-tuxedo

linux-cloud-tools-tuxedo

N'essayez pas d'installer les paquetages cités, ça ne servira sans doute pas. À la place, installez à la main :

% git clone --recurse-submodules https://github.com/libbpf/bpftool.git % cd src % make % sudo make install

Maintenant, écrivons le programme trivial qui ne fait pas grand'chose :

% cat hello.bpf.c

#include <linux/bpf.h>

#include <linux/pkt_cls.h>

#include "bpf/bpf_helpers.h"

#include "bpf/bpf_endian.h"

SEC("tc")

int hello(struct __sk_buff *skb)

{

bpf_printk("Hello, world !");

return TC_ACT_OK;

}

char __license[] SEC("license") = "GPL";

Ce programme crée une fonction (qui sera donc exécutée par le noyau), qui sera appelée à chaque paquet réseau et affichera le classique « Bonjour, tout le monde », avant de laisser passer le paquet. Compilons-le en eBPF :

% clang -Wall -g -O1 -target bpf -c hello.bpf.c -o hello.bpf.o

Pour des raisons que je ne comprends pas bien, les options

-g et surtout -On avec n > 0

semblent indispensables. Apparemment (c'est peu documenté), l'optimisation est

nécessaire pour retirer du code qui, autrement, serait refusé par le

vérificateur. Regardez la documentation « Clang

implementation notes » et l'article

« Building BPF

applications with libbpf-bootstrap » (« -g is mandatory to make Clang emit BTF information. -O2 is also necessary for BPF compilation).

La compilation va produire du code eBPF :

% file hello.bpf.o hello.bpf.o: ELF 64-bit LSB relocatable, eBPF, version 1 (SYSV), with debug_info, not stripped

Le désassembleur par défaut ne connait pas eBPF :

% objdump -d hello.bpf.o hello.bpf.o: file format elf64-little objdump: can't disassemble for architecture UNKNOWN!

Mais il y en a un autre qui marche (suivez le RFC 9669) mais je le trouve moins joli :

% llvm-objdump -d hello.bpf.o

hello.bpf.o: file format elf64-bpf

Disassembly of section tc:

0000000000000000 <hello>:

0: 18 01 00 00 00 00 00 00 00 00 00 00 00 00 00 00 r1 = 0x0 ll

2: b7 02 00 00 0f 00 00 00 r2 = 0xf

3: 85 00 00 00 06 00 00 00 call 0x6

4: b7 00 00 00 00 00 00 00 r0 = 0x0

5: 95 00 00 00 00 00 00 00 exit

Bon, ce n'est pas tout de produire un binaire eBPF, il faut le

charger dans le noyau, et dire au noyau de l'exécuter pour chaque

paquet sortant. Il existe plusieurs méthodes pour cela (on peut

aussi écrire son propre programme qui fait le chargement), on va

utiliser tc,

et attacher le code eBPF à l'interface réseau active, ici

wlp1s0 :

% sudo tc qdisc add dev wlp1s0 clsact % sudo tc filter add dev wlp1s0 egress bpf direct-action object-file hello.bpf.o sec tc

(La syntaxe de tc est merveilleuse. Sur les noyaux Linux plus

récents bpftool prog load fichier.o chemin

suivi de bpftool net attach tcx_egress pinned chemin dev

interface devrait pouvoir charger puis attacher des

programmes, sans utiliser tc.) Une fois que tout cela est fait sans erreur, on peut afficher les

messages :

% sudo bpftool prog tracelog irq/80-iwlwifi:-928 [011] b.s3. 200018.139564: bpf_trace_printk: Hello, world ! irq/81-iwlwifi:-929 [008] b.s3. 200018.139564: bpf_trace_printk: Hello, world ! Socket Thread-576739 [000] b..1. 200018.139832: bpf_trace_printk: Hello, world ! Socket Thread-576739 [000] b..1. 200018.139976: bpf_trace_printk: Hello, world ! …

Et voilà, à chaque paquet sortant (la directive egress dans l'appel à tc), on a un message affiché.

Comme eBPF inclut un vérificateur qui examine le code avant de l'exécuter (pour éviter qu'un programme eBPF bogué ne plante tout le noyau), des erreurs apparemment innocentes (comme d'aller visiter de la mémoire en dehors de nos variables) va se traduire par des erreurs au chargement, assez difficiles à déboguer :

libbpf: prog 'dns_filter': BPF program load failed: Permission denied libbpf: prog 'dns_filter': -- BEGIN PROG LOAD LOG -- 0: R1=ctx() R10=fp0 ; int dns_filter(struct __sk_buff *skb) @ dns-filter.bpf.c:107 0: (bf) r7 = r1 ; R1=ctx() R7_w=ctx() 1: (b7) r6 = 0 ; R6_w=0 ... 124: (bf) r3 = r1 ; R1_w=scalar(id=253) R3_w=scalar(id=253) 125: (0f) r3 += r2 ; R2_w=0 R3_w=scalar(id=253+0) 126: (71) r3 = *(u8 *)(r3 +0) R3 invalid mem access 'scalar' processed 9460 insns (limit 1000000) max_states_per_insn 4 total_states 129 peak_states 129 mark_read 128 -- END PROG LOAD LOG -- libbpf: prog 'dns_filter': failed to load: -13 libbpf: failed to load object 'dns-filter.bpf.o' Unable to load program

Si vous voyez cela, dites-vous que votre programme doit être trop laxiste et, pour reprendre une expression utilisée par les animateurs de l'atelier, qu'il jardine en dehors de ses plate-bandes.

Maintenant, revenons au vrai projet. L'atelier était prévu pour

une découverte progressive, et c'est ce que vous ferez si vous

suivez le support de l'atelier mentionné plus tôt (git clone

https://github.com/bootlin/ebpf-workshop-cdl). Ici, je vais

simplement présenter le résultat final. Mon code complet (légèrement

différent de celui qui figure en correction dans les documents de

l'atelier) est dns-filter.bpf.c

La liste des domaines bloqués est un dictionnaire, structure de données fournie par eBPF pour communiquer entre le programme dans le noyau, et l'extérieur :

struct {

__uint(type, BPF_MAP_TYPE_ARRAY);

__uint(max_entries, 2);

__type(key, int);

__type(value, char[253]);

} blocklist SEC(".maps");

On va utiliser beaucoup de structures de données TCP/IP dont la

description est déjà fournie par Linux (comme struct

udphdr pour un en-tête UDP). Il n'y en a apparemment pas pour le DNS,

donc on la crée :

struct dnshdr {

__be16 trans_id;

__be16 flags;

__be16 nr_quest;

__be16 nr_answ;

__be16 nr_auth_rr;

__be16 add_rr;

};

Pour l'analyse des paquets, on va charger les octets dans nos

structures de données, à partir d'un index (la variable

offset) avec la fonction BPF

bpf_skb_load_bytes. Voici les étapes :

/* Ce paquet est-il un paquet IP ? Chargeons-le dans ethdhr avant de

regarder son champ Protocol. */

ret = bpf_skb_load_bytes(skb, offset, ðhdr, sizeof(ethhdr));

if (ret) {

return TC_ACT_OK;

}

if ((ethhdr.h_proto != __bpf_constant_htons(ETH_P_IPV6)) &&

(ethhdr.h_proto != __bpf_constant_htons(ETH_P_IP))) {

return TC_ACT_OK;

}

Si une fonction échoue (j'ai omis ce test par la suite mais dans le vrai code, il faut le mettre, rappelez-vous que le vérificateur vous surveille), ou bien si le paquet n'est pas de l'IP, on le laisse passer (on renvoie OK à tc). Ensuite, après avoir sauté l'en-tête IP (attention, il n'a pas la même taille en IPv4 et IPv6), on regarde si c'est bien de l'UDP, et s'il utilise bien le port 53 du DNS :

if (l4_proto != IPPROTO_UDP) {

return TC_ACT_OK;

}

ret = bpf_skb_load_bytes(skb, offset, &udph, sizeof(udph));

if (__bpf_constant_ntohs(udph.dest) != 53) {

return TC_ACT_OK;

}

On va ensuite récupérer le nom de domaine demandé (attention à l'analyse d'un paquet DNS, lisez bien le RFC 9267) :

offset += sizeof(dnsh); ret = parse_query(skb, offset, query, 253); ctx.query = query;

On va ensuite tester ce nom query pour voir

s'il est dans la liste de blocage, avec

bpf_for_each_map_elem. Notez le code de retour

TC_ACT_SHOT, qui dit à tc de jeter le paquet

sans autre forme de procès.

bpf_for_each_map_elem(&blocklist, dns_check, &ctx, 0);

if (ctx.match) {

bpf_printk("*REJECTED* DNS query of %s", query);

return TC_ACT_SHOT;

}

bpf_printk("Accepted DNS query of %s", query);

return TC_ACT_OK;

Reste un petit détail : il faut peupler cette liste de blocage

(la variable blocklist, de type

dictionnaire). Une méthode possible est

d'utiliser la commande bpftool mais, évidemment, en vrai, on

écrirait un programme avec une interface utilisateur plus agréable :

% sudo bpftool map update name blocklist key 0 0 0 0 value $(printf '%-253s' x.com | tr ' ' '\0' | xxd -i -c 253| tr -d ,)

Armé de tout cela, on peut utiliser cette suite de commandes pour compiler le programme, attacher l'eBPF via tc, remplir la liste de blocage et regarder le résultat :

#!/bin/sh sudo tc qdisc del dev wlp1s0 clsact sudo tc qdisc add dev wlp1s0 clsact clang -Wall -g -O1 -target bpf -c dns-filter.bpf.c -o dns-filter.bpf.o sudo tc filter add dev wlp1s0 egress bpf direct-action object-file dns-filter.bpf.o sec tc sudo bpftool map update name blocklist key 0 0 0 0 value $(printf '%-253s' x.com | tr ' ' '\0' | xxd -i -c 253| tr -d ,) sudo bpftool map update name blocklist key 1 0 0 0 value $(printf '%-253s' facebook.com | tr ' ' '\0' | xxd -i -c 253| tr -d ,) sudo bpftool prog tracelog

Testons-le :

% ping facebook.com ping: facebook.com: Temporary failure in name resolution % ping bootlin.com PING bootlin.com (87.98.181.233) 56(84) bytes of data. 64 bytes from bootlin.com (87.98.181.233): icmp_seq=1 ttl=49 time=15.8 ms

Et, affiché par bpftool :

systemd-resolve-1112 [000] b..1. 208052.900167: bpf_trace_printk: *REJECTED* DNS query of facebook.com systemd-resolve-1112 [000] b..1. 208052.900183: bpf_trace_printk: *REJECTED* DNS query of facebook.com systemd-resolve-1112 [005] b..1. 208264.967434: bpf_trace_printk: Accepted DNS query of bootlin.com

Objectif atteint. On peut aller boire une bière. Notez que vous pouvez afficher la liste de blocage :

% sudo bpftool map dump name blocklist

[{

"key": 0,

"value": "x.com"

},{

"key": 1,

"value": "facebook.com"

}

]

Quelques détails toutefois. D'abord, le programme de filtrage étant sommaire, il ne bloque que le nom exact dans la liste, pas ses sous-domaines :

% dig facebook.com ;; communications error to 127.0.0.53#53: timed out … ;; no servers could be reached % dig www.facebook.com … ;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 54041 ;; flags: qr rd ra; QUERY: 1, ANSWER: 2, AUTHORITY: 0, ADDITIONAL: 1 … ;; ANSWER SECTION: www.facebook.com. 2724 IN CNAME star-mini.c10r.facebook.com. star-mini.c10r.facebook.com. 29 IN A 157.240.253.35 ;; Query time: 22 msec ;; SERVER: 127.0.0.53#53(127.0.0.53) (UDP) ;; WHEN: Mon Nov 17 16:08:00 CET 2025 ;; MSG SIZE rcvd: 90

Corriger cette limite est laissé au lecteur ou à la lectrice (notez toutefois que dans l'atelier, il y avait environ vingt participants et pas de participante).

Ensuite, puisque tc va purement et simplement jeter le paquet, le client DNS n'aura aucune information, réessaiera et finira par laisser tomber mais au bout d'un délai qui est certainement pénible pour l'utilisateur. Il vaudrait mieux fabriquer une réponse mensongère, genre NXDOMAIN. Je ne suis pas sûr que cela soit facilement faisable avec tc mais il existe d'autres façons d'exécuter de l'eBPF donc le problème est certainement soluble.

Enfin, le DNS ne marche pas que sur UDP, il fonctionne aussi sur TCP (RFC 7766). Le programme ci-dessus peut donc être facilement contourné :

% dig @9.9.9.9 facebook.com

;; communications error to 9.9.9.9#53: timed out

…;; no servers could be reached

% dig +tcp @9.9.9.9 facebook.com

…

;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 24690

;; flags: qr rd ra; QUERY: 1, ANSWER: 1, AUTHORITY: 0, ADDITIONAL: 1

…

;; ANSWER SECTION:

facebook.com. 30 IN A 57.144.222.1

;; Query time: 7 msec

;; SERVER: 9.9.9.9#53(9.9.9.9) (TCP)