Ce blog n'a d'autre prétention que de me permettre de mettre à la disposition de tous des petits textes que j'écris. On y parle surtout d'informatique mais d'autres sujets apparaissent parfois.

Fiche de lecture : Bitcoin - métamorphoses

Auteur(s) du livre : Jacques Favier, Benoît

Huguet, Adli Takkal Bataille

Éditeur : Dunod

9-782-100-784646

Publié en 2018

Première rédaction de cet article le 30 décembre 2018

Le Bitcoin suscite toujours autant de passions, et les informations à son sujet varient toujours de l'enthousiasme délirant aux enterrements prématurés. Il est amusant de noter que les uns comme les autres utilisent souvent les mêmes arguments qu'il y a dix ans, au moment du lancement de la cryptomonnaie. Au contraire, le livre de Favier, Huguet et Bataille se demande « où en est le Bitcoin aujourd'hui ? » Certainement pas au même point qu'en 2008.

J'avais déjà parlé du précédent livre de ces auteurs. Celui-ci est destiné à un public plus informé, qui connait déjà le Bitcoin et souhaite s'informer sur les derniers développements.

Comme dans leur livre antérieur, les auteurs n'hésitent pas à nager à contre-courant du discours dominant. Depuis deux ou trois ans, la mode est à dire « le Bitcoin, c'est pas bien mais la chaîne de blocs, c'est la solution à tous les problèmes de l'humanité ». Pour eux, au contraire, le Bitcoin reste la meilleure solution à bien des problèmes pour lesquels on crée de nouvelles chaînes de blocs, et ils sont très confiants dans sa capacité à évoluer pour répondre aux défis d'aujourd'hui. Les auteurs suggèrent que ce discours bruyant sur la chaîne de blocs sert à évacuer le caractère disrupteur du Bitcoin et à ramener le torrent des cryptomonnaies dans son lit, un lit bien contrôlé et bien régulé.

Les auteurs notent bien que la grande majorité des articles sur le Bitcoin sont très médiocres, juste une compilation de clichés (Law, les tulipes et Ponzi). Parfois, la malhonnêteté intellectuelle va plus loin, comme le reportage de France 2 sur le Bitcoin se terminant par… un envol de pigeons. Comme le notent Favier, Huguet et Bataille, « illustre-t-on un reportage sur une banque centrale par des photos de poulets en batterie ? »

Un autre exemple de la propagande contre les cryptomonnaies concerne les ICO, un mécanisme de financement où une entreprise débutante vend des jetons d'une cryptomonnaie… qui n'existe pas encore. Les ICO sont systématiquement diabolisés dans les médias, qui ne parlent que du risque de perdre son argent, si l'entreprise se casse la figure. Mais, comme le disent les auteurs « pourquoi est-il admis qu'on puisse perdre de l'argent avec la Française des Jeux et pas avec les ICO ? »

À juste titre, les auteurs sont hostiles au concept de « chaîne de blocs privée » (ou « chaîne de blocs à permission ») en notant qu'il s'agit soit de banales bases de données partagées, rebaptisées chaîne de blocs pour des raisons marketing, soit d'erreurs techniques où on utilise une chaîne de blocs pour un problème où elle n'est pas la meilleure solution. En effet, tout l'intérêt de Bitcoin est de fournir de la confiance dans un état alors même que les participants ne se connaissent pas. Si les participants se connaissent et ont déjà une structure en place ou, pire, si le seul participant est une entreprise spécifique, la chaîne de blocs n'a guère d'intérêt.

Et pendant ce temps, Bitcoin ne reste pas inactif : si le logiciel et le protocole n'évoluent qu'avec prudence, la communauté autour du Bitcoin, elle, a beaucoup changé et, au milieu de nombreuses crises, a prouvé sa faculté à s'adapter, dans un environnement impitoyable.

Le gros du livre tourne autour d'un enjeu technique essentiel pour toute chaîne de blocs : le passage à l'échelle. Vu que la taille de blocs de Bitcoin est limitée (notamment pour éviter certaines attaques par déni de service) et que l'écart de temps entre deux blocs est fixe, Bitcoin ne peut pas traiter un nombre illimité de transactions. Une chaîne de blocs qui ne mettrait pas de limite aurait d'autres problèmes, notamment la croissance illimitée de la chaîne, que tous les pairs doivent charger. Bref, on ne peut pas envisager, avec le Bitcoin classique, un monde où chacun paierait son café à la machine avec des bitcoins. Il faut donc améliorer le passage à l'échelle. Ce sujet est bouillonnant en ce moment dans le monde Bitcoin. (Le livre remarque que cela évoque l'époque où les experts auto-proclamés répétaient que l'Internet n'avait pas d'avenir, qu'il s'écroulerait dès qu'on essaierait de s'en servir vraiment, pendant que les vrais experts travaillaient à améliorer l'Internet, afin qu'il puisse assurer le service qu'en attendaient les utilisateurs.)

Les auteurs décrivent donc les solutions comme les « chaînes de côté » (sidechains, comme par exemple Blockstream ou RootStock) où une chaîne ayant moins de limites sert pour les transactions courantes, et son état final est mis de temps en temps sur une chaîne principale, par exemple celle de Bitcoin. Ainsi, la chaîne de côté croît vite mais on n'a pas besoin de la garder éternellement. Autre possibilité, les échanges hors-chaîne mais reportés sur la chaîne comme avec le Lightning Network. Cette partie du livre est plus difficile à lire, reflétant le caractère très mouvant de ces innovations.

Le livre couvre également en détail le cas des scissions, notamment la plus grosse qui a affecté Bitcoin depuis deux ans, et qui est toujours en cours, Bitcoin Cash (sans compter Bitcoin SV.)

Le cas des contrats automatiques est aussi traité, en exprimant un certain scepticisme quant à la possibilité d'en produire sans bogues. Mais, surtout, le livre note que la plupart des problèmes « intéressants » qu'on pourrait traiter avec des contrats automatiques nécessitent de l'information sur le monde extérieur à la chaîne. Si le déroulement d'un contrat automatique d'assurance dépend du temps, par exemple, il faudra bien accéder à des informations météorologiques, et cela ne sera plus pair-à-pair, cela ne pourra pas se faire entièrement sur la chaîne de blocs. (Il faudra utiliser ce qu'Ethereum appelle des oracles, qui ne sont pas pair-à-pair, donc posent un problème de confiance.)

Le monde Bitcoin, sans même parler des autres cryptomonnaies, est très actif en ce moment et des nouvelles propositions émergent tous les jours et d'innombrables essais sont lancés. Ce livre est donc un document utile pour avoir une vision relativement synthétique de l'état actuel de Bitcoin et de ses dernières évolutions. J'ai apprécié le côté ouvert de ce livre, qui présente des changements en cours, sans essayer d'imposer une vision unique.

Note : j'ai reçu (sans engagement) un exemplaire gratuit de ce livre par l'éditeur.

L'article seul

Fiche de lecture : Cyberfatale

Auteur(s) du livre : Clément Oubrerie (Dessin), Cépanou

(Scénario)

Éditeur : Rue de Sèvres

9-782369-815266

Publié en 2018

Première rédaction de cet article le 29 décembre 2018

Première (?) BD à parler de cybersécurité et de cyberguerre, « Cyberfatale » est une bonne introduction au monde de la lutte « cyber » entre États.

Il est significatif de l'état de la communication et de l'information en matière de « cyber » qu'une BD soit plus sérieuse et mieux informée que la plupart des livres supposés sérieux sur le sujet. Pas de sensationnalisme dans « Cyberfatale », juste une bonne description des attaques (de la plus triviale, un site Web de l'État défiguré, à la plus ennuyeuse, un engin de guerre piraté informatiquement) et des réactions (qui sont, on n'en sera pas surpris, surtout axées sur la communication : « si ça sort, on est morts »). L'un des personnages doit à un moment rédiger un texte officiel sur la cyberdéfense et, après avoir aligné les poncifs dans son texte, se dit « c'est incompréhensible, c'est parfait ».

Il est recommandé de connaitre un peu le sujet, pour comprendre les clins d'œil mais, sinon, l'auteur a pensé aux débutants avec un excellent glossaire, très drôle, et a inventé un personnage d'officière débutante dans le « cyber », excellent prétexte pour donner des explications au lecteur / à la lectrice.

J'ai particulièrement apprécié que le livre fasse une place importante à la question de l'attribution des attaques. Si l'exemple d'analyse d'un logiciel malveillant est ultra-simplifié (mais c'est une BD, pas un livre de rétro-ingénierie), en revanche, la difficulté à être sûr de l'identité de l'attaquant est bien rendue.

Ah, et comme rien n'est parfait, un reproche : le texte utilise à tort le terme « crypter ».

L'article seul

Books - Internet, pièges et maléfices

Première rédaction de cet article le 26 décembre 2018

Tout a commencé par une panne d'un Eurostar. Immobilisé sur la voie, il bloquait toute la ligne à grande vitesse du nord de Paris. Mon TGV pour Lille a eu une heure et demie de retard. En attendant ce TGV, je pouvais perdre du temps sur des réseaux sociaux futiles, ou bien lire les vrais penseurs qui écrivent sur du papier. J'ai donc acheté un hors-série de la revue Books, « Internet, pièges et maléfices ». Conseil : n'achetez pas cette revue. Il faut le faire une fois pour savoir mais, après, on peut s'abstenir, c'est très mauvais.

Le hors-série est consacré aux problèmes liés à l'Internet, ou plutôt essentiellement aux GAFA car c'est presque tout ce que les auteurs connaissent de l'Internet. La plupart des textes sont de la simple propagande anti-Internet, style Finkielkraut ou Joffrin, mais traduits de l'anglais, et publiés initialement dans des revues intellectuelles états-uniennes prestigieuses (genre The New York Review of Books ou The New Yorker), avant d'être rassemblés par Books dans ce hors-série.

Cela peut paraitre bizarre de parler de « propagande ». Après tout, l'Internet n'est ni un parti politique, ni une idéologie. Mais pourtant, la plupart des articles collectés ici ne sont effectivement pas du niveau de l'argumentaire mais de celui de la propagande : aucune référence précise, aucune vérification des faits, aucune mise en perspective. Ainsi, l'inévitable article sur le darknet ne manque pas de reprendre le cliché classique « tous les groupes terroristes ont une présence sur Internet » (p. 65), ce qui est factuellement exact (de même que « tous les terroristes utilisent une voiture ou le métro » ou bien « tous les terroristes boivent de l'eau ») mais n'offre aucune information, à l'époque où tout le monde a une présence sur Internet.

Books se veut intellectuel donc la propagande est légèrement plus subtile que sur BFM TV. Ainsi, l'article sur le darknet reconnait à mots couverts que le recrutement de tueurs à gages sur le darknet est une légende urbaine. C'est un des rares cas où il y a eu un scrupule tardif de l'auteur.

Mais autrement, tous les clichés se succèdent. On y trouve la traditionnelle bulle de filtres, comme si, avant Internet, le militant communiste lisait autre chose que l'Humanité et le patron autre chose que le Figaro, comme si, au café du commerce, on ne parlait pas déjà uniquement avec des gens proches, comme si les intellectuels qui passent à la télé allaient de temps en temps sur les rondspoints pour parler avec des gilets jaunes. On y voit le méchant Internet tuer les artistes car tout est gratuit. Bien sûr, Wikipédia n'est pas fiable et est trumpiste, puisque prétendant que toutes les vérités se valent. On y trouve les jeunes qui ne lisent plus, l'ordiphone qui rend bête, etc. On reconnait les deux ou trois mêmes personnes qui sont systématiquement cités dans les articles anti-Internet, Morozov et Lanier. Notez que je ne les compare pas : Morozov dit des choses qui font réfléchir, lui. Lanier n'est cité que parce que la propagande aime bien les repentis.

Bref, rien d'original ou de nouveau, pour une revue qui parait fin 2018 (certains articles sont des reprises et sont plus anciens). Question clichés, il ne manque que celui comme quoi les dirigeants de la Silicon Valley mettraient leurs enfants dans des écoles sans ordinateurs.

Critiquer Internet est chic dans certains cercles intellectuels, aux États-Unis comme en France. Par contre, critiquer le capitalisme est tabou : pas question de dire que Google est une entreprise capitaliste, et que cela explique mieux son comportement que de fumeuses références au transhumanisme. Critiquer le capitalisme, ou même simplement l'appeler par son nom, vous fait tout de suite classer chez les affreux communistes. Il faut donc prendre les devants et plusieurs articles de la revue mentionnent les pays de l'ex-URSS, notamment la Biélorussie, en décrivant l'horreur des régimes staliniens, pour bien enfoncer le clou « nous attaquons l'Internet mais nous n'attaquons pas le capitalisme, nous ne sommes pas des communistes, rassurez-vous ». Seul l'interview de Chris Hedges (par ailleurs très réactionnaire) nomme simplement les choses, en disant que Facebook et Google agissent comme ils agissent parce que ce sont des entreprises capitalistes.

Et, pour les lecteurs paresseux qui, contrairement à moi, n'auraient pas lu tous les articles, l'introduction anonyme fournit une synthèse toute faite « Books a été parmi les tout premiers organes de presse à attirer l'attention sur les risques que le développement d'Internet fait peser sur les démocraties ».

Tous les articles de ce numéro ne sont pas aussi caricaturaux que ceux que j'ai résumés ici. L'article de Frank Furedi sur la surinformation est une bonne synthèse historique. L'auteur y fait bien remarquer qu'à chaque saut technologique (notamment l'écriture et l'imprimerie), les contemporains ont eu peur de cet « excès d'information ». Et il analyse à juste titre que cette peur vient du fait qu'on n'a pas tout de suite les outils (techniques et intellectuels) pour gérer cet afflux d'information rendu possible par la nouvelle technique. De même, James Gleick sur les Anonymous, et Ben Jackson sur le harcèlement ont fait de bons articles qui ne sont pas unilatéraux dans leurs conclusions.

Mais cela ne devait pas plaire à la rédaction : les articles exprimant un point de vue nuancé sont systématiquement dotés d'encadrés qui les contredisent. (Une belle violation du droit moral, à mon avis, que ces pavés placés au milieu de l'article d'un auteur et qui prennent le contrepied de l'article !) Et, alors que les articles sont signés, ces encadrés sont anonymes (juste signés « Books »). Frank Furedi a même droit à deux encadrés.

La passion du propagandiste va jusqu'à accompagner l'article d'Edward Luttwak consacré à Edward Snowden d'un texte (p. 39) qui affirme que Snowden est lié à la Russie et en donnant pour preuve le fait qu'il encourage à utiliser Tor (stupidement qualifié de « moteur de recherche ») ajoutant que Tor est financé par la Russie ! Dans le monde réel, Tor est financé par l'armée états-unienne, ce que dit d'ailleurs bien un autre article (p. 62). Mais personne ne fait de vérification chez Books. On voit donc que les mensonges à des fins de propagande ne sont pas une exclusivité de RT.

La rédaction ne s'est pas acharnée uniquement à coups d'encadrés dans les articles qui ne convenaient pas au discours souhaité. Elle a aussi utilisé les chapeaux. Ainsi dans un article sur le darknet, le chapeau affirme que Bitcoin est « intraçable », alors que l'article, p. 64, explique à juste titre que c'est le contraire (à propos de l'enquête Silk road).

Autre malhonnêteté intellectuelle utilisée dans cette revue, c'est l'allusion. Au contraire des mensonges francs et clairs (le financement de Tor par la Russie…), l'allusion n'affirme rien de précis, mais laisse entendre. Ainsi, p. 63, le Bitcoin est critiqué car ne reposant pas sur l'or ou l'argent (ce qui est exact, mais est également vrai de toutes les autres monnaies), et laisse entendre que les monnaies fiat (celles des États), elles, le seraient.

Enfin, la revue use largement de formules jolies mais ne reposant pas sur des faits précis et vérifiables. On lit par exemple que Bitcoin repose sur une « formule mathématique obscure ». On joue ici sur l'aversion des médias pour la mathématique, présentée comme difficile et obscure, pour éviter que les citoyens ne se penchent sur les questions compliquées, afin de laisse entendre qu'il y aurait un secret caché dans Bitcoin. Ce n'est pas le cas, le logiciel est libre, on peut vérifier qu'il utilise de la cryptographie classique et bien connue. Certaines cryptomonnaies comme Monero ou Zcash utilisent en effet des algorithmes cryptographiques moins connus et difficiles à appréhender, mais, comme pour le Bitcoin, ils n'ont rien d'obscur et sont largement documentés. Mais l'effet visé était purement rhétorique : « obscur » (comme le dark de darknet) fait peur.

L'article seul

RFC 8493: The BagIt File Packaging Format (V1.0)

Date de publication du RFC : Octobre 2018

Auteur(s) du RFC : J. Kunze (California Digital

Library), J. Littman (Stanford

Libraries), E. Madden (Library of

Congress), J. Scancella, C. Adams (Library of Congress)

Pour information

Première rédaction de cet article le 20 décembre 2018

Le format BagIt, très utilisé dans le monde des bibliothèques (monde d'où sont issus les auteurs de ce RFC), décrit une série de conventions pour un ensemble de fichiers décrivant un contenu numérique quelconque. En fait, BagIt n'est pas vraiment un format (on ne peut pas le comparer à tar ou à zip), il définit juste les fichiers qui doivent être présents dans l'archive.

Une archive BagIt est appelée un sac (bag). Elle est composée des fichiers de contenu, qui sont d'un format quelconque, et des fichiers de métadonnées, qui décrivent le contenu (ces fichiers de métadonnées se nomment tags). BagTit met l'accent sur le contrôle de l'intégrité des données (les tags contiennent un condensat cryptographique des données) et sur la facilité d'accès à un fichier donné (les fichiers de données ne sont pas sérialisés dans un seul grand fichier, comme avec tar ou zip, ils restent sous la forme d'une arborescence).

La section 2 du RFC décrit la structure d'un sac :

- Des fichiers de métadonnées (les

tags) dont deux sont obligatoires,

bagit.txtqui indique le numéro de version BagIt, etmanifest-HASHALGO.txtqui contient les condensats. - Un répertoire

data/sous lequel se trouvent les fichiers de données. - Si on veut, des répetoires contenant des fichiers de métadonnées optionnels.

Voici un exemple d'un sac, contenant deux fichiers de données,

Makefile et

bortzmeyer-ripe-atlas-lapaz.tex :

% find /tmp/RIPE-Atlas-Bolivia

/tmp/RIPE-Atlas-Bolivia

/tmp/RIPE-Atlas-Bolivia/manifest-sha512.txt

/tmp/RIPE-Atlas-Bolivia/data

/tmp/RIPE-Atlas-Bolivia/data/Makefile

/tmp/RIPE-Atlas-Bolivia/data/bortzmeyer-ripe-atlas-lapaz.tex

/tmp/RIPE-Atlas-Bolivia/manifest-sha256.txt

/tmp/RIPE-Atlas-Bolivia/tagmanifest-sha256.txt

/tmp/RIPE-Atlas-Bolivia/bag-info.txt

/tmp/RIPE-Atlas-Bolivia/tagmanifest-sha512.txt

/tmp/RIPE-Atlas-Bolivia/bagit.txt

% cat /tmp/RIPE-Atlas-Bolivia/bagit.txt

BagIt-Version: 0.97

Tag-File-Character-Encoding: UTF-8

% cat /tmp/RIPE-Atlas-Bolivia/bag-info.txt

Bag-Software-Agent: bagit.py v1.7.0 <https://github.com/LibraryOfCongress/bagit-python>

Bagging-Date: 2018-12-20

Contact-Email: stephane+atlas@bortzmeyer.org

Contact-Name: Stéphane Bortzmeyer

Payload-Oxum: 6376.2

% cat /tmp/RIPE-Atlas-Bolivia/manifest-sha256.txt

6467957fa9c06d30c1a72b62d13a224a3cdb570e5f550ea1d292c09f2293b35d data/Makefile

3d65d66d6abcf1313ff7af7f94b7f591d2ad2c039bf7931701a936f1305ac728 data/bortzmeyer-ripe-atlas-lapaz.t

Les condensats ont été faits avec SHA-256.

Le fichier obligatoire bagit.txt doit

indiquer le numéro de version et

l'encodage. Le RFC décrit la version 1.0

mais, comme vous pouvez le voir plus haut, j'ai utilisé un outil un

peu ancien pour fabriquer le sac. Le répertoire

data/ contient les fichiers de données, non

modifiés (BagIt les traite comme du contenu binaire, copié au bit

près). manifest-sha256.txt contient une ligne

par fichier de données, indiquant le condensat. Notez qu'il peut y

avoir plusieurs manifestes, avec des

algorithmes différents. Cela permet, si un nouvel algorithme de

condensation plus

solide apparait, d'ajouter le manifeste au sac. Les noms

d'algorithmes de condensation sont tirés du registre

IANA du RFC 6920. Quant aux fichiers

(non obligatoires) dont le nom commence par

tagmanifest, ils indiquent les condensats des

fichiers de métadonnées :

% cat /tmp/RIPE-Atlas-Bolivia/tagmanifest-sha256.txt 16ed27c2c457038ca57536956a4431de4ac2079a7ec8042bab994696eb017b90 manifest-sha512.txt b7e3c4230ebd4d3b878f6ab6879a90067ef791f1a5cb9ffc8a9cb1f66a744313 manifest-sha256.txt 91ca8ae505de9266e37a0017379592eb44ff0a2b33b240e0b6e4f2e266688a98 bag-info.txt e91f941be5973ff71f1dccbdd1a32d598881893a7f21be516aca743da38b1689 bagit.txt

Enfin, le facultatif bag-info.txt contient des

métadonnées qui ne sont typiquement prévues que pour les humains,

pas pour être analysées automatiquement. La syntaxe est la classique

Nom: Valeur. Certains des noms sont

officiellement réservés (Contact-Name,

Bagging-Date…) et on peut en ajouter d'autres à

volonté.

Le sac est un répertoire, pas un fichier, et ne peut donc pas être transporté simplement, par exemple avec le protocole HTTP. On peut utiliser rsync, ou bien le sérialiser, par exemple en zip.

Il est amusant de noter qu'un sac peut être incomplet : des

fichiers de données peuvent être stockés à l'extérieur, et récupérés

dynamiquement lorsqu'on vérifie l'intégrité du sac. Dans ce cas, le

condensat dans le manifeste permettra de vérifier qu'on a bien

récupéré le contenu attendu. Les URL où

récupérer ce contenu supplémentaire seront dans un fichier

fetch.txt.

Un sac peut être complet (ou pas) et ensuite

valide (ou pas). La section 3 de notre RFC

définit ces termes : un sac est complet s'il contient tous les

fichiers obligatoires, et que tous les fichiers dans les manifestes

sont présents, et que les fichiers comme

bagit.txt ont une syntaxe correcte. Un sac est

valide s'il est complet et que tous les

condensats sont corrects.

La section 5 du RFC détaille quelques questions de sécurité liées à BagIt :

- BagIt va fonctionner entre systèmes

d'exploitation différents. Les noms de fichiers

peuvent comporter des caractères qui sont spéciaux pour un système

d'exploitation mais pas pour un autre. Une mise en œuvre de BagIt

sur Unix, par exemple,

ne doit donc pas accéder aveuglément à un fichier commençant par

une barre oblique, ou bien comprenant

/../../../. (Une suite de tests existe, avec plusieurs sacs… intéressants, permettant de tester la robustesse d'une mise en œuvre de BagIt.) - La possibilité de récupérer des fichiers distants ouvre évidemment plein de questions de sécurité amusantes (les plus évidentes sont résolues par l'utilisation de condensats dans les manifestes, je vous laisse chercher les autres).

Sans que cela soit forcément un problème de sécurité, d'autres différences entre systèmes d'exploitation peuvent créer des surprises (section 6 du RFC), par exemple l'insensibilité à la casse de certains systèmes de fichiers, ou bien la normalisation Unicode. La section 6 est d'ailleurs une lecture intéressante sur les systèmes de fichiers, et leurs comportements variés.

Passons maintenant aux programmes disponibles. Il en existe en plusieurs langages de programmation. Le plus répandu semble bagit-python, en Python. Il a été développé à la bibliothèque du Congrès, un gros utilisateur et promoteur de BagIt. La documentation est simple et lisible. On installe d'abord :

% pip3 install bagit Collecting bagit Downloading https://files.pythonhosted.org/packages/ee/11/7a7fa81c0d43fb4d449d418eba57fc6c77959754c5c2259a215152810555/bagit-1.7.0.tar.gz Building wheels for collected packages: bagit Running setup.py bdist_wheel for bagit ... done Stored in directory: /home/bortzmeyer/.cache/pip/wheels/8d/77/f7/8f91043ef3c99bbab558f578d19ce5938896e37e57609f9786 Successfully built bagit Installing collected packages: bagit Successfully installed bagit-1.7.0

On peut ensuite utiliser cette bibliothèque depuis Python :

% python3

Python 3.5.3 (default, Sep 27 2018, 17:25:39)

[GCC 6.3.0 20170516] on linux

Type "help", "copyright", "credits" or "license" for more information.

>>> import bagit

>>> bag = bagit.make_bag('/tmp/toto', {'Contact-Name': 'Ed Summers'})

>>>

Le répertoire /tmp/toto aura été transformé en

sac.

Cette bibliothèque vient aussi avec un outil en ligne de commande. J'ai créé le premier sac d'exemple de cet article avec :

% bagit.py --contact-name 'Stéphane Bortzmeyer' --contact-email 'stephane+atlas@bortzmeyer.org' \

/tmp/RIPE-Atlas-Bolivia

Et ce même outil permet de vérifier qu'un sac est valide :

% bagit.py --validate /tmp/RIPE-Atlas-Bolivia

2018-12-20 16:16:09,700 - INFO - Verifying checksum for file /tmp/RIPE-Atlas-Bolivia/data/bortzmeyer-ripe-atlas-lapaz.tex

2018-12-20 16:16:09,700 - INFO - Verifying checksum for file /tmp/RIPE-Atlas-Bolivia/data/Makefile

2018-12-20 16:16:09,701 - INFO - Verifying checksum for file /tmp/RIPE-Atlas-Bolivia/manifest-sha256.txt

2018-12-20 16:16:09,701 - INFO - Verifying checksum for file /tmp/RIPE-Atlas-Bolivia/manifest-sha512.txt

2018-12-20 16:16:09,701 - INFO - Verifying checksum for file /tmp/RIPE-Atlas-Bolivia/bagit.txt

2018-12-20 16:16:09,701 - INFO - Verifying checksum for file /tmp/RIPE-Atlas-Bolivia/bag-info.txt

2018-12-20 16:16:09,702 - INFO - /tmp/RIPE-Atlas-Bolivia is valid

Il existe d'autres mises en œuvre comme bagit ou bagins en Go. L'article « Using BagIt in 2018 » donne des informations utiles dans d'autres langages.

L'article seul

Fiche de lecture : En construction

Auteur(s) du livre : Valérie Schafer

Éditeur : INA

9-782869-382534

Publié en 2018

Première rédaction de cet article le 19 décembre 2018

Derrière un titre qui évoque les fameuses mentions « En construction » du début du Web, un ouvrage d'une historienne spécialisée dans l'histoire de l'Internet. Valérie Schafer décrit les débuts de l'Internet et du Web en France, au cours des années 1990.

On y trouve les débats franco-français « Minitel ou Internet », qui agitaient les gens d'en haut de 1994 à 1997 (les gens d'en bas avaient tranché depuis longtemps), les absurdités des intellectuels français face à un phénomène qu'ils ne comprennent pas, l'incompréhension des médias officiels (voir d'ailleurs l'excellente compilation de reportages télévisés faite par l'auteure), l'histoire de Fnet et d'autres acteurs, puis l'explosion de l'intérêt pour l'Internet, passant par les phases successives (on ignore, puis on ricane, puis on en fait des éloges démesurés), les problèmes concrets (kits de connexion, documentations incompréhensibles, compensées par le fait que les utilisateurs étaient des passionné·e·s, décidé·e·s à réussir), les débuts des sites Web (au HTML fait à la main), les relations avec les nouveaux utilisateurs qui arrivent en masse (le septembre sans fin), les premières censures, et les combats pour la liberté, par exemple le rôle de l'AUI, etc.

À propos de documentation, celle de l'accès au

CNAM par modem,

citée p. 55 et suivantes, est en ligne, en trois fichiers : acces-cnam-modems-1.pdf, acces-cnam-modems-2.pdf et acces-cnam-modems-3.pdf.

Question absurdités, le rapport Théry est évidemment mentionné, mais je pense que la prime revient à Philippe Val qui écrivait dans Charlie Hebdo en 2001 (p. 26 du livre) : « Qui est prêt à dépenser de l'argent à fonds perdus pour avoir son petit site personnel ? Des tarés, des maniaques, des fanatiques, des mégalomanes, des paranoïaques, des nazis, des délateurs [...] » Comme vous êtes en train de lire un « petit site personnel », je vous laisse chercher dans quelle(s) catégorie(s) est son auteur…

Les sources sont systématiquement citées, ce qui est normal pour une historienne, mais n'est pas toujours fait dans les livres parlant d'histoire de l'Internet. (Et qui répètent parfois en boucle des légendes, du genre c'est en France qu'on a inventé l'Internet. De telles légendes sont fréquentes dans les « histoires d'Internet », contrairement à ce livre, qui est très rigoureux.) Plus étonnant, des sources informelles sont très utilisées, notamment Usenet. C'est tout à fait justifié, vu le peu de sources formelles sur cette époque, mais c'est rare, Usenet est ignoré de la majorité des ouvrages et articles parlant d'Internet.

Pour ces citations tirées d'Usenet, Schafer n'a pas mis le nom de l'auteur·e de la citation. Le problème est complexe, car il faut arbitrer entre le droit d'auteur (citer l'auteur), la valeur historique du témoignage (qui dépend de qui parle) et le droit à la vie privée. Contrairement à un livre ou à un article dans un journal formel, l'auteur·e d'un message sur Usenet ne pensait pas forcément être retrouvé·e vingt ans après. Si vous voulez approfondir la question, l'auteure du livre recommande « Ethics and the Archived Web Presentation: “The Ethics of Studying GeoCities” » ou « Par-delà la dichotomie public/privé : la mise en visibilité des pratiques numériques et ses enjeux éthiques ».

Le fameux logo « En construction » orne logiquement la

couverture du livre :

Notez enfin que le site de l'Armada de la Liberté, mentionné p. 73, a été récemment remis en ligne à partir d'une sauvegarde personnelle dans le cadre d'une page d'histoire du CNAM à l'occasion d'une conférence. J'ai appris dans le livre de Valérie Schafer (p. 80) que le site Web du CNAM n'avait pas été le premier serveur Web en France, contrairement à ce que je répétais tout le temps. Heureusement que les historien·ne·s sont là pour vérifier.

Déclaration d'éventuel conflit d'intérêts : j'ai reçu (sans engagement) un exemplaire gratuit de ce livre par l'auteur.

L'article seul

RFC 8483: Yeti DNS Testbed

Date de publication du RFC : Octobre 2018

Auteur(s) du RFC : L. Song (Beijing Internet

Institute), D. Liu (Beijing Internet

Institute), P. Vixie (TISF), A. Kato

(Keio/WIDE), S. Kerr

Pour information

Première rédaction de cet article le 17 décembre 2018

Ce RFC décrit une expérience, celle qui, de mai 2015 à décembre 2018, a consisté à faire tourner une racine DNS alternative nommée Yeti. Contrairement aux racines alternatives commerciales qui ne sont typiquement que des escroqueries visant à vendre à des gogos des TLD reconnus par personne, Yeti était une expérience technique ; il s'agissait de tester un certain nombre de techniques qu'on ne pouvait pas se permettre de tester sur la « vraie » racine.

Parmi ces techniques, l'utilisation d'un grand nombre de

serveurs

racine (pour casser la légende comme quoi l'actuelle

limite à 13 serveurs aurait une justification technique),

n'utiliser qu'IPv6, jouer avec des

paramètres DNSSEC différents, etc. J'ai

participé à ce projet, à la fois comme gérant de deux des serveurs

racine, et comme utilisateur de la racine Yeti, reconfigurant des

résolveurs DNS pour utiliser Yeti. Les deux serveurs racines

dahu1.yeti.eu.org et

dahu2.yeti.eu.org appartenaient au groupe

Dahu, formé par l'AFNIC (cf. cet

article sur le site de l'AFNIC),

Gandi et eu.org. (Le

nom vient d'un animal aussi

mythique que le yéti.)

Outre l'aspect technique, un autre intéret de Yeti était qu'il s'agissait d'un projet international. Réellement international, pas seulement des états-uniens et des européens de divers pays ! Yeti est d'inspiration chinoise, la direction du projet était faite en Chine, aux États-Unis et au Japon, et parmi les équipes les plus impliquées dans le projet, il y avait des Russes, des Indiens, des Français, des Chiliens… Le projet, on l'a dit, était surtout technique (même si certains participants pouvaient avoir des arrière-pensées) et la zone racine servie par Yeti était donc exactement la même que celle de l'IANA, aux noms des serveurs et aux signatures DNSSEC près. Un utilisateur ordinaire de Yeti ne voyait donc aucune différence. Le projet étant de nature expérimentale, les utilisateurs étaient tous des volontaires, conscients des risques possibles (il y a eu deux ou trois cafouillages).

L'annexe E du RFC est consacrée aux controverses sur le principe même du projet Yeti. Le projet a toujours été discuté en public, et présenté à de nombreuses réunions. Mais il y a toujours des râleurs, affirmant par exemple que ce projet était une racine alternative (ce qui n'est pas faux mais attendez, lisez jusqu'au bout) et qu'il violait donc le RFC 2826. Outre que ce RFC 2826 est très contestable, il faut noter qu'il ne s'applique pas à Yeti ; il concerne uniquement les racines alternatives servant un contenu différent de celui de la racine « officielle » alors que Yeti a toujours été prévu et annoncé comme servant exactement la même racine (comme le faisait ORSN). Rien à voir donc avec ces racines alternatives qui vous vendent des TLD bidons, que personne ne pourra utiliser. Comme le disait Paul Vixie, Yeti pratique le Responsible Alternate Rootism. Notez quand même que certains participants à Yeti (notamment en Chine et en Inde) avaient des objectifs qui n'étaient pas purement techniques (s'insérant dans le problème de la gouvernance Internet, et plus spécialement celle de la racine).

La racine du DNS est quelque chose d'absolument critique pour le bon fonctionnement de l'Internet. Quasiment toutes les activités sur l'Internet démarrent par une ou plusieurs requêtes DNS. S'il n'y a plus de résolution DNS, c'est à peu près comme s'il n'y avait plus d'Internet (même si quelques services pair-à-pair, comme Bitcoin, peuvent encore fonctionner). Du fait de la nature arborescente du DNS, si la racine a un problème, le service est sérieusement dégradé (mais pas arrêté, notamment en raison des mémoires - les « caches » - des résolveurs). On ne peut donc pas jouer avec la racine, par exemple en essayant des idées trop nouvelles et peu testées. Cela n'a pas empêché la racine de changer beaucoup : il y a eu par exemple le déploiement massif de l'anycast, qui semblait inimaginable il y a dix-sept ans, le déploiement de DNSSEC (avec le récent changement de clé, qui s'est bien passé), ou celui d'IPv6, plus ancien. Le fonctionnement de la racine était traditionnellement peu ou pas documenté mais il y a quand même eu quelques documents utiles, comme le RFC 7720, la première description de l'anycast, ou les documents du RSSAC, comme RSSAC 001. Celle ou celui qui veut se renseigner sur la racine a donc des choses à lire.

Mais le point important est que la racine est un système en production, avec lequel on ne peut pas expérimenter à loisir. D'où l'idée, portée notamment par BII, mais aussi par TISF et WIDE, d'une racine alternative n'ayant pas les contraintes de la « vraie » racine. Yeti (section 1 du RFC) n'est pas un projet habituel, avec création d'un consortium, longues réunions sur les statuts, et majorité du temps passé en recherches de financement. C'est un projet léger, indépendant d'organismes comme l'ICANN, géré par des volontaires, sans structure formelle et sans budget central, dans la meilleure tradition des grands projets Internet. À son maximum, Yeti a eu 25 serveurs racine, gérés par 16 organisations différentes.

Au passage, puisqu'on parle d'un projet international, il faut noter que ce RFC a été sérieusement ralenti par des problèmes de langue. Eh oui, tout le monde n'est pas anglophone et devoir rédiger un RFC en anglais handicape sérieusement, par exemple, les Chinois.

Parmi les idées testées sur Yeti (section 3 du RFC) :

- Une racine alternative qui marche (avec supervision sérieuse ; beaucoup de services se présentant comme « racine alternative » ont régulièrement la moitié de leurs serveurs racine en panne),

- Diverses méthodes pour signer et distribuer la zone racine,

- Schémas de nommage pour les serveurs racine (dans la

racine IANA, tous les serveurs sont sous

root-servers.net), - Signer les zones des serveurs racine (actcuellement,

root-servers.netn'est pas signé), - Utiliser exclusivement IPv6,

- Effectuer des remplacements de clé (notamment en comptant sur le RFC 5011),

- Sans compter les autres idées décrites dans cette section 3 du RFC mais qui n'ont pas pu être testées.

La section 4 du RFC décrit l'infrastructure de Yeti. Elle a

évidemment changé plusieurs fois, ce qui est normal pour un

service voué aux expérimentations. Yeti utilise l'architecture

classique du DNS. Les serveurs racine sont remplacés par ceux de

Yeti, les autres serveurs faisant autorité (ceux de

.fr ou

.org, par exemple) ne

sont pas touchés. Les résolveurs doivent évidemment être

reconfigurés pour utiliser Yeti (d'une manière qui est documentée sur le site Web du projet). Au

démarrage, un résolveur ne connait en effet que la liste des noms

et adresses IP des serveurs de la racine. La racine « officielle »

est configurée par défaut et doit ici être remplacée (annexe A du RFC). Il faut

aussi changer la clé de la racine (la root trust

anchor) puisque Yeti signe avec sa propre clé.

Voici la configuration de mon résolveur à la maison, avec Knot sur une Turris Omnia :

config resolver 'common'

option keyfile '/etc/kresd/yeti-root.keys'

option prefered_resolver 'kresd'

config resolver 'kresd'

option rundir '/tmp/kresd'

option log_stderr '1'

option log_stdout '1'

option forks '1'

option include_config '/etc/kresd/custom.conf'

et custom.conf contient la liste des serveurs

racine :

hints.root({

['bii.dns-lab.net.'] = '240c:f:1:22::6',

['yeti-ns.tisf.net .'] = '2001:4f8:3:1006::1:4',

['yeti-ns.wide.ad.jp.'] = '2001:200:1d9::35',

['yeti-ns.as59715.net.'] = '2a02:cdc5:9715:0:185:5:203:53',

['dahu1.yeti.eu.org.'] = '2001:4b98:dc2:45:216:3eff:fe4b:8c5b',

['ns-yeti.bondis.org.'] = '2a02:2810:0:405::250',

['yeti-ns.ix.ru .'] = '2001:6d0:6d06::53',

['yeti.bofh.priv.at.'] = '2a01:4f8:161:6106:1::10',

['yeti.ipv6.ernet.in.'] = '2001:e30:1c1e:1::333',

['yeti-dns01.dnsworkshop.org.'] = '2001:1608:10:167:32e::53',

['yeti-ns.conit.co.'] = '2604:6600:2000:11::4854:a010',

['dahu2.yeti.eu.org.'] = '2001:67c:217c:6::2',

['yeti.aquaray.com.'] = '2a02:ec0:200::1',

['yeti-ns.switch.ch.'] = '2001:620:0:ff::29',

['yeti-ns.lab.nic.cl.'] = '2001:1398:1:21::8001',

['yeti-ns1.dns-lab.net.'] = '2001:da8:a3:a027::6',

['yeti-ns2.dns-lab.net.'] = '2001:da8:268:4200::6',

['yeti-ns3.dns-lab.net.'] = '2400:a980:30ff::6',

['ca978112ca1bbdcafac231b39a23dc.yeti-dns.net.'] = '2c0f:f530::6',

['yeti-ns.datev.net.'] = '2a00:e50:f15c:1000::1:53',

['3f79bb7b435b05321651daefd374cd.yeti-dns.net.'] = '2401:c900:1401:3b:c::6',

['xn--r2bi1c.xn--h2bv6c0a.xn--h2brj9c.'] = '2001:e30:1c1e:10::333',

['yeti1.ipv6.ernet.in.'] = '2001:e30:187d::333',

['yeti-dns02.dnsworkshop.org.'] = '2001:19f0:0:1133::53',

['yeti.mind-dns.nl.'] = '2a02:990:100:b01::53:0'

})

Au bureau, avec Unbound, cela donnait :

server:

auto-trust-anchor-file: "/var/lib/unbound/yeti.key"

root-hints: "yeti-hints"

Et yeti-hints est disponible en

annexe A du RFC (attention, comme le note la section 7 du RFC, à

utiliser une source fiable, et à le récupérer de manière sécurisée).

Comme Yeti s'est engagé à ne pas modifier le contenu de la zone racine (liste des TLD, et serveurs de noms de ceux-ci), et comme Yeti visait à gérer la racine de manière moins concentrée, avec trois organisations (BII, TISF et WIDE) signant et distribuant la racine, le mécanisme adopté a été :

- Les trois organisations copient la zone racine « normale »,

- En retirent les clés et les signatures DNSSEC et la liste des serveurs de la racine,

- Modifient le SOA,

- Ajoutent la liste des serveurs Yeti, les clés Yeti, et signent la zone,

- Les serveurs racine copient automatiquement cette nouvelle zone signée depuis un des trois DM (Distribution Master, section 4.1 du RFC).

Voici le SOA Yeti :

% dig SOA .

...

;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 45919

;; flags: qr rd ra ad; QUERY: 1, ANSWER: 2, AUTHORITY: 0, ADDITIONAL: 1

...

;; ANSWER SECTION:

. 86400 IN SOA www.yeti-dns.org. bii.yeti-dns.org. (

2018121600 ; serial

1800 ; refresh (30 minutes)

900 ; retry (15 minutes)

604800 ; expire (1 week)

86400 ; minimum (1 day)

)

. 86400 IN RRSIG SOA 8 0 86400 (

20181223050259 20181216050259 46038 .

BNoxqfGq5+rBEdY4rdp8W6ckNK/GAOtBWQ3P36YFq5N+

...

;; Query time: 44 msec

;; SERVER: 127.0.0.1#53(127.0.0.1)

;; WHEN: Sun Dec 16 16:01:27 CET 2018

;; MSG SIZE rcvd: 369

(Notez que l'adresse du responsable de la zone indique le

DM qui a été utilisé par ce résolveur particulier. Un autre

résolveur pourrait montrer un autre SOA, si le DM était différent.)

Comme les serveurs racine « officiels » n'envoient pas de message

NOTIFY (RFC 1996) aux

serveurs Yeti, la seule solution est d'interroger régulièrement

ces serveurs officiels. (Cela fait que Yeti sera toujours un peu

en retard sur la racine « officielle », cf. section 5.2.2.) Plusieurs de ces serveurs acceptent le

transfert de zone (RFC 5936), par exemple

k.root-servers.net :

% dig @k.root-servers.net AXFR . > /tmp/root.zone

% head -n 25 /tmp/root.zone

; <<>> DiG 9.11.3-1ubuntu1.3-Ubuntu <<>> @k.root-servers.net AXFR .

; (2 servers found)

;; global options: +cmd

. 86400 IN SOA a.root-servers.net. nstld.verisign-grs.com. (

2018121600 ; serial

1800 ; refresh (30 minutes)

900 ; retry (15 minutes)

604800 ; expire (1 week)

86400 ; minimum (1 day)

)

. 172800 IN DNSKEY 256 3 8 (

AwEAAdp440E6Mz7c+Vl4sPd0lTv2Qnc85dTW64j0RDD7

...

De son côté, l'ICANN gère deux machines qui

acceptent le transfert de zone,

xfr.cjr.dns.icann.org et

xfr.lax.dns.icann.org. On peut enfin

récupérer cette zone par FTP.

Pour l'étape de signature de la zone, Yeti a testé plusieurs façons de répartir le travail entre les trois DM (Distribution Masters) :

- Clés (KSK et ZSK) partagées entre tous les DM. Cela nécessitait donc de transmettre les clés privées.

- KSK unique mais une ZSK différente par DM (chacune étant signée par la KSK). Chacun garde alors la clé privée de sa ZSK. (Voir la section 5.2.3 pour quelques conséquences pratiques de cette configuration.)

Dans les deux cas, Yeti supprime la totalité des signatures de la racine « officielle » avant d'apposer la sienne. Il a été suggéré (mais pas testé) d'essayer d'en conserver une partie, pour faciliter la vérification du fait que Yeti n'avait pas ajouté ou retiré de TLD.

La configuration chez les DM et leur usage de git (les risques de sécurité que cela pose sont discutés en section 7) pour se synchroniser quand c'est nécessaire est documentée ici.

Les serveurs racine de Yeti n'ont plus ensuite qu'à récupérer la zone depuis un des DM ; chaque serveur racine peut utiliser n'importe quel DM et en changer, de façon à éviter de dépendre du bon fonctionnement d'un DM particulier. Voici par exemple la configuration d'un serveur NSD :

server:

ip-address: 2001:4b98:dc2:45:216:3eff:fe4b:8c5b

nsid: "ascii_dahu1.yeti.eu.org"

# RFC 8201

ipv6-edns-size: 1460

zone:

name: "."

outgoing-interface: 2001:4b98:dc2:45:216:3eff:fe4b:8c5b

# We use AXFR (not the default, IXFR) because of http://open.nlnetlabs.nl/pipermail/nsd-users/2016-February/002243.html

# BII

request-xfr: AXFR 240c:f:1:22::7 NOKEY

allow-notify: 240c:f:1:22::7 NOKEY

# TISF

request-xfr: AXFR 2001:4f8:3:1006::1:5 NOKEY

allow-notify: 2001:4f8:3:1006::1:5 NOKEY

# WIDE

request-xfr: AXFR 2001:200:1d9::53 NOKEY

allow-notify: 2001:200:1d9::53 NOKEY

Notez que la configuration réseau était un peu plus complexe, la

machine ayant deux interfaces, une de service, pour les requêtes

DNS, et une d'aministration, pour se connecter via

ssh. Il fallait s'assurer que les messages

DNS partent bien par la bonne interface réseau, donc faire du

routage selon l'adresse IP source. Le fichier de configuration

Linux pour cela est yeti-network-setup.sh

Contrairement aux serveurs de la racine « officielle », qui

sont tous sous le domaine root-servers.net,

ceux de Yeti, ont des noms variés. Le suffixe identique permet,

grâce à la compression des noms (RFC 1035,

section 4.1.4 et RSSAC

023)

de gagner quelques octets sur la taille des messages DNS. Yeti

cherchant au contraire à tester la faisabilité de messages DNS

plus grands, cette optimisation n'était pas utile.

Une des conséquences est que la réponse initiale à un résolveur (RFC 8109) est assez grande :

% dig @bii.dns-lab.net. NS .

...

;; SERVER: 240c:f:1:22::6#53(240c:f:1:22::6)

;; MSG SIZE rcvd: 1591

On voit qu'elle dépasse la MTU

d'Ethernet. Certains serveurs, pour

réduire la taille de cette réponse, n'indiquent pas la totalité

des adresses IP des serveurs racine (la colle) dans la

réponse. (BIND, avec

minimum-responses: yes n'envoie même aucune

adresse IP, forçant le résolveur à effectuer des requêtes pour les

adresses IP des serveurs). Cela peut augmenter la latence avant

les premières résolutions réussies, et diminuer la robustesse (si

les serveurs dont l'adresse est envoyée sont justement ceux en

panne). Mais cela n'empêche pas le DNS de fonctionner et Yeti,

après discussion, a décidé de ne pas chercher à uniformiser les

réponses des serveurs racine.

Au moment de la publication du RFC, Yeti avait 25 serveurs racine gérés dans 16 pays différents (section 4.6 du RFC), ici vus par check-soa (rappelez-vous qu'ils n'ont que des adresses IPv6) :

% check-soa -i .

3f79bb7b435b05321651daefd374cd.yeti-dns.net.

2401:c900:1401:3b:c::6: OK: 2018121400 (334 ms)

bii.dns-lab.net.

240c:f:1:22::6: OK: 2018121400 (239 ms)

ca978112ca1bbdcafac231b39a23dc.yeti-dns.net.

2c0f:f530::6: OK: 2018121400 (170 ms)

dahu1.yeti.eu.org.

2001:4b98:dc2:45:216:3eff:fe4b:8c5b: OK: 2018121400 (18 ms)

dahu2.yeti.eu.org.

2001:67c:217c:6::2: OK: 2018121400 (3 ms)

ns-yeti.bondis.org.

2a02:2810:0:405::250: OK: 2018121400 (24 ms)

xn--r2bi1c.xn--h2bv6c0a.xn--h2brj9c.

2001:e30:1c1e:10::333: OK: 2018121400 (188 ms)

yeti-ns.as59715.net.

2a02:cdc5:9715:0:185:5:203:53: OK: 2018121400 (43 ms)

yeti-ns.datev.net.

2a00:e50:f155:e::1:53: OK: 2018121400 (19 ms)

yeti-ns.ix.ru.

2001:6d0:6d06::53: OK: 2018121400 (54 ms)

yeti-ns.lab.nic.cl.

2001:1398:1:21::8001: OK: 2018121400 (228 ms)

yeti-ns.switch.ch.

2001:620:0:ff::29: OK: 2018121400 (16 ms)

yeti-ns.tisf.net.

2001:4f8:3:1006::1:4: OK: 2018121400 (175 ms)

yeti-ns.wide.ad.jp.

2001:200:1d9::35: OK: 2018121400 (258 ms)

yeti-ns1.dns-lab.net.

2400:a980:60ff:7::2: OK: 2018121400 (258 ms)

yeti-ns2.dns-lab.net.

2001:da8:268:4200::6: OK: 2018121400 (261 ms)

yeti-ns3.dns-lab.net.

2400:a980:30ff::6: OK: 2018121400 (268 ms)

yeti.aquaray.com.

2a02:ec0:200::1: OK: 2018121400 (4 ms)

yeti.bofh.priv.at.

2a01:4f8:161:6106:1::10: OK: 2018121400 (31 ms)

yeti.ipv6.ernet.in.

2001:e30:1c1e:1::333: OK: 2018121400 (182 ms)

yeti.jhcloos.net.

2001:19f0:5401:1c3::53: OK: 2018121400 (108 ms)

yeti.mind-dns.nl.

2a02:990:100:b01::53:0: OK: 2018121400 (33 ms)

Notez que l'un d'eux a un nom IDN,

मूल.येती.भारत (affiché par

check-soa comme

xn--r2bi1c.xn--h2bv6c0a.xn--h2brj9c). 18 des

serveurs sont des VPS, le reste étant des

machines physiques. 15 utilisent le noyau

Linux, 4 FreeBSD, 1

NetBSD et 1 (oui, oui) tourne sur

Windows. Question logiciel, 16 utilisent

BIND, 4 NSD, 2

Knot, 1 Bundy

(l'ex-BIND 10), 1 PowerDNS et 1

Microsoft DNS.

Pour tester que la racine Yeti fonctionnait vraiment, il ne suffisait évidemment pas de faire quelques dig, check-soa et tests avec les sondes RIPE Atlas. Il fallait un trafic plus réaliste. Certains résolveurs (dont les miens, à la maison et au bureau) ont été configurés pour utiliser la racine Yeti et fournissaient donc un trafic réel, quoique faible. En raison des caches des résolveurs, le trafic réel ne représentait que quelques dizaines de requêtes par seconde. Il était difficile d'augmenter ce nombre, Yeti étant une racine expérimentale, où des choses risquées étaient tentées, on ne pouvait pas utiliser des résolveurs de production. Il a donc fallu aussi injecter du trafic artificiel.

Tout le trafic atteignant les serveurs racines Yeti était capturé (c'est une autre raison pour laquelle on ne pouvait pas utiliser les résolveurs de production ; Yeti voyait toutes leurs requêtes à la racine) et étudié. Pour la capture, des outils comme dnscap ou pcapdump (avec un petit patch) étaient utilisés pour produire des pcap, ensuite copiés vers BII avec rsync.

La section 5 du RFC décrit les problèmes opérationnels qu'a

connu Yeti. Si vous voulez tous les détails, vous pouvez regarder

les

archives de la liste de diffusion du projet, et le blog du

projet. D'abord, ce qui concerne

IPv6. Comme d'habitude, des ennuis sont

survenus avec la fragmentation. En raison

du nombre de serveurs racine, et de l'absence de schéma de nommage

permettant la compression, les réponses Yeti sont souvent assez

grandes pour devoir être fragmentées (1 754 octets avec toutes les

adresses des serveurs racine, et 1 975 avec le mode « une ZSK par

DM »). Cela ne serait pas un problème (la fragmentation des

datagrammes étant spécifiée dans

IPv4 et IPv6 depuis

le début) si tout le monde configurait son réseau

correctement. Hélas, beaucoup d'incompétents et de maladroits ont

configuré leurs systèmes pour bloquer les fragments IP, ou pour

bloquer les messages ICMP nécessaires à la

découverte de la MTU du chemin (RFC 8201). Ce triste état des choses a été décrit dans le

RFC 7872, dans draft-taylor-v6ops-fragdrop, et dans

« Dealing

with IPv6 fragmentation in the DNS ». Il a même

été proposé de ne jamais

envoyer de datagrammes de taille supérieure à 1 280

octets.

En pratique, le meilleur contournement de ce problème est de réduire la taille maximale des réponses EDNS. Par exemple, dans NSD :

ipv6-edns-size: 1460

Les réponses resteront à moins de 1 460 octets et ne seront donc en général pas fragmentées.

Les transferts de zone depuis les DM ont levé quelques

problèmes. Les zones sont légèrement différentes d'un DM à l'autre

(SOA et surtout signatures). Les transferts de zone

incrémentaux (IXFR, RFC 1995), ne peuvent

donc pas être utilisés : si un serveur racine interroge un DM,

puis un autre, les résultats seront incompatibles. Ce cas, très

spécifique à Yeti, n'est pas pris en compte par les logiciels. Les serveurs

doivent donc utiliser le transfert complet (AXFR) uniquement (d'où

le AXFR dans la configuration du serveur

racine NSD vue plus haut). Ce

n'est pas très grave, vu la petite taille de la zone racine.

Lors des essais de remplacement de la KSK (on sait que, depuis

la parution de ce RFC, la KSK

de la racine « officielle » a été successivement

remplacée le 11 octobre 2018) quelques problèmes sont

survenus. Par exemple, la documentation de BIND n'indiquait pas,

lorsque le résolveur utilise l'option

managed-keys, que celle-ci doit être configurée

dans toutes les vues. (Au passage, j'ai toujours trouvé que les vues sont

un système compliqué et menant à des erreurs déroutantes.)

La capture du trafic DNS avec les serveurs racine Yeti a

entrainé d'autres problèmes (section 5.4 du RFC). Il existe

plusieurs façons d'enregistrer le trafic d'un serveur de noms, de

la plus courante (tcpdump avec l'option

-w) à la plus précise

(dnstap). dnstap étant encore peu répandu

sur les serveurs de noms, Yeti a utilisé une capture « brute » des

paquets, dans des fichiers pcap qu'il

fallait ensuite analyser. L'un des problèmes avec les fichiers

pcap est qu'une connexion TCP, même d'une seule requête, va se

retrouver sur plusieurs paquets, pas forcément consécutifs. Il

faudra donc réassembler ces connexions TCP, par exemple avec un

outil développé pour Yeti, PcapParser

(décrit plus longuement dans l'annexe D de notre RFC).

Les serveurs racine changent de temps en temps. Dans la racine

« officielle », les changements des noms sont très rares. En

effet, pour des raisons politiques, on ne peut pas modifier la

liste des organisations qui gèrent un serveur racine. Vouloir

ajouter ou retirer une organisation déclencherait une crise du

genre « pourquoi lui ? ». L'ICANN est donc

paralysée sur ce point. Mais les serveurs changent parfois

d'adresse IP. C'est rare, mais ça arrive. Si les résolveurs ne

changent pas leur configuration, ils auront une liste

incorrecte. Un exemple de la lenteur avec laquelle se diffusent

les changements d'adresses IP des serveurs racine est le cas de

j.root-servers.net qui, treize

ans après son changement d'adresse IP, continue

à recevoir du trafic à l'ancienne adresse. Ceci dit, ce

n'est pas très grave en pratique, car, à l'initialisation du

résolveur (RFC 8109), le résolveur reçoit du

serveur racine consulté une liste à jour. Tant que la liste qui

est dans la configuration du résolveur ne dévie pas trop de la

vraie liste, il n'y a pas de problème, le résolveur finira par

obtenir une liste correcte.

Mais Yeti est différent : les changements sont beaucoup plus

fréquents et, avec eux, le risque que la liste connue par les

résolveurs dévie trop. D'où la création d'un outil spécial, hintUpdate

(personnellement, je ne l'ai jamais utilisé, je modifie la

configuration du résolveur, c'est tout). Un point intéressant

d'hintUpdate est qu'il dépend de DNSSEC

pour vérifier les informations reçues. Cela marche avec Yeti, où

les noms des serveurs racine sont (théoriquement) signés, mais cela ne

marcherait pas avec la racine officielle,

root-servers.net n'étant pas signé.

Dernier problème, et rigolo, celui-ci, la compression inutile. En utilisant le logiciel Knot pour un serveur racine, nous nous sommes aperçus qu'il comprimait même le nom de la zone racine, faisant passer sa taille de un à deux octets. Une compression négative donc, légale mais inutile. À noter que cela plantait la bibliothèque Go DNS. Depuis, cette bibliothèque a été rendue plus robuste, et Knot a corrigé cette optimisation ratée.

La conclusion du RFC, en section 6, rappelle l'importance de disposer de bancs de test, puisqu'on ne peut pas faire courir de risques à la racine de production. La conclusion s'achève en proposant de chercher des moyens de rendre le DNS moins dépendant de la racine actuelle. Et, vu la mode actuelle, le mot de chaîne de blocs est même prononcé…

L'article seul

APIdays et mon exposé sur Internet et les droits humains

Première rédaction de cet article le 13 décembre 2018

Dernière mise à jour le 31 mars 2019

Les 11 et 12 décembre 2018, à Paris (enfin, à Montrouge), s'est tenue une édition des API Days, conférence consacrée aux API. J'y ai parlé (en anglais) d'Internet et de ses rapports avec les droits humains.

Globalement, API days verse un peu trop dans le techno-optimisme et la cyber-béatitude : les API vont sauver le monde, la société va devenir « programmable », l'Estonie est le modèle (comme l'était l'URSS pour les communistes, l'Estonie est toujours présentée comme modèle par les startupeurs et les partisans du E-nimportequoi). Les orateurs sont heureux, actifs, ont des titres rigolos (API evangelist…), ont un sourire de publicité pour dentifrice, et répètent en boucle que tout est amazing.

Heureusement, il y a quelques séances moins consensuelles. J'ai particulièrement apprécié la keynote de fin par Jean-Marc Jancovici, sur l'énergie et le climat. Jancovici est un remarquable conférencier, très amateur de petites phrases qui claquent, et illustre son exposé de nombreux chiffres et diagrammes. Il a démoli l'idée qu'on pourrait éviter ou limiter le changement climatique avec juste quelques mesurettes, comme aiment annoncer certaines entreprises du secteur de l'informatique. Notre dépendance aux énergies fossiles, et à des matériaux rares comme l'indium est profondément enracinée et changer les choses va nécessiter des sacrifices douloureux (l'alternative étant une crise climatique grave, avec guerres, on voit que le conférencier était un optimiste). Les machines sont tellement utiles et tellement puissantes, qu'à part des mesures brutales et immorales, comme de rétablir l'esclavage (et encore : les esclaves sont beaucoup moins productifs que les machines), la limitation du réchauffement planétaire va être difficile. (L'orateur ne croit pas aux énergies renouvelables, très insuffisantes par rapport à la demande. Elles sont réalistes - après tout, l'humanité a vécu pendant la plus grande partie de l'histoire en ne consommant que des ressources renouvelables - mais pas adaptées à notre mode de vie.)

Jancovici a aussi démoli la théorie cyber-optimiste comme quoi l'informatique pourrait aider à lutter contre le changement climatique, par exemple par une meilleure allocation des ressources. C'est le contraire qui est vrai : l'informatique, outre sa consommation propre, qui n'est pas nulle, permet une plus grande consommation de ressources non-renouvelables. Ainsi, en permettant un trafic aérien intense, elle contribue à un secteur, le transport, qui est un des plus gros responsables de l'émission de gaz à effet de serre. Jancovici a estimé qu'au contraire, il allait falloir réduire les usages, changer moins souvent d'ordiphone, et ne pas déployer certaines technologies gaspilleuses comme la 5G.

Mon exposé était nettement plus banal, il portait sur les rapports entre l'Internet et les droits humains. Les supports sont en anglais. Voici la version PDF, et le source en LaTeX. Tout a été filmé et est disponible sur le site Web d'API days et sur YouTube.

L'article seul

Détails techniques sur l'écriture de mon livre « Cyberstructure »

Première rédaction de cet article le 12 décembre 2018

Comme vous avez pu le voir dans un autre article, j'ai écrit un livre nommé « Cyberstructure » et qui parle des relations entre l'architecture technique de l'Internet et les questions politiques. Ce nouvel article est destiné uniquement aux détails techniques de l'écriture, pour ceux et celles qui se demandent « tu as utilisé quel logiciel pour faire ce livre ? ». Je ne parlerai donc pas ici du contenu du livre.

D'abord, pour les outils utilisés, il faut bien voir que l'auteur n'a pas une liberté complète puisqu'un livre est un travail collectif. Il faut donc une discussion avec l'éditeur, du moins si, comme moi, on a un éditeur qui se penche sur le texte, au lieu de demander à l'auteur des images qu'on imprimera telles quelles. D'autre part, dans mon cas, la mise en page était faite par l'éditeur (avec InDesign), donc je n'avais pas à me soucier du rendu, je pouvais me concentrer sur le texte. Enfin, certains choix ne concernaient que moi, puisqu'ils ne changeaient rien à ce qui était échangé avec l'éditeur.

Les choix importants, après cette discussion, étaient :

Pourquoi ces choix ? Commençons par le format XML. C'est un format simple pour l'auteur, bien adapté au texte (contrairement à JSON) grâce notamment à la possibilité de mélanger élements structurés et texte, comme par exemple :

<p>L'ARJEL, l'autorité de régulation des jeux en ligne, a été, sauf erreur, la première autorité ayant ce droit de censurer, sur la base du décret <cite url="https://www.legifrance.gouv.fr/eli/decret/2011/12/30/BCRB1120950D/jo/texte">n° 2011-2122 du 30 décembre 2011 relatif aux modalités d'arrêt de l'accès à une activité d'offre de paris ou de jeux d'argent et de hasard en ligne non autorisée</cite>. [...] C'est ainsi que des sites distribuant des fichiers « torrent » <ref target="bittorrent">pour une explication</ref> comme The Pirate Bay ou T411 ont fait l'objet de décisions de justice imposant leur blocage.</p>

Et, contrairement à JSON, on peut y mettre des commentaires, ce qui aide beaucoup l'auteur au long des mois de réécriture et de modifications. La discussion avec l'éditeur a permis de s'assurer qu'InDesign pouvait importer du XML sans mal, et le choix de XML a donc été en partie guidé par l'éditeur. (Par exemple, il n'y avait pas de moyen simple d'importer du LaTeX. LaTeX repose sur un langage de programmation complet, qui est donc difficile à importer, sauf à utiliser le moteur TeX. XML, au contraire, ce ne sont que des données, sans programme.)

La mise en page étant faite par l'éditeur, il était important

que je me limite au marquage sémantique. Par exemple

<p>Le RFC 7962, <work xml:lang="en"

url="https://www.rfc-editor.org/info/rfc7962">Alternative

Network Deployments: Taxonomy, Characterization, Technologies, and

Architectures</work>, sans préjuger de comment

serait rendu le titre du document cité : on indique que c'est un

titre, on indique la langue, et la personne qui fera la mise en

page pourra suivre les bonnes pratiques de la mise en page,

indépendamment du contenu. Les éléments XML possibles et leurs

relations sont mises dans un schéma, écrit en Relax

NG. Ce schéma est conçu uniquement pour ce livre, et je

n'ai pas cherché à le faire beau ou propre ou général. Si vous

voulez le voir, il est dans le fichier livre.rnc. Je teste la conformité du texte au schéma avec

rnv :

% rnv livre.rnc livre-noent.xml

%

Un autre avantage de XML par rapport à LaTeX, dans ce contexte,

est qu'il est facile de développer des outils traitant le XML et

effectuant certaines opérations. Par exemple, j'ai fait un

programme XSLT pour n'extraire que le texte

du livre, afin de compter caractères et mots. En revanche, LaTeX

est certainement imbattable quand il faut faire une jolie sortie

PDF ou papier sans trop y passer de

temps. Et la plupart des relecteurs, à commencer par moi, ont

préféré travailler sur cette sortie que sur le source XML. Pas de

difficulté, encore un autre programme XSLT, pour convertir le XML

en LaTeX, qui était ensuite traité. Voici ce programme : tolatex.xsl, mais rappelez-vous que ce n'est pas lui qui a

été utilisé pour le rendu final du livre. (Pour faire tourner ce

programme XSLT, j'ai utilisé xsltproc, dans

la

libxslt. Au passage, certains des

outils étaient d'usage compliqué donc j'ai utilisé le classique

make pour orchestrer leur exécution.)

Notez que les techniques utilisée pour le livre étaient assez proches, voire identiques, à celles de mon blog ce qui n'est évidemment pas un hasard. Les techniques du blog sont déjà documentées.

Apparemment, la plupart des auteurs de livres utilisent plutôt un gros cliquodrome comme Word ou LibreOffice. Mais je n'aime pas ces logiciels (j'avais déjà critiqué leur approche afterword il y a plus de dix-sept ans.)

Le XML a l'avantage, comme JSON ou LaTeX, d'être un format texte, donc qui peut être traité avec tous les outils existants. C'est par exemple le cas du choix de l'éditeur (l'éditeur de textes, pas l'éditeur du livre). Pas besoin de concertation, cette fois, ce choix de l'éditeur de textes est purement local et n'affecte pas ce qui est envoyé à l'éditeur du livre. J'ai donc utilisé mon éditeur préféré, emacs. On peut écrire du XML avec le mode de base d'Emacs mais ce n'est pas très amusant (taper le début de l'élement XML, sa fin, penser à bien fermer tout ce qui a été ouvert), il vaut donc mieux utiliser un mode Emacs adapté au XML. J'ai utilisé nxml-mode. À part le fait qu'il économise du temps de frappe, et qu'il affiche le source XML proprement coloré (les noms des éléments en bleu, les commentaires en rouge, pour les distinguer du texte), le gros avantage de nxml-mode est qu'il connait Relax NG, et qu'une fois configuré pour utiliser mon schéma, il peut guider l'écriture, indiquant quels sont les éléments XML acceptables à l'endroit où se trouve le curseur, et validant le résultat au fur et à mesure. Grâce à cela, la validation XML complète, faite avec rnv, était quasiment inutile.

Le schéma XML que j'avais fait me semblait raisonnable, avec un

usage intelligent des éléments et des attributs XML (un sujet toujours

passionnel dans le monde XML). Mais lors de l'importation dans InDesign, un

problème est apparu : sauf exception, InDesign

ne permet pas de mettre du contenu dans les attributs. Il a donc fallu transformer plusieurs attributs en éléments,

avec le programme XSL toindesign.xsl.

Contrairement à mon blog, où certains articles ont été écrits d'une seule traite, ce livre a fait l'objet de retours, de révisions, de critiques et de remords. Il a donc fallu le modifier plusieurs fois, et parfois remettre en place des paragraphes que j'avais effacé quelques jours plus tôt. L'outil idéal pour cela est évidemment le VCS. Comme VCS, j'ai choisi darcs. Il est moins connu que git mais bien plus facile à utiliser. Il ne fournit pas de mécanisme de coopération pratique, mais ce n'est pas grave ici, puisque j'étais seul à travailler sur le texte. Le reproche que j'ai le plus entendu sur darcs est qu'il n'a pas le concept de branches. Cela me parait plutôt un avantage : d'abord, les branches sont très compliquées à utiliser, et ensuite un VCS décentralisé, comme git ou darcs, n'a pas vraiment besoin de branches : il suffit de faire des dépôts différents.

Comme tous les VCS, darcs permet de voir l'historique d'un travail :

patch f1c1609a11c27b0a125057f3afe0e91d537f1fdb Author: stephane@sources.org Date: Sun Dec 10 17:54:48 CET 2017 * Traduction en XML de plan, avant-propos et middleboxes, rédaction de utilisateurs patch 28b1ff5fef2d627f662d41cabda249bb585fec69 Author: stephane@sources.org Date: Sun Dec 10 12:20:17 CET 2017 * Début de la version XML patch 7e38de35163eccb6365502ec0ad189dcd3af5446 Author: stephane@sources.org Date: Wed Nov 29 10:16:05 CET 2017 * Questions à l'éditeur patch 67e7a11537ccc3d5d0b02d4bf83a3ae051bca25d Author: stephane@sources.org Date: Wed Nov 22 16:20:17 CET 2017 * Article middleboxes patch 3e71659b7b880f5cad02a441368a0e753b36de15 Author: stephane@sources.org Date: Sun Nov 5 17:13:40 CET 2017 * Début du travail sur le livre

Cela permet aussi de voir combien de commits sont faits :

% darcs changes . --count Changes to Livre: 485

(Oui, on aurait pu faire darcs changes . | grep Date | wc -l .)

Comme toutes les métriques quantitatives d'un travail humain, ce

chiffre n'a guère de signification ; il dépend de si on commite

souvent ou seulement à la fin de la journée, par exemple. C'est

juste amusant.

Un avantage important d'un VCS réparti (comme darcs ou git) est que chaque copie locale est un historique complet du travail. Tout est donc automatiquement réparti sur chaque machine (le PC fixe à la maison, le portable en déplacement, plus une ou deux machines hébergées à l'extérieur, et une clé USB…), ce qui est une forme efficace de sauvegarde. J'ai vu plus d'une fois un étudiant perdre toute sa thèse parce que les fichiers se trouvaient sur une seule machine, en panne, perdue ou volée, pour ne pas avoir envie de faire comme eux. Et l'utilisation du VCS réparti pour cela est moins pénible que la plupart des systèmes de sauvegarde.

J'ai dit plus haut que les métriques quantitatives n'avaient guère de sens ; l'avancement du travail ne se mesure pas au nombre de caractères tapés ! Si ces métriques sont assez ridicules quand des chefs de projet prétendent les utiliser pour suivre le travail de leurs subordonnés, elles sont quand même utiles à l'auteur qui :

- Sait quelle confiance limitée il faut leur accorder,

- A envie de suivre un peu ce qu'il fait.

J'ai donc écrit quelques scripts très simples pour compter quelques trucs

que je trouve utiles. Pour compter le nombre de caractères, je me

sers d'un programme XSLT, totext.xsl, qui garde

uniquement le texte avant de passer à wc (utiliser wc

sur le fichier XML compterait en trop toutes les balises XML) :

% make count xsltproc totext.xsl livre-noent.xml > livre.txt wc -c livre.txt 577930 livre.txt

Je marque les choses à faire dans le texte avec la chaîne de

caractères « TODO » (à faire). Il y a donc aussi des scripts pour

compter ces TODO. Par exemple, make count

comptait aussi les TODO :

% make count xsltproc totext.xsl livre-noent.xml > livre.txt wc -c livre.txt 432717 livre.txt Encore 59 TODO

Le source du livre était découpé en plusieurs fichiers, donc il était utile pour moi de savoir quels fichiers avaient le plus de TODO, avec grep et sort :

% make todo grep -c TODO *xml | grep -v ':0$' | sort -r -n -t: -k 2 neutralite.xml:8 censure.xml:7 technique.xml:6 gouvernance.xml:5 blockchain.xml:5 droitshumains.xml:4 securite.xml:3 plateformes.xml:3 adresse-ip-exposee.xml:3 acces.xml:3 ...

Il était également utile pour moi de compter la proportion de TODO par fichier (certains sont plus gros que d'autres) :

% ./todo-pct.sh protocoles.xml:3 gouvernance.xml:2 finances.xml:0 ...

(Oui, le script est disponible ici.)

Le livre bénéficie d'un site Web d'accompagnement,

https://cyberstructure.fr/

LogFormat "%u %t \"%r\" %>s %O \"%{Referer}i\" %v" minimum

CustomLog /var/log/apache2/access_cyberstructure.log minimum

Ce qui donne dans le journal des lignes comme :

- [19/Dec/2018:01:33:31 +0100] "GET / HTTP/1.1" 200 6420 "https://www.bortzmeyer.org/livre-publie.html" cyberstructure.fr

Je n'ai pas utilisé de correcteur orthographique. Il en existe en logiciel libre comme aspell mais je les trouve peu utiles : je fais relativement peu de fautes d'orthographe, j'ai d'excellents correcteurs humains, et il y a beaucoup de termes techniques dans le livre que le correcteur informatique ne connait pas, ce qui aurait rendu son utilisation pénible. (Il faut ajouter plein de mots à la première utilisation.)

% aspell check -l FR livre.txt

(Il faut avoir installé le paquetage

aspell-fr pour avoir les mots français.)

Je ne suis pas bon pour les dessins (disons même que je suis franchement nul). Les schémas ont donc été faits de manière sommaire avec Asymptote, puis refaits proprement par un graphiste professionnel.

D'autres articles écrits par des auteurs de livre ayant des cahiers des charges comparables :

- « Writing a Book with Pandoc, Make, and Vim ».

- Christophe Masutti sur son livre « Affaires privées ».

- L'exposé de Marina Fernández de Retana au Capitole du Libre 2019 sur ses romans et comment elle les écrit : regardez cet exposé sur YouTube.

L'article seul

RFC 8427: Representing DNS Messages in JSON

Date de publication du RFC : Juillet 2018

Auteur(s) du RFC : P. Hoffman (ICANN)

Pour information

Première rédaction de cet article le 11 décembre 2018

Le format des messages DNS circulant sur le réseau est un format binaire, pas forcément évident à analyser. Pour beaucoup d'applications, il serait sans doute préférable d'utiliser un format normalisé et plus agréable, par exemple JSON, dont ce nouveau RFC décrit l'utilisation pour le DNS.

Non seulement le format des messages DNS est du binaire (RFC 1035, section 4) et non pas du texte comme par exemple pour SMTP, XMPP ou HTTP, mais en plus il y a des pièges. Par exemple, la longueur des sections du message est indiquée dans un champ séparé de la section, et peut ne pas correspondre à la vraie longueur. La compression des noms n'arrange rien. Écrire un analyseur de messages DNS est donc difficile.

Il y a un million de formats pour des données structurées mais, aujourd'hui, le format texte le plus populaire pour ces données est certainement JSON, normalisé dans le RFC 8259. L'utilisation de JSON pour représenter les messages DNS (requêtes ou réponses) suit les principes suivants (section 1.1 du RFC) :

- Tout est optionnel, on peut donc ne représenter qu'une

partie d'un message. (Des profils ultérieurs de cette

spécification pourraient être

plus rigoureux, par exemple une base de

passive DNS peut

imposer que

QNAME, le nom de domaine demandé, soit présent, cf. section 6 du RFC.) - Si l'information est présente, on peut recréer le format binaire utilisé par le protocole DNS à partir du JSON (pas forcément bit pour bit, surtout s'il y avait de la compression).

- Tous les noms sont représentés dans le sous-ensemble ASCII d'UTF-8, obligeant les IDN à être en Punycode (alors que JSON permet l'UTF-8).

- Les données binaires peuvent être stockées, à condition d'être encodées en Base16 (RFC 4648).

- Il n'y a pas de forme canonique : le même message DNS peut être représenté par plusieurs objets JSON différents.

- Certains membres des objets JSON sont redondants et il peut donc y avoir des incohérences (par exemple entre la longueur indiquée d'une section ou d'un message, et sa longueur réelle, cf. la section 8 sur les conséquences que cela a pour la sécurité). Cela est nécessaire pour reconstituer certains messages DNS malformés. Autrement, le format serait limité aux messages corrects.

- Le format représente des messages, pas des fichiers de zone (RFC 1035, section 5).

La section 2 du RFC donne la liste des membres (au sens JSON de

« champs d'un objet ») d'un objet DNS. Voici un exemple d'un tel

objet, une requête DNS demandant l'adresse IPv4 (code 1, souvent

noté A) d'example.com :

{ "ID": 19678, "QR": 0, "Opcode": 0,

"AA": 0, "TC": 0, "RD": 0, "RA": 0, "AD": 0, "CD": 0, "RCODE": 0,

"QDCOUNT": 1, "ANCOUNT": 0, "NSCOUNT": 0, "ARCOUNT": 0,

"QNAME": "example.com", "QTYPE": 1, "QCLASS": 1

}

Les noms des membres sont ceux utilisés dans les

RFC DNS, même s'ils

ne sont pas très parlants (RCODE au lieu

ReturnCode).

On note que les différents membres qui sont dans le DNS

représentés par des entiers le sont également ici, au lieu

d'utiliser les abréviations courantes. Ainsi,

Opcode est marqué 0 et pas Q

(query), et QTYPE

(query type) est marqué 1 et pas A (adresse

IPv4). Cela permet de représenter des valeurs inconnues, qui n'ont

pas d'abréviation textuelle, même si ça rend le résultat peu

lisible si on ne connait pas les valeurs des

paramètres DNS par coeur.

Les valeurs d'un seul bit (booléens) sont représentés par 0 ou

1, pas par les false ou

true de JSON. (J'avoue ne pas bien comprendre ce choix.)

On note également que les longueurs des sections sont indiquées

explicitement, ici QDCOUNT (Query

Count, et ne me demandez pas à quoi sert le D après le

Q, le RFC 1035 ne l'explique pas). En JSON,

cela n'est pas obligatoire (la longueur d'un tableau, en JSON,

n'est pas spécifiée explicitement) mais, comme expliqué plus haut,

cela a été décidé pour permettre de représenter des messages DNS

anormaux, par exemple ayant un QDCOUNT de 0

et une question dans la section Question (cf. section 8 du RFC sur

les conséquences que cela peut avoir pour la sécurité). De tels messages

arrivent assez souvent dans le trafic DNS réel vu par les serveurs

connectés à l'Internet ; attaque délibérée ou bien logiciel écrit

avec les pieds ?

Et voici un exemple de réponse (QR = 1)

DNS en JSON. La requête a été un succès

(RCODE = 0) :

{ "ID": 32784, "QR": 1, "AA": 1, "RCODE": 0,

"QDCOUNT": 1, "ANCOUNT": 2, "NSCOUNT": 1,

ARCOUNT": 0,

"answerRRs": [ { "NAME": "example.com.",

"TYPE": 1, "CLASS": 1,

"TTL": 3600,

"RDATAHEX": "C0000201" },

{ "NAME": "example.com.",

"TYPE": 1, "CLASS": 1,

"TTL": 3600,

"RDATAHEX": "C000AA01" } ],

"authorityRRs": [ { "NAME": "ns.example.com.",

"TYPE": 1, "CLASS": 1,

"TTL": 28800,

"RDATAHEX": "CB007181" } ]

La réponse contient un ensemble d'adresses IP

(TYPE = 1 identifie une adresse IPv4),

192.0.2.1 et 192.0.170.1. Leur

valeur est encodée en hexadécimal. C'est

moins joli que si on avait mis l'adresse IP en clair mais c'est

plus général : cela permet d'inclure immédiatement de nouveaux

types de données, au détriment de la lisibilité pour les anciens

types.

Le format de ce RFC permet aussi de décrire l'association entre

une requête et une réponse (section 3 du RFC). On les met dans un

objet JSON ayant un membre queryMessage et un

responseMessage.

Si on représente une suite continue de messages DNS, faire un objet JSON avec son accolade ouvrante et la fermante correspondante peut ne pas être pratique. On utilise alors les séquences du RFC 7464, décrites dans la section 4 de notre RFC.

Notre RFC spécifie également (section 7) un type

MIME pour le DNS en JSON, application/dns+json.

Notez qu'il ne s'agit pas de la première description du DNS en

JSON. Par exemple, j'avais décrit un format pour cela dans le

brouillon draft-bortzmeyer-dns-json. Ce format

est mis en œuvre dans le DNS Looking

Glass. Mon format était plus joli, car utilisant

toujours des noms plus parlants ("Type": "AAAA"

au lieu du "QTYPE": 28). Notez toutefois que

le RFC 8427 le permet également ("QTYPEname":

"AAAA"). Le format plus joli ne peut de toute façon pas

être utilisé systématiquement car il ne permet pas de représenter

les types inconnus. Et mon format ne permet pas non plus de

représenter les messages malformés. (Par exemple, le

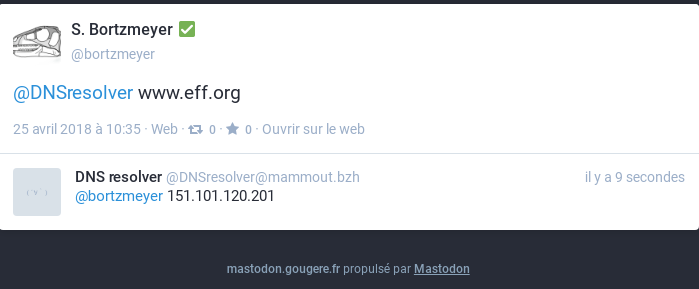

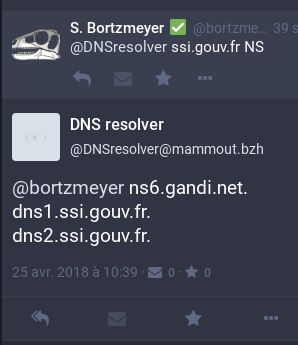

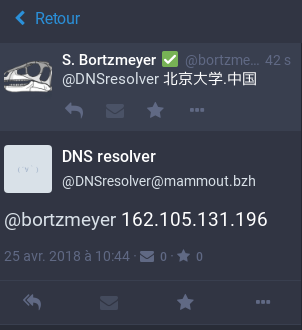

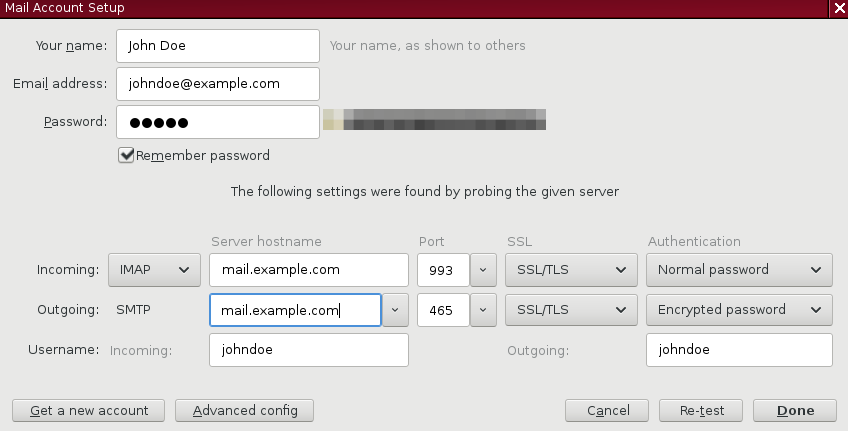

ANCOUNT est toujours implicite.)