Ce blog n'a d'autre prétention que de me permettre de mettre à la disposition de tous des petits textes que j'écris. On y parle surtout d'informatique mais d'autres sujets apparaissent parfois.

Migration de tous mes dépôts de développement vers un Gitlab

Première rédaction de cet article le 29 décembre 2019

Je viens de terminer la migration de tous mes dépôts de développement logiciel actifs (et quelques inactifs) vers un GitLab, suite au rachat de GitHub par Microsoft, en 2018.

Quand j'avais commencé à mettre des dépôts sur une forge publique, c'était sur SourceForge, en 2000. Après que SourceForge ait sombré, techniquement et politiquement, je suis passé à GitHub, à l'époque une petite entreprise sympa et techniquement pointue. Puis GitHub a grandi, devenant le « Facebook des geeks ». Et, en juin 2018, Microsoft annonce le rachat de GitHub, le sort fréquent des petites entreprises cools. Il n'était évidemment pas question pour moi de rester chez Microsoft, l'entreprise symbole du logiciel privateur. Même si de nombreux Microsoft fanboys s'étaient à l'époque succédé sur les réseaux sociaux pour répéter les éléments de langage « Microsoft a changé », « Maintenant, c'est une entreprise sympa », « Il y a eu quelques erreurs mais maintenant, Microsoft ne traite plus le logiciel libre de cancer communiste », je n'ai jamais avalé ces arguments. D'ailleurs, Microsoft lui-même ne s'est jamais réclamé du logiciel libre, juste d'un vague « open source », qui veut tout et rien dire, et qu'on utilise quand le mot « liberté » fait peur.

Bon, c'est bien joli, cela, mais cela fait bien plus d'un an que le rachat a eu lieu, c'était pas rapide comme fuite hors de l'étreinte de Microsoft ? C'est vrai, il m'a fallu du temps, la paresse a longtemps été la plus forte, mais j'ai fini par le faire.

Et la destination ? La solution techniquement la plus proche de

GitHub est un GitLab. Attention, beaucoup de

gens confondent un

GitLab (une instance spécifique d'un service

utilisant le logiciel) et le GitLab.com géré par la

société du même nom. Migrer vers GitLab.com

n'aurait qu'un intérêt limité : ce serait abandonner une entreprise

pour une autre, qui connaitra peut-être le même sort si elle a du

succès. Au contraire, le logiciel GitLab est

libre et peut donc

être installé par de nombreux acteurs. Je ne sais pas s'il existe

quelque part une liste d'instances GitLab ouvertes, mais je connais

Framasoft et j'ai donc choisi la leur, FramaGit. Je

sais que Framasoft est lancé dans une entreprise de « déframasofisation »

et qu'il faudra peut-être une autre migration dans un an ou deux

mais le sort de FramaGit ne semble pas clairement fixé. Si vous

connnaissez un GitLab (ou équivalent) chez un CHATON sympa…

Passons maintenant à la pratique. Il faut récupérer les données. L'utilisation d'un VCS décentralisé comme git résout automatiquement une grande partie du problème. Chaque copie locale contient non seulement tout le code mais également tout l'historique. Il ne reste plus qu'à récupérer les tickets et les pull requests. Personne ne migrerait depuis GitHub si cela signifiait de perdre ces importantes informations. Pour tout récupérer, GitLab a fait une excellente documentation. J'en résume les principaux points :

- La mise en correspondance des auteurs des commits entre GitHub et la nouvelle forge se fait sur la base d'une connexion utilisant GitHub ou bien sur celle de l'adresse de courrier. Sans correspondance, commits et tickets seront attribués à la personne faisant l'importation.

- L'administrateur de la forge GitLab utilisée doit avoir activé l'intégration GitHub. (C'est le cas de FramaGit.)

- Ensuite, il n'y a plus qu'à faire (vous noterez que la traduction en français de GitLab est incomplète) Nouveau projet → Import project → [depuis] Github → [Accepter l'autorisation OAuth] Authenticate with GitHub → [Sélectionner le projet à importer]. Le plus long est évidemment de tout vérifier, mettre à jour ses dépôts locaux, documenter sur l'ancien dépôt (je n'ai pas détruit les anciens dépôts, juste mis à jour la documentation) et sur le nouveau.

Comme mon adresse de courrier n'était pas la même sur GitHub et

sur FramaGit, je ne pouvais pas compter sur une bonne

correspondance. Je me suis donc une fois connecté à FramaGit en

utilisant mon compte GitHub, créant ainsi un compte « fantôme » qui

allait recevoir les anciens commits. (J'aurais pu

m'en passer, ce qui aurait réaffecté ces commits au compte FramaGit

habituel.) Ensuite, tout s'est bien passé,

commits, pull requests et

tickets sont bien importés. (Attention à ne pas trop en mettre,

FramaGit semble avoir une limite à 50 projets.)

Notez que, politiquement, c'est évidemment une excellente idée que de migrer depuis un service centralisé comme GitHub vers plein de petits GitLab partout. Mais, techniquement, cela peut rendre la coopération difficile, puisqu'il faut un compte sur chaque instance pour participer. C'est d'autant plus absurde que git est lui-même décentralisé (et a des mécanismes pour contribuer sans compte.) Il faudrait donc qu'on puisse avoir un dépôt complètement décentralisé, par exemple en mettant les tickets dans git lui-même. (On me dit que ce serait possible avec le logiciel SourceHut, qui a déjà un service d'hébergement, mais je n'ai pas testé. Ou bien avec Fossil ou encore git-bug. Et il y a une liste de projets similaires.) Une autre approche (qui ne me convainc pas, mais qui peut être utile pour certains services) serait de fédérer les GitLab, par exemple avec ActivityPub. Voir par exemple le ticket #4013 de GitLab.

L'article seul

Analyse technique du résolveur DNS public chinois 114dns

Première rédaction de cet article le 29 décembre 2019

Dernière mise à jour le 6 janvier 2020

Aujourd'hui, nous allons regarder de près un résolveur

DNS public, le

114.114.114.114, qui présente la particularité

d'être géré en Chine. Il y a de nombreuses

choses étranges sur ce service, qui distrairont les techniciens

Internet.

Des résolveurs DNS publics, il y en a plein : Google Public DNS, Quad9, et plusieurs autres. Je ne discuterai pas ici des inconvénients qu'ils présentent, je veux juste faire quelques expériences avec un de ces résolveurs, et montrer par la même occasion quelques outils utiles pour explorer les entrailles de l'infrastructure de l'Internet.

Donc, depuis pas mal d'années, il existe un résolveur public

chinois. Il a l'adresse

IPv4 114.114.114.114 et

il a un site Web

(uniquement en chinois, il semble). Je l'ai

dit, il n'est pas nouveau, mais il a fait l'objet d'un renouveau

d'intérêt fin 2019 car il serait le résolveur DNS par défaut dans

certains objets connectés fabriqués en Chine. Testons d'abord s'il

existe et répond. Nous allons utiliser divers outils en

ligne de commande qu'on trouve sur

Unix. Commençons par le client DNS

dig :

% dig +dnssec @114.114.114.114 cyberstructure.fr AAAA

; <<>> DiG 9.11.5-P4-5.1-Debian <<>> @114.114.114.114 cyberstructure.fr AAAA

; (1 server found)

;; global options: +cmd

;; Got answer:

;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 33037

;; flags: qr rd ra; QUERY: 1, ANSWER: 1, AUTHORITY: 0, ADDITIONAL: 0

;; QUESTION SECTION:

;cyberstructure.fr. IN AAAA

;; ANSWER SECTION:

cyberstructure.fr. 86399 IN AAAA 2001:4b98:dc0:41:216:3eff:fe27:3d3f

;; Query time: 3113 msec

;; SERVER: 114.114.114.114#53(114.114.114.114)

;; WHEN: Sun Dec 29 16:31:54 CET 2019

;; MSG SIZE rcvd: 63

On note d'abord qu'il est lent (depuis la France) et qu'on a souvent des délais de garde dépassés. Mais il marche. Notez que l'utilisation de ping montre que c'est bien le résolveur qui est lent, pas le réseau : les paquets envoyés par ping ont une réponse bien plus rapide :

% ping -c 10 114.114.114.114 ... 10 packets transmitted, 10 received, 0% packet loss, time 24ms rtt min/avg/max/mdev = 95.508/96.107/98.871/1.031 ms

Le RTT est bien inférieur à ce qu'on obtient quand on va en Chine, indiquant que ce résolveur a des instances en d'autres endroits, probablemement grâce à l'anycast. C'est confirmé par un ping depuis une machine aux États-Unis, qui montre des RTT qui sont encore moins compatibles avec la durée d'un aller-retour en Chine :

% ping -c 10 114.114.114.114 ... --- 114.114.114.114 ping statistics --- 10 packets transmitted, 10 received, +1 duplicates, 0% packet loss, time 20ms rtt min/avg/max/mdev = 19.926/20.054/20.594/0.226 ms

Qui gère ce résolveur ? whois nous dit que c'est bien en Chine :

% whois 114.114.114.114 % [whois.apnic.net] ... inetnum: 114.114.0.0 - 114.114.255.255 netname: XFInfo descr: NanJing XinFeng Information Technologies, Inc. descr: Room 207, Building 53, XiongMao Group, No.168 LongPanZhong Road descr: Xuanwu District, Nanjing, Jiangsu, China country: CN ... source: APNIC

Ce service n'est apparemment pas un résolveur menteur. Les noms

censurés en Chine, comme facebook.com

fonctionnent. Si on le souhaite, la documentation semble indiquer

(je n'ai pas testé) que d'autres adresses abritent des résolveurs

menteurs, par exemple 114.114.114.119 filtre

le logiciel malveillant et

114.114.114.110 filtre le porno.

Quelles sont les caractéristiques techniques du service ? D'abord, notons

qu'il ne valide pas avec

DNSSEC, ce qui est dommage. On le voit car

il n'y a pas le flag AD (Authentic

Data) dans la réponse au dig plus

haut (alors que le domaine visé est signé avec DNSSEC). Une autre

façon de voir qu'il n'a pas DNSSEC est de demander des noms

délibérement invalides comme

servfail.nl. 114.114.114.114

donne une réponse alors qu'il ne devrait pas.

Pendant qu'on est sur DNSSEC, notons une bizarrerie du résolveur : il renvoie parfois une section EDNS (RFC 6891) et parfois pas. Dans l'exemple dig ci-dessus, il n'y en avait pas, mais parfois si :

% dig +dnssec @114.114.114.114 afnic.fr

; <<>> DiG 9.11.5-P4-5.1-Debian <<>> +dnssec @114.114.114.114 afnic.fr

; (1 server found)

;; global options: +cmd

;; Got answer:

;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 59581

;; flags: qr rd ra; QUERY: 1, ANSWER: 1, AUTHORITY: 0, ADDITIONAL: 1

;; OPT PSEUDOSECTION:

; EDNS: version: 0, flags: do; udp: 4096

; COOKIE: c46f830f4a12bfab (echoed)

;; QUESTION SECTION:

;afnic.fr. IN A

;; ANSWER SECTION:

afnic.fr. 579 IN A 192.134.5.25

;; Query time: 20 msec

;; SERVER: 114.114.114.114#53(114.114.114.114)

;; WHEN: Sun Dec 29 17:00:19 CET 2019

;; MSG SIZE rcvd: 65

Ce comportement est tout à fait anormal, et il se peut qu'il y ait plusieurs machines derrière un répartiteur de charge, avec des configurations différentes.

Autre chose qui manque : il n'a pas de NSID (Name Server IDentifier, RFC 5001), cette indication du nom du serveur, très pratique lorsqu'on analyse un service anycasté, c'est-à-dire composé de plusieurs instances. (NSID peut également indiquer si une machine qui répond est la vraie, au cas, fréquent, où un détourneur n'ait pas eu l'idée de faire un faux NSID.)

% dig +dnssec +nsid @114.114.114.114 framagit.org ; <<>> DiG 9.11.5-P4-5.1-Debian <<>> +dnssec +nsid @114.114.114.114 framagit.org ; (1 server found) ;; global options: +cmd ;; Got answer: ;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 745 ;; flags: qr rd ra; QUERY: 1, ANSWER: 1, AUTHORITY: 0, ADDITIONAL: 1 ;; OPT PSEUDOSECTION: ; EDNS: version: 0, flags: do; udp: 4096 ; NSID ; COOKIE: 7f99ae3cb5e63ad1 (echoed) ;; QUESTION SECTION: ;framagit.org. IN A ;; ANSWER SECTION: framagit.org. 10779 IN A 144.76.206.42 ;; Query time: 20 msec ;; SERVER: 114.114.114.114#53(114.114.114.114) ;; WHEN: Sun Dec 29 17:05:40 CET 2019 ;; MSG SIZE rcvd: 73

Le NSID est vide, ce qui est bizarre. Normalement, quand un serveur DNS ne veut pas répondre à la question NSID, il ne renvoie pas l'option EDNS dans la OPT pseudo-section. Ici, ce zèbre étrange renvoie l'option, mais vide.

Le service n'a apparemment pas d'adresse IPv6, ce qui est étonnant en 2019. En tout cas, il n'y a pas d'enregistrement de type AAAA pour le nom :

% dig +dnssec public1.114dns.com. AAAA ; <<>> DiG 9.11.5-P4-5.1-Debian <<>> public1.114dns.com. AAAA ;; global options: +cmd ;; Got answer: ;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 4421 ;; flags: qr rd ra; QUERY: 1, ANSWER: 0, AUTHORITY: 1, ADDITIONAL: 1 ;; OPT PSEUDOSECTION: ; EDNS: version: 0, flags: do; udp: 4096 ; COOKIE: 0d4b4b8dd9fc8613c831aa085e08cf5e9b2e8073e1d6741d (good) ;; QUESTION SECTION: ;public1.114dns.com. IN AAAA ;; AUTHORITY SECTION: 114dns.com. 600 IN SOA ns1000.114dns.com. dnsadmin.114dns.com. ( 20120510 ; serial 3600 ; refresh (1 hour) 300 ; retry (5 minutes) 604800 ; expire (1 week) 300 ; minimum (5 minutes) ) ;; Query time: 114 msec ;; SERVER: 127.0.0.1#53(127.0.0.1) ;; WHEN: Sun Dec 29 17:07:58 CET 2019 ;; MSG SIZE rcvd: 127

(Au fait, j'ai trouvé ce nom

public1.114dns.com en faisant une résolution

« inverse », avec dig -x 114.114.114.114.)

Enfin, ce résolveur n'a que le DNS traditionnel, sur UDP. Pas de TCP, pourtant normalisé dès les débuts du DNS, au même titre que UDP, et surtout pas de chiffrement pour sécuriser la communication, ce résolveur n'a pas DoT (DNS sur TLS, RFC 7858) ou DoH (DNS sur HTTPS, RFC 8484). On peut tester ces deux protocoles avec Homer :

% homer https://114.114.114.114/ cyberstructure.fr ... pycurl.error: (7, 'Failed to connect to 114.114.114.114 port 443: Connection timed out') % homer --dot 114.114.114.114 cyberstructure.fr timeout

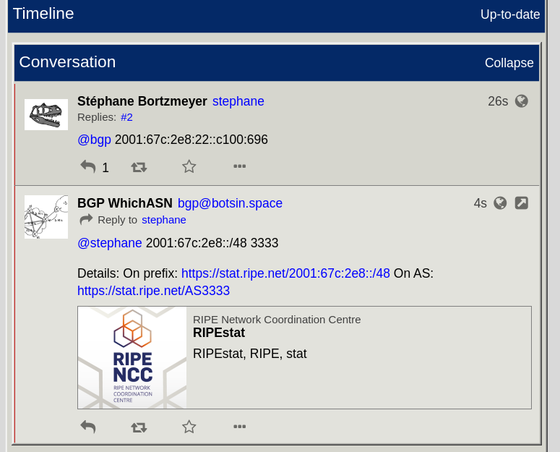

Tester depuis un seul point de mesure, ou même deux, est évidemment insuffisant pour un résolveur anycasté, donc nous allons utiliser les sondes RIPE Atlas via l'outil Blaeu. Ici, on demande à mille sondes RIPE Atlas, réparties sur toute la planète, d'interroger le résolveur public :

% blaeu-resolve -r 1000 --nameserver 114.114.114.114 --displayrtt --dnssec --nsid --displayvalidation write.as Nameserver 114.114.114.114 [2001:4800:7812:514:500b:b07c:ff05:694d NSID: b''] : 909 occurrences Average RTT 129 ms [2001:4800:7812:514:500b:b07c:ff05:694d] : 31 occurrences Average RTT 430 ms [TIMEOUT] : 42 occurrences Average RTT 0 ms Test #23727649 done at 2019-12-29T15:54:15Z

On voit le nombre relativement élevé de timeout

(comme je l'ai noté plus haut, ce service est lent), et le fait que

parfois, on n'a pas de réponse EDNS (et donc pas de NSID, même

vide). Plus drôle, en répétant le test, les sondes Atlas trouvent

plusieurs détournements de ce résolveur public. Une des grosses

faiblesses d'un résolveur public sans authentification (ce qui est le

cas de tous ceux qui n'offrent ni DoT, ni

DoH) est qu'on ne peut

pas les authentifier. Il est donc trivial de faire un faux serveur,

en jouant avec le routage, comme le font souvent les censeurs. J'ai

ainsi vu une sonde Atlas détecter un NSID « CleanBrowsing v1.6a -

dns-edge-usa-east-dc-c », manifestement un outil de filtrage qui se

faisait passer pour 114.114.114.114 et qui

l'assumait, en affichant un NSID à lui.

Puisqu'on a parlé de routage, c'est l'occasion de tester traceroute. Un traceroute ordinaire ne donne rien, ses paquets étant manifestement jetés dans le réseau du résolveur. On va donc utiliser traceroute avec TCP vers le port 53, celui du DNS, depuis la machine états-unienne de tout à l'heure :

% tcptraceroute 114.114.114.114 53 traceroute to 114.114.114.114 (114.114.114.114), 30 hops max, 60 byte packets 1 88.214.240.4 (88.214.240.4) 2.518 ms 2.613 ms 2.699 ms 2 be5893.rcr51.ewr04.atlas.cogentco.com (38.122.116.9) 0.485 ms 1.009 ms 1.014 ms 3 be3657.rcr21.ewr03.atlas.cogentco.com (154.24.33.169) 1.021 ms 0.986 ms 1.091 ms 4 be2495.rcr24.jfk01.atlas.cogentco.com (154.54.80.193) 1.350 ms be2390.rcr23.jfk01.atlas.cogentco.com (154.54.80.189) 2.468 ms 1.268 ms 5 be2897.ccr42.jfk02.atlas.cogentco.com (154.54.84.213) 1.631 ms 1.669 ms be2896.ccr41.jfk02.atlas.cogentco.com (154.54.84.201) 1.749 ms 6 be2890.ccr22.cle04.atlas.cogentco.com (154.54.82.245) 13.427 ms 13.581 ms be2889.ccr21.cle04.atlas.cogentco.com (154.54.47.49) 13.587 ms 7 be2718.ccr42.ord01.atlas.cogentco.com (154.54.7.129) 20.108 ms 21.048 ms 20.062 ms 8 be3802.rcr21.ord07.atlas.cogentco.com (154.54.47.38) 20.992 ms 154.54.89.2 (154.54.89.2) 20.794 ms be3802.rcr21.ord07.atlas.cogentco.com (154.54.47.38) 20.925 ms 9 * * * 10 23.237.126.230 (23.237.126.230) 22.188 ms 22.502 ms 22.331 ms 11 23.237.136.242 (23.237.136.242) 24.471 ms 23.732 ms 24.089 ms 12 * * * 13 public1.114dns.com (114.114.114.114) <syn,ack> 19.963 ms 20.631 ms 20.658 ms

On y voit que la machine répond bien en TCP (bien qu'elle refuse d'assurer un service DNS en TCP, encore une bizarrerie). On note aussi que le RTT confirme celui de ping. (Ce qui ne va pas de soi : le réseau peut traiter différemment différents protocoles.)

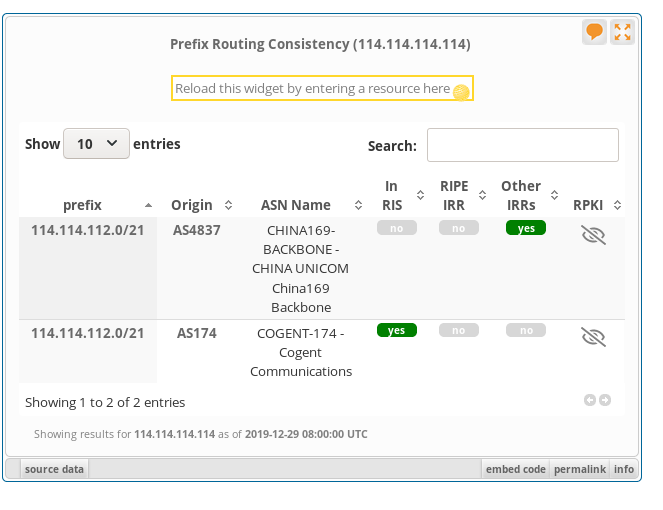

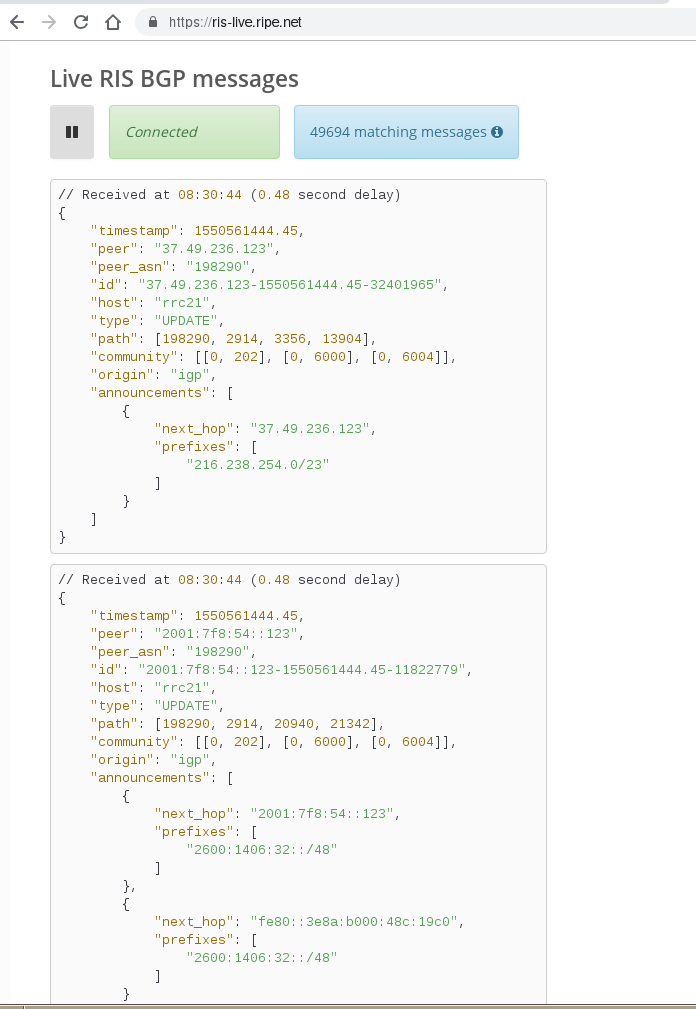

Il y a une dernière chose très étrange avec ce service. Son

adresse fait partie d'un préfixe IP annoncé en BGP,

114.114.112.0/21. Vous pouvez le trouver auprès

d'un service comme RIPE

Stat, ou bien en utilisant curl pour interroger une API publique :

% curl https://bgp.bortzmeyer.org/114.114.114.114 114.114.112.0/21 174

Après le préfixe (114.114.112.0/21), on voit

le numéro d'AS, 174. Or, cet AS est

l'opérateur étatsunien Cogent :

% whois AS174 ... # Copyright 1997-2019, American Registry for Internet Numbers, Ltd. ASNumber: 174 ASName: COGENT-174 ASHandle: AS174 Ref: https://rdap.arin.net/registry/autnum/174 OrgName: Cogent Communications OrgId: COGC Address: 2450 N Street NW City: Washington StateProv: DC PostalCode: 20037 Country: US Ref: https://rdap.arin.net/registry/entity/COGC

A priori, pourquoi pas, une organisation chinoise a bien le droit de faire appel à un opérateur étatsunien pour annoncer son préfixe. Mais il y a des choses étranges. D'abord, la route enregistrée dans l'IRR d'APNIC ne mentionne pas Cogent, mais l'AS 4837, China Unicom :

% whois 114.114.114.114 ... route: 114.114.112.0/21 descr: China Unicom Shandong Province network descr: Addresses from CNNIC country: CN origin: AS4837 mnt-by: MAINT-CNCGROUP-RR last-modified: 2011-04-12T07:52:02Z source: APNIC

Il n'y a pas de ROA (Route Origin Authorizations, RFC 6482) pour ce préfixe :

% whois -h whois.bgpmon.net 114.114.114.114 % This is the BGPmon.net whois Service ... RPKI status: No ROA found ...

(On pourrait avoir le même résultat en consultant

RIPE stat.) La seule information quant à la validité de

l'annonce BGP est donc l'objet route, qui

exclut Cogent. Notez qu'en fouillant un peu plus, on trouve des

annonces du préfixe 114.114.112.0/21 par

d'autres AS, 4837 (ce qui est conforme à l'objet

route ci-dessous), et 4134

(ChinaNet). Mais la plupart des routeurs BGP de la planète ne voient que l'annonce de

Cogent.

Que faut-il déduire de ce dernier cafouillage ? La situation est certes anormale (l'IRR n'annonce qu'un seul AS d'origine possible, mais c'est un autre qu'on voit presque partout), mais est-ce le résultat d'une attaque délibérée, comme les détournements BGP dont on parle souvent (RFC 7464), en général en les attribuant aux… Chinois ? Probablement pas : la situation générale de la sécurité du routage est médiocre, les IRR ne sont pas maintenus à jour, l'opérateur Cogent n'est pas connu pour sa rigueur (il ne devrait pas annoncer des préfixes sans qu'ils soient marqués comme tel dans un IRR) et il s'agit sans doute plus de négligence que de malveillance.

Et pour finir la partie sur le routage, une copie d'écran de RIPE stat montrant

l'incohérence des annonces :

Revenons un peu à ping. Manuel Ponce a fort justement observé qu'il y avait un problème intéressant dans les réponses à ping :

% ping -c 10 114.114.114.114 PING 114.114.114.114 (114.114.114.114) 56(84) bytes of data. 64 bytes from 114.114.114.114: icmp_seq=1 ttl=63 time=94.0 ms 64 bytes from 114.114.114.114: icmp_seq=2 ttl=56 time=93.8 ms 64 bytes from 114.114.114.114: icmp_seq=3 ttl=81 time=93.9 ms 64 bytes from 114.114.114.114: icmp_seq=4 ttl=84 time=94.1 ms 64 bytes from 114.114.114.114: icmp_seq=5 ttl=62 time=94.2 ms 64 bytes from 114.114.114.114: icmp_seq=6 ttl=66 time=94.0 ms 64 bytes from 114.114.114.114: icmp_seq=7 ttl=80 time=93.9 ms 64 bytes from 114.114.114.114: icmp_seq=8 ttl=69 time=93.9 ms 64 bytes from 114.114.114.114: icmp_seq=9 ttl=72 time=94.2 ms 64 bytes from 114.114.114.114: icmp_seq=10 ttl=59 time=94.1 ms --- 114.114.114.114 ping statistics --- 10 packets transmitted, 10 received, 0% packet loss, time 9011ms rtt min/avg/max/mdev = 93.801/94.045/94.285/0.342 ms

Prenez cinq minutes pour regarder et voyez si vous trouvez le problème…

C'est bon, vous avez trouvé ? Moi, je n'avais pas vu : le TTL change à chaque paquet. Normalement, il devrait être à peu près constant, sauf si le routage se modifie subitement pendant le test (ce qui est rare). Ici, c'est un mystère de plus de ce curieux service. Personne n'a trouvé d'explication certaine de ce phénomène mais Baptiste Jonglez suggère cette commande Netfilter si vous voulez faire pareil sur vos serveurs (Non testé ! Ne l'essayez pas en production comme ça !) :

for ttl in {0..31}

do

iptables -t mangle -A OUTPUT -p icmp --icmp-type echo-reply -m statistic --mode nth --every 32 --packet $ttl -j TTL --ttl-set $((ttl+72))

done

Cela donne des TTL dans l'ordre. Pour les avoir aléatoires, Paul

Rolland suggère de remplacer --mode nth --every 32

--packet $ttl par --mode random --probability 0.03125.

L'article seul

RFC 8700: Fifty Years of RFCs

Date de publication du RFC : Décembre 2019

Auteur(s) du RFC : H. Flanagan (RFC Editor)

Pour information

Première rédaction de cet article le 24 décembre 2019

Ce nouveau RFC marque le cinquantième anniversaire des RFC. Le RFC 1 avait en effet été publié le 7 avril 1969. Ce RFC 8700, publié avec un certain retard, revient sur l'histoire de cette exceptionnelle série de documents.

Il y avait déjà eu des RFC faisant le bilan de la série, à l'occasion d'anniversaires, comme le RFC 2555 pour le trentième RFC, et le RFC 5540 pour le quarantième. La série a évidemment commencé avec le RFC 1, cinquante ans auparavant, et donc dans un monde très différent. À l'époque, les RFC méritaient leur nom, ils étaient été en effet des « appels à commentaires », prévus non pas comme des références stables, mais comme des étapes dans la discussion. En cinquante ans, les choses ont évidemment bien changé, et les RFC sont devenus des documents stables, intangibles, et archivés soigneusement. Logiquement, le processus de création des RFC a également évolué, notamment vers un plus grand formalisme (on peut même dire « bureaucratie »).

Plus de 8 500 RFC ont été publiés (il existe quelques trous dans la numérotation ; ainsi, le RFC 26 n'a jamais existé…) Les plus connus sont les normes techniques de l'Internet. La description précise de HTTP, BGP ou IP est dans un RFC. Mais d'autres RFC ne normalisent rien (c'est le cas du RFC 8700, sujet de cet article), ils documentent, expliquent, suggèrent… Tous les RFC ont en commun d'être publiés puis soigneusement gardés par le RFC Editor, une fonction assurée par plusieurs personnes, et aujourd'hui animée par Heather Flanagan, auteure de ce RFC 8700, mais qui a annoncé son départ.

Cette fonction a elle aussi une histoire : le premier RFC Editor était Jon Postel. À l'époque c'était une fonction informelle, tellement informelle que plus personne ne sait à partir de quand on a commencé à parler du (ou de la) RFC Editor (mais la première mention explicite est dans le RFC 902). Postel assurait cette fonction en plus de ses nombreuses autres tâches, sans que cela n'apparaisse sur aucune fiche de poste. Petit à petit, cette fonction s'est formalisée.

Les changements ont affecté bien des aspects de la série des RFC, pendant ces cinquante ans. Les premiers RFC étaient distribués par la poste ! Au fur et à mesure que le réseau (qui ne s'appelait pas encore Internet) se développait, ce mécanisme de distribution a été remplacé par le courrier électronique et le FTP anonyme. Autre changement, les instructions aux auteurs, données de manière purement orales, ont fini par être rédigées. Et l'équipe s'est étoffée : d'une personne au début, Postel seul, le RFC Editor a fini par être une tâche assurée par cinq à sept personnes. Autrefois, la fonction de RFC Editor était liée à celle de registre des noms et numéros, puis elle a été séparée (le registre étant désormais PTI). Puis la fonction de RFC Editor a été structurée, dans le RFC 4844, puis RFC 5620, enfin dans le RFC 6635. Et l'évolution continue, par exemple en ce moment avec le changement vers le nouveau format des documents (voir RFC 7990). Dans le futur, il y aura certainement d'autres changements, mais le RFC Editor affirme son engagement à toujours prioriser la stabilité de la formidable archive que représentent les RFC, et sa disponibilité sur le long terme (RFC 8153).

La section 2 du RFC rappelle les grands moments de l'histoire des RFC (je n'ai pas conservé toutes ces étapes dans la liste) :

- Avril 1969, premier RFC, le RFC 1,

- 1971, premier RFC distribué via le réseau, le RFC 114,

- 1977, premier RFC publié le premier avril, le RFC 748,

- 1986, création de l'IETF,

- 1998, début du projet de récupération et de restauration des vieux RFC perdus,

- 1998, mort de Jon Postel, le « père de la série des RFC » (cf. RFC 2441),

- 2009, publication du RFC 5620, qui décrit à peu près le modèle d'aujourd'hui,

- 2010, les RFC ne sont plus gérés à l'ISI, mais chez une organisation spécialisée,

- 2011, une des nombreuses réformes des RFC, l'abandon des trois niveaux de normalisation, documenté dans le RFC 6410,

- 2013, début du projet de changement du format (RFC 6949) et d'abandon du texte brut,

- 2017, passage au zéro papier (RFC 8153).

Dans la section 3 de ce RFC, plusieurs personnes ayant vécu de l'intérieur l'aventure des RFC écrivent. Steve Crocker, dans la section 3.1, rappelle les origines des RFC (qu'il avait déjà décrites dans le RFC 1000). Il insiste sur le fait que les débuts étaient… peu organisés, et que la création de la série des RFC n'était certainement pas prévue dés le départ. Elle doit beaucoup aux circonstances. Le réseau qui, après bien des évolutions, donnera naissance à l'Internet a été conçu vers 1968 et a commencé à fonctionner en 1969. Quatre machines, en tout et pour tout, le constituaient, un Sigma 7, un SDS 940, un IBM 360/75 et un PDP-10. Le point important est qu'il s'agissait de machines radicalement différentes, un des points distinctifs de l'Internet, qui a toujours dû gérer l'hétérogénéité. Un byte n'avait pas la même taille sur toutes ces machines. (Le terme français octet est apparu bien plus tard, lorsque la taille de huit bits était devenue standard.)

Crocker décrit la première réunion de ce qui allait devenir le Network Working Group puis, très longtemps après l'IETF. Rien n'était précisement défini à part « il faut qu'on fasse un réseau d'ordinateurs » et persone ne savait trop comment le faire. La principale conclusion de la réunion avait été « il faudrait faire une autre réunion ». Dès le début, le réseau qui allait permettre de travailler à distance était donc un prétexte à des réunions AFK. (L'ironie continue aujourd'hui, où l'IETF réfléchit à avoir des réunions entièrement en ligne.)

L'espoir des étudiants comme Crocker était qu'un monsieur sérieux et expérimenté vienne expliquer ce qu'on allait devoir faire. Mais cet espoir ne s'est pas matérialisé et le futur Network Working Group a donc dû se débrouiller.

Parmi les idées les plus amusantes, le groupe avait réfléchi à la création d'un langage portable permettant d'envoyer du code sur une autre machine qui l'exécuterait. Ce lointain prédécesseur de JavaScript se nommait DEL (pour Decode-Encode Language) puis NIL (Network Interchange Language). Mais en attendant le travail matériel avançait, la société BBN ayant obtenu le contrat de construction des IMP (à peu près ce qu'on appelerait plus tard routeurs). La répartition des tâches entre le NWG et BBN n'était pas claire et le groupe a commencé de son côté à documenter ses réflexions, créant ainsi les RFC. Le nom de ces documents avait fait l'objet de longs débats. Le Network Working Group n'avait aucune autorité officielle, aucun droit, semblait-il, à édicter des « normes » ou des « références ». D'où ce titre modeste de Request for Comments ou « Appel à commentaires ». Cette modestie a beaucoup aidé au développement du futur Internet : personne ne se sentait intimidé par l'idée d'écrire des documents finaux puisque, après tout, ce n'était que des appels à commentaires. C'était d'autant plus important que certains des organismes de rattachement des participants avaient des règles bureaucratiques strictes sur les publications. Décréter les RFC comme de simples appels à commentaires permettait de contourner ces règles.

Le premier « méta-RFC » (RFC parlant des RFC) fut le RFC 3, qui formalisait cette absence de formalisme. De la même façon, il n'existait pas encore vraiment de RFC Editor, même si Crocker attribuait les numéros, et que le SRI gardait une archive non officielle. Mais deux principes cardinaux dominaient, et sont toujours vrais aujourd'hui : tout le monde peut écrire un RFC, nul besoin de travailler pour une grosse entreprise, ou d'avoir un diplôme ou un titre particulier, et tout le monde peut lire les RFC (ce qui n'a rien d'évident : en 2019, l'AFNOR ne distribue toujours pas librement ses normes.)

Dans la section 3.2, Vint Cerf décrit les changements ultérieurs. En 1971, Jon Postel est devenu RFC Editor (titre complètement informel à cette époque). Cette tâche était à l'époque mélée à celle d'attribution des numéros pour les protocoles, désormais séparée. Postel s'occupait à la fois du côté administratif du travail (donner un numéro aux RFC…) et de l'aspect technique (relecture et révision), tâche aujourd'hui répartie entre diverses organisations comme l'IESG pour les RFC qui sont des normes. C'est pendant cette « période Postel » que d'autres personnes sont venues rejoindre le RFC Editor comme Joyce Reynolds ou Bob Braden. Jon Postel est décédé en 1998 (cf. RFC 2468).

Leslie Daigle, dans la section 3.3 de notre RFC, rappelle la longue marche qu'a été la formalisation du rôle de RFC Editor, le passage de « bon, qui s'en occupe ? » à un travail spécifié par écrit, avec plein de règles et de processus. (Daigle était présidente de l'IAB au moment de la transition.) Le travail était devenu trop important en quantité, et trop critique, pour pouvoir être assuré par deux ou trois volontaires opérant « en douce » par rapport à leurs institutions. Une des questions importantes était évidemment la relation avec l'IETF. Aujourd'hui, beaucoup de gens croient que « les RFC, c'est l'IETF », mais c'est faux. Les RFC existaient bien avant l'IETF, et, aujourd'hui, tous les RFC ne sont pas issus de l'IETF.

Parmi les propositions qui circulaient à l'époque (début des années 2000) était celle d'une publication complètement automatique. Une fois le RFC approuvé par l'IESG, quelqu'un aurait cliqué sur Publish, et le RFC se serait retrouvé en ligne, avec un numéro attribué automatiquement. Cela aurait certainement fait des économies, mais cela ne réglait pas le cas des RFC non-IETF, et surtout cela niait le rôle actif du RFC Editor en matière de contenu du RFC. (Témoignage personnel : le RFC Editor a joué un rôle important et utile dans l'amélioration de mes RFC. C'est vrai même pour les RFC écrits par des anglophones : tous les ingénieurs ne sont pas des bons rédacteurs.) D'un autre côté, cela résolvait le problème des modifications faites de bonne foi par le RFC Editor mais qui changeaient le sens technique du texte.

La solution adoptée est décrite dans le RFC 4844, le premier à formaliser en détail le rôle du RFC Editor, et ses relations complexes avec les autres acteurs.

Nevil Brownlee, lui, était ISE, c'est-à-dire Independent Submissions Editor, la personne chargée de traiter les RFC de la voie indépendante (ceux qui ne viennent ni de l'IETF, ni de l'IAB, ni de l'IRTF.) Dans la section 3.4, il revient sur cette voie indépendante (d'abord décrite dans le RFC 4846). En huit ans, il a été responsable de la publication de 159 RFC… Avant, c'était le RFC Editor qui décidait quoi faire des soumissions indépendantes. Comme le rappelle Brownlee, le logiciel de gestion de cette voie indépendante était un simple fichier texte, tenu par Bob Braden.

Le principal travail de l'ISE est de coordonner les différents acteurs qui jouent un rôle dans ces RFC « indépendants ». Il faut trouver des relecteurs, voir avec l'IANA pour l'allocation éventuelle de numéros de protocoles, avec l'IESG pour s'assurer que ce futur RFC ne rentre pas en conflit avec un travail de l'IETF (cf. RFC 5742), etc. Ah, et c'est aussi l'ISE qui gère les RFC du premier avril.

Puis c'est la RFC Editor actuelle, Heather Flanagan qui, dans la section 3.5, parle de son expérience, d'abord comme simple employée. La charge de travail atteignait de tels pics à certains moments qu'il a fallu recruter des personnes temporaires (au nom de l'idée que la publication des RFC devait être un processus léger, ne nécessitant pas de ressources permanentes), ce qui a entrainé plusieurs accidents quand des textes ont été modifiés par des employés qui ne comprenaient pas le texte et introduisaient des erreurs. L'embauche d'employés permanents a résolu le problème.

Mais il a fallu aussi professionnaliser l'informatique. Le RFC Editor qui travaillait surtout avec du papier (et un classeur, le fameux « classeur noir ») et quelques outils bricolés (la file d'attente des RFC était un fichier HTML édité à la main), a fini par disposer de logiciels adaptés à la tâche. Finies, les machines de Rube Goldberg !

Dans le futur, bien sûr, les RFC vont continuer à changer ; le gros projet du moment est le changement de format canonique, du texte brut à XML. Si l'ancien format avait de gros avantages, notamment en terme de disponibilité sur le long terme (on peut toujours lire les anciens RFC, alors que les outils et formats à la mode au moment de leur écriture sont depuis longtemps oubliés), il avait aussi des inconvénients, comme l'impossibilité d'utiliser d'autres caractères que l'ASCII. Le RFC 7990 décrit le nouveau format, actuellement en cours de déploiement.

Autres lectures :

- Pour ce cinquantième anniversaire, Darius Kazemi commente un RFC par jour et c'est passionnant,

- Article de Dan York.

L'article seul

Fiche de lecture : The box

Auteur(s) du livre : Marc Levinson

Éditeur : Max Milo

9782315002986

Publié en 2011

Première rédaction de cet article le 16 décembre 2019

C'est une banalité que de choisir le conteneur comme symbole de la mondialisation. Mais comment en est-on arrivé là ? Qui a inventé le conteneur et pourquoi ? Comment s'est-il imposé ? Je trouve que Marc Levinson a fait un excellent travail d'histoire de la conteneurisation dans ce gros livre.

Donc, le conteneur, c'est la grosse boîte en acier qu'on voit déborder sur le pont des navires. Permettant d'abaisser le coût de transport international jusqu'au point qu'il devient souvent négligeable, le conteneur a permis aux baskets fabriquées au Viêt Nam, aux T-shirts du Bangladesh et aux téléphones montés en Chine d'arriver partout dans le monde. Plus besoin de mettre les usines près des futurs clients, on peut les installer là où les travaileurs ne sont pas syndiqués et donc pas chers. Mais malgré son rôle économique crucial, le conteneur ne fait pas rêver. On écrit plein de livres sur les avions, sur les bateaux, sur de nombreuses machines, mais pas sur cette grosse boîte disgracieuse, peinte de couleurs vulgaires, qu'est le conteneur. C'est là que Marc Levinson est intervenu pour écrire ce livre touffu et très détaillé. (L'original est en anglais mais j'ai lu la traduction en français.)

Levinson retrace l'histoire du conteneur, en insistant sur le rôle de Malcom McLean, qui n'est pas « l'inventeur » du conteneur (comme beaucoup d'inventions, le conteneur a de nombreux pères), mais celui qui l'a promu et développé depuis le début. L'histoire de l'homme seul luttant contre les conservatismes pour révolutionner le transport de marchandises aurait pu être fait en style « légende étatsunienne » classique, avec le courageux entrepreneur qui, parti de rien, devient riche par son travail personnel, mais, heureusement, Levinson ne donne pas dans ce travers. Il explique bien le rôle de McLean, mais aussi ses erreurs et ses défauts, et le rôle de nombreuses autres personnes.

C'est que le conteneur a eu une histoire difficile. Il n'y a que dans les légendes que l'inventeur conçoit un objet et qu'après de courtes difficultés initiales, l'objet conquiert le monde par la seule force de ses qualités intrinsèques. En fait, le conteneur ne s'est pas imposé tout de suite. Il a rencontré de nombreuses difficultés, du conservatisme des acteurs déjà installés aux problèmes politiques et légaux, en passant par la difficulté d'adapter toute la chaîne du transport. Sans oublier des problèmes techniques bien concrets, pour faire une boîte solide, mais pas chère et facile à manipuler.

Levinson ne cache pas que l'effondrement des coûts du transport international n'est pas uniquement dû au conteneur, objet magique. Il a fallu refaire toute la logistique, et cela a pris de nombreuses années. En cela, ce livre est un excellent modèle d'analyse d'un système socio-technique. Contrairement à beaucoup d'études sur un objet technique, celle-ci ne considère pas le conteneur comme isolé, mais bien comme un des maillons d'un système complexe. Avec le recul, on dit que c'est le conteneur, par la baisse des coûts qu'il a engendrée, qui a permis l'actuelle mondialisation. Mais pendant de nombreuses années, il fallait vraiment avoir la foi, le conteneur coûtait aussi cher, voire plus cher que les systèmes qu'il voulait remplacer. Et il fallait remplir cette grosse boîte, pour qu'elle ne voyage pas à moitié vide et cela au retour comme à l'aller. C'est seulement quand tout le système socio-technique du transport s'est adapté à ces exigences que les coûts ont réellement baissé. En attendant, il a fallu financer l'adaptation des bateaux et des ports à ce nouvel objet et, contrairement à la légende des entrepreneurs privés qui risquent leur argent et, si ça marche, en retirent des bénéfices bien mérités, ici, une bonne partie des ports et même des navires ont été financés pendant des années par l'argent public, McLean ayant réussi à convaincre beaucoup de monde que l'avenir était au conteneur. C'est d'ailleurs la guerre du Viêt Nam qui a marqué le vrai décollage du conteneur, vu les énormes besoins en matériel de l'armée étatsunienne et l'argent dont elle disposait.

Comme tous les changements socio-techniques, le conteneur a fait des gagnants et des perdants. Levinson ne joue pas la partition de la « mondialisation heureuse » et analyse qui a gagné et qui a perdu. Parmi les perdants, les marins : la rapidité de chargement et de déchargement, un des buts de la conteneurisation, a réduit à quelques heures la durée des escales. On ne voit plus du pays quand on est marin, seulement les gigantesques terminaux à conteneurs, toujours situés, vu leur taille, très loin de la ville, contrairement au port traditionnel. Toujours parmi les perdants, les dockers, le but du conteneur étant entre autres de nécessiter moins de personnel pour charger et décharger les bateaux. Les pages consacrées aux questions sociales sont très intéressantes, mais le livre est évidemment très centré sur les États-Unis et ce pays présente quelques particularités, comme les liens de certains syndicats avec le crime organisé (même si l'auteur note que le film Sur les quais n'est pas toujours réaliste), ou comme la concurrence entre syndicats (celui des dockers et celui des camionnneurs qui s'allient chacun avec son patronat, contre l'autre syndicat…)

Mais les principaux perdants n'ont pas forcément été du côté des professionnels du transport maritime : ce sont tous les travailleurs qui se trouvent désormais en compétition avec des pays sans lois sociales, sans syndicats, sans droit du travail.

La normalisation est un sujet peu abordé dans les analyses des systèmes socio-techniques mais, ici, elle a la place qu'elle mérite. Le conteneur n'est en effet intéressant que si n'importe quel navire, train ou camion peut l'embarquer. Cela nécessite une normalisation de la taille, des caractéristiques physiques (résistance à l'écrasement) et du système de verrouillage des conteneurs. C'est un des meilleurs chapitres du livre, introduisant le lecteur à ce monde feutré des négociations autour de la normalisation, sachant que des détails apparemment sans importance, comme la largeur exacte du conteneur, peuvent faire perdre beaucoup d'argent aux premiers investisseurs, qui risquent de devoir refaire leurs ports et leurs navires, si la taille initialement retenue n'est pas celle choisie par ces premiers arrivés. Et les décisions de normalisation ne sont pas purement arbitraires, la technique a son mot à dire, par exemple sur le système de verrouillage (sinon, on perd des conteneurs en mer.)

Pour résumer, c'est un très bon exemple d'analyse socio-technique, à lire même si vous ne travaillez pas dans le domaine du transport de marchandises. On voudrait que tous les systèmes socio-techniques complexes fassent l'objet d'aussi bonnes synthèses.

Et de jolies photos de conteneurs, prises à l'exposition

Playmobil à Calais :

(Version en taille originale.)

(Version en taille originale.)

(Version en taille originale.)

(Version en taille originale.)

L'article seul

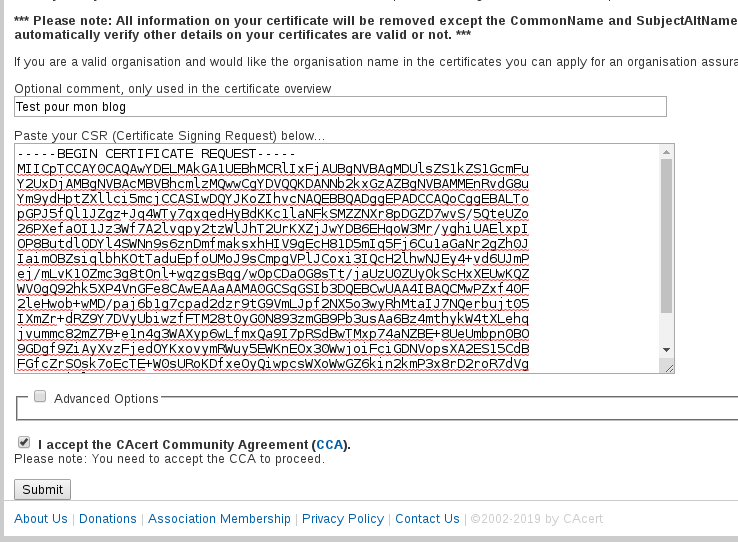

Vérifier le nom dans un certificat : pas trivial

Première rédaction de cet article le 15 décembre 2019

J'ai récemment eu à écrire un programme qui se connecte en TLS à un serveur et devait donc vérifier le certificat. La bibliothèque TLS utilisée ne vérifie pas que le nom dans le certificat correspond au nom demandé, c'est au programmeur de le faire, et ce n'est pas trivial, avec de nombreux pièges.

Un peu de contexte pour comprendre : le programme était un client DoT (DNS sur TLS, normalisé dans le RFC 7858). Il ne s'agit pas d'un client HTTP (qui ont tous des mécanismes de vérification du certificat). Au début, je me suis dit « pas de problème, je ne vais pas programmer TLS moi-même, de toute façon, cela serait très imprudent, vu mes compétences, je vais utiliser une bibliothèque toute faite, et, avantage en prime, j'aurais moins de travail ». Le client étant écrit en Python, j'utilise la bibliothèque pyOpenSSL, qui repose sur la bien connue OpenSSL.

Je prends bien soin d'activer la vérification du certificat et,

en effet, les certificats signés par une AC

inconnue, ou bien les certificats expirés, sont rejetés. Mais,

surprise (pour moi), si le nom dans le certificat ne correspond

pas au nom demandé, le certificat est quand même accepté. Voici un

exemple avec le client OpenSSL en ligne de commande, où j'ai mis

badname.example dans mon

/etc/hosts pour tester (une autre solution

aurait été d'utiliser l'adresse IP et pas le nom, pour se

connecter, ou bien un alias du nom) :

% openssl s_client -connect badname.example:853 -x509_strict

...

Certificate chain

0 s:CN = dot.bortzmeyer.fr

i:C = US, O = Let's Encrypt, CN = Let's Encrypt Authority X3

...

Et aucun message d'erreur, tout se passe bien, alors que le

certificat ne contenait pas du tout

badname.example.

Notez que c'est précisé. La documentation d'OpenSSL nous dit « You must confirm a match between the hostname you contacted and the hostnames listed in the certificate. OpenSSL prior to 1.1.0 does not perform hostname verification, so you will have to perform the checking yourself. ». Pourquoi cette absence de vérification ? Et comment faire la vérification ?

En fait, le problème n'est pas spécifique à OpenSSL. Le système de sécurité autour des certificats est un empilement complexe de normes. À la base, se trouve une norme UIT nommée X.509. Elle était disponible en ligne (depuis, l'UIT l'a fait disparaitre, où irions-nous si tout le monde pouvait lire les normes) et fait, aujourd'hui, 236 pages. Elle décrit le format des certificats, le rôle des AC, et plein d'autres choses, mais ne parle pas de la vérification des noms (on dit « sujets » et pas « noms », dans la terminologie X.509), et pour cause : X.509 permet de très nombreuses façons d'indiquer le sujet, ce n'est pas forcément un nom de domaine. Comme le dit sa section 9.3.1, « public-key certificates need to be usable by applications that employ a variety of name forms ». Une convention aussi banale que d'utiliser une astérisque comme joker n'est même pas mentionnée. Bref, X.509 ne va pas répondre à nos questions. Mais l'Internet n'utilise pas X.509. Il utilise la plupart du temps le protocole TLS, normalisé dans le RFC 8446. TLS utilise comme méthode d'authentification principale un certificat, décrit par un profil, une variation de X.509, ne gardant pas toutes les posssibilités de X.509, et en ajoutant d'autres. Ce profil est souvent nommé PKIX, pour Public-Key Infrastructure X.509 et est normalisé dans le RFC 5280. PKIX est plus précis que X.509 mais reste encore loin de tout spécifier, renvoyant souvent aux applications telle ou telle question. Par exemple, les jokers, déjà mentionnés, sont laissés à l'appréciation des applications. On comprend donc que les développeurs de OpenSSL n'aient pas inclus une vérification par défaut.

Pour compléter cette revue des normes, il faut citer surtout le RFC 6125, qui, lui, décrit précisément la vérification des sujets, quand ce sont des noms de domaine. C'est la principale source d'information quand on veut programmer une vérification du nom.

Ah, et, quand on teste, bien penser à séparer bibliothèque et

programme utilisant cette bibliothèque. Ce n'est pas parce que la

commande openssl peut tester le nom que la

bibliothèque le fait par défaut. L'option pertinente se nomme

-verify_hostname :

% openssl s_client -connect badname.example:853 -x509_strict -verify_hostname badname.example ... verify error:num=62:Hostname mismatch ...

Si on avait utilisé le bon nom (celui présent dans le

certificat,ici dot.bortzmeyer.fr),

on aurait eu :

Verification: OK

Verified peername: dot.bortzmeyer.fr

Notez bien que c'est une option. Si elle est mise sur la ligne de

commande, openssl demandera à la bibliothèque

OpenSSL de faire la vérification, mais cela ne sera pas fait

autrement. OpenSSL dispose d'un sous-programme

X509_check_host qui fait la vérification,

mais il n'est pas appelé par défaut, et il n'est pas présent

dans pyOpenSSL, la bibliothèque Python.

Par contre, avec la bibliothèque GnuTLS, le programme en ligne de commande fait cette vérification, par défaut :

% gnutls-cli --port 853 badname.example

...

Connecting to '2001:41d0:302:2200::180:853'...

...

- Certificate[0] info:

- subject `CN=dot.bortzmeyer.fr', issuer `CN=Let's Encrypt Authority X3,O=Let's Encrypt,C=US', serial 0x042ab817dad761f36920a3f2b3e7b780986f, RSA key 2048 bits, signed using RSA-SHA256, activated `2019-11-26 08:34:11 UTC', expires `2020-02-24 08:34:11 UTC', pin-sha256="eHAFsxc9HJW8QlJB6kDlR0tkTwD97X/TXYc1AzFkTFY="

...

- Status: The certificate is NOT trusted. The name in the certificate does not match the expected.

*** PKI verification of server certificate failed...

*** Fatal error: Error in the certificate.

Le sous-programme dans GnuTLS qui fait la vérification se nomme

gnutls_x509_crt_check_hostname.

Et si vous voulez faire cette vérification vous-même (ce qui n'est pas prudent mais on va dire qu'on veut vivre dangereusement) ? Il faut penser à plein de choses. Prenons l'exemple d'un programme en Python. Le test de base, où on compare le nom de serveur donné au « common name » (CN) dans le certificat :

if hostname == cert.get_subject().commonName:

est non seulement insuffisant (il ne tient pas compte des jokers, ou des « subject alternative name », ou SAN) mais il est en outre incorrect, le RFC 6125 disant bien, dans sa section 6.4.4, qu'il ne faut tester le « common name » que si tous les autres tests ont échoué. Il faut en fait tenir compte des SAN (Subject Alternative Names) contenus dans le certificat. Il faut examiner tous ces SAN :

for alt_name in get_certificate_san(cert).split(", "):

if alt_name.startswith("DNS:"):

(start, base) = alt_name.split("DNS:")

if hostname == base:

...

Rappelez-vous qu'un sujet, en X.509, n'est pas forcément un nom de domaine. Cela peut être une adresse IP, un URL, ou même du texte libre. Traitons le cas des adresses IP. Le certificat de Quad9 utilise de telles adresses :

% openssl s_client -connect 9.9.9.9:853 -showcerts | openssl x509 -text

...

X509v3 Subject Alternative Name:

DNS:*.quad9.net, DNS:quad9.net, IP Address:9.9.9.9, IP Address:9.9.9.10, IP Address:9.9.9.11, IP Address:9.9.9.12, IP Address:9.9.9.13, IP Address:9.9.9.14, IP Address:9.9.9.15, IP Address:149.112.112.9, IP Address:149.112.112.10, IP Address:149.112.112.11, IP Address:149.112.112.12, IP Address:149.112.112.13, IP Address:149.112.112.14, IP Address:149.112.112.15, IP Address:149.112.112.112, IP Address:2620:FE:0:0:0:0:0:9, IP Address:2620:FE:0:0:0:0:0:10, IP Address:2620:FE:0:0:0:0:0:11, IP Address:2620:FE:0:0:0:0:0:12, IP Address:2620:FE:0:0:0:0:0:13, IP Address:2620:FE:0:0:0:0:0:14, IP Address:2620:FE:0:0:0:0:0:15, IP Address:2620:FE:0:0:0:0:0:FE, IP Address:2620:FE:0:0:0:0:FE:9, IP Address:2620:FE:0:0:0:0:FE:10, IP Address:2620:FE:0:0:0:0:FE:11, IP Address:2620:FE:0:0:0:0:FE:12, IP Address:2620:FE:0:0:0:0:FE:13, IP Address:2620:FE:0:0:0:0:FE:14, IP Address:2620:FE:0:0:0:0:FE:15

Voici une première tentative pour les tester :

elif alt_name.startswith("IP Address:"):

(start, base) = alt_name.split("IP Address:")

if hostname == base:

...

Mais ce code n'est pas correct, car il compare les adresses IP

comme si c'était du texte. Or, les adresses peuvent apparaitre

sous différentes formes. Par exemple, pour

IPv6, le RFC 5952

spécifie un format canonique mais les certificats dans le monde

réel ne le suivent pas forcément. Le certificat de Quad9 ci-dessus

utilise par exemple 2620:FE:0:0:0:0:FE:10

alors que cela devrait être 2620:fe::fe:10

pour satisfaire aux exigences du RFC 5952. Il faut donc convertir les adresses IP en binaire

et comparer ces binaires, ce que je fais ici en Python avec la

bibliothèque

netaddr :

elif alt_name.startswith("IP Address:"):

(start, base) = alt_name.split("IP Address:")

host_i = netaddr.IPAddress(hostname)

base_i = netaddr.IPAddress(base)

if host_i == base_i:

...

Ce problème du format des adresses IP illustre un piège général lorsqu'on fait des comparaisons avec les certificats, celui de la canonicalisation. Les noms (les sujets) peuvent être écrits de plusieurs façons différentes, et doivent donc être canonicalisés avant comparaison. Pour les noms de domaine, cela implique par exemple de les convertir dans une casse uniforme. Plus subtil, il faut également tenir compte des IDN (RFC 5891). Le RFC 6125, section 6.4.2, dit qu'il faut comparer les « A-labels » (la forme en Punycode), on passe donc tout en Punycode (RFC 3492) :

def canonicalize(hostname):

result = hostname.lower()

result = result.encode('idna').decode()

return result

Vous pouvez tester avec www.potamochère.fr,

qui a un certificat pour le nom de domaine en

Unicode.

Ensuite, il faut tenir compte du fait que le certificat peut

contenir des jokers, indiqués par

l'astérisque. Ainsi,

rdap.nic.bzh présente un certificat avec un

joker :

% gnutls-cli rdap.nic.bzh ... - Certificate[0] info: - subject `CN=*.nic.bzh', issuer `CN=RapidSSL TLS RSA CA G1,OU=www.digicert.com,O=DigiCert Inc,C=US', serial 0x0a38b84f1a0b01c9a8fbc42854cbe6f6, RSA key 4096 bits, signed using RSA-SHA256, activated `2018-09-03 00:00:00 UTC', expires `2020-07-30 12:00:00 UTC', pin-sha256="2N9W5qz35u4EgCWxbdPwmWvf/Usz2gk5UkUYbAqabcA=" ...

Il faut donc traiter ces jokers. Attention, comme le précise le

RFC 6125 (rappelez-vous que la norme

X.509 ne parle pas des jokers), il ne faut

accepter les jokers que sur le premier composant du nom de domaine

(*.nic.bzh marche mais

rdap.*.bzh non), et le joker ne peut

correspondre qu'à un seul composant

(*.nic.bzh accepte

rdap.nic.bzh mais pas

foo.bar.kenavo.nic.bzh.) Cela se traduit

par :

if possibleMatch.startswith("*."): # Wildcard

base = possibleMatch[1:] # Skip the star

(first, rest) = hostname.split(".", maxsplit=1)

if rest == base[1:]:

return True

if hostname == base[1:]:

return True

return False

else:

return hostname == possibleMatch

Un point amusant : le RFC 6125 accepte

explicitement des astérisques au milieu d'un

composant, par exemple un certificat pour

r*p.nic.bzh accepterait

rdap.nic.bzh. Mon code ne gère pas ce cas

vraiment tordu, mais les développeurs d'OpenSSL l'ont prévu (si

l'option X509_CHECK_FLAG_NO_PARTIAL_WILDCARDS

n'est pas activée) :

/* Only full-label '*.example.com' wildcards? */

if ((flags & X509_CHECK_FLAG_NO_PARTIAL_WILDCARDS)

&& (!atstart || !atend))

return NULL;

/* No 'foo*bar' wildcards */

Autre cas amusant, le code de curl, quand il vérifie que le nom du

serveur correspond au contenu du certificat, refuse les jokers si

le nom dans le certificat n'a que deux composants. Le but est sans

doute d'éviter qu'un certificat pour *.com ne

permette de se faire passer pour n'importe quel nom en

.com mais cette règle,

qui ne semble pas être dans le RFC 6125,

n'est sans doute pas adaptée aux récents TLD

.BRAND, limités à une entreprise.

Au passage, j'avais dit au début que mon but initial était de tester un serveur DoT (DNS-over-TLS, RFC 7858). Le RFC original sur DoT ne proposait pas de tester le nom, estimant qu'un résolveur DoT serait en général configuré via son adresse IP, pour éviter un problème d'œuf et de poule (on a besoin du résolveur pour trouver l'adresse IP du résolveur…) La solution était d'authentifier via la clé publique du résolveur (l'idée a été développée dans le RFC 8310.)

Voilà, vous avez un exemple de programme Python qui met en

œuvre les techniques données ici (il est plus complexe, car il y a

des pièges que je n'ai pas mentionnés), en tls-check-host.py. Une autre solution, n'utilisant que la

bibliothèque standard de Python, est tls-check-host-std-lib.py, mais, attention, ladite

bibliothèque standard ne gère pas les IDN, donc ça ne marchera pas

avec des noms non-ASCII. (Mais son

utilisation évite de recoder la vérification.)

En conclusion, j'invite les programmeurs qui utilisent TLS à bien s'assurer que la bibliothèque TLS qu'ils ou elles utilisent vérifie bien que le nom de serveur donné corresponde au contenu du certificat. Et, si ce n'est pas le cas et que vous le faites vous-même, attention : beaucoup d'exemples de code source de validation d'un nom qu'on trouve au hasard de recherches sur le Web sont faux, par exemple parce qu'ils oublient les jokers, ou bien les traitent mal. Lisez bien le RFC 6125, notamment sa section 6, ainsi que cette page OpenSSL.

Merci à Patrick Mevzek et KMK pour une intéressante discussion sur cette question. Merci à Pierre Beyssac pour le rappel de ce que peut faire la bibliothèque standard de Python.

L'article seul

RFC 8674: The "safe" HTTP Preference

Date de publication du RFC : Décembre 2019

Auteur(s) du RFC : M. Nottingham

Pour information

Première rédaction de cet article le 5 décembre 2019

Ce nouveau RFC

définit une nouvelle préférence qu'un client HTTP peut envoyer au

serveur. « safe » (sûr) indique que le client

ne souhaite pas recevoir du contenu qu'il trouve contestable.

Je vous arrête tout de suite : vous allez me demander « mais qui

définit du contenu contestable ? Ça dépend des gens » et, je vous

rassure, l'auteur du RFC a bien vu le

problème. La préférence safe est juste une

possibilité technique, le RFC ne définit pas ce qui est sûr et ce

qui ne l'est pas, cela devra se faire dans un autre cadre, une

discussion à ce sujet serait bien trop casse-gueule pour

l'IETF. En pratique, le résultat de

l'utilisation de cette préférence dépendra de bien des choses, comme

la politique du serveur (le RFC dit « the cultural context

of the site »), et une éventuelle relation pré-existante

entre le serveur et un utilisateur particulier. Le RFC donne quand

même une indication : safe peut vouloir dire

« adapté aux mineurs ».

Il y a manifestement une demande, puisque bien des

sites Web ont un mode « sûr », où on peut

sélectionner « je ne veux pas voir des choses que je n'aime

pas ». Notez que, dans ces cas, la définition de ce qui est sûr ou

pas dépend du site Web. S'ils est géré aux

États-Unis, « sûr » sera sans doute « aucune

nudité humaine », en Arabie saoudite,

« aucune femme visible », etc. Ce mode « sûr » des sites Web n'est

pas pratique pour l'utilisateurice, car il nécessite de sélectionner

l'option pour chaque site, et de se créer un compte, soit explicite,

soit implicite via les

cookies (RFC 6265). À moins que le mode « sûr » soit le mode par défaut

et, dans ce cas, ce sont les gens qui n'en voudront pas qui auront

du travail. D'où l'idée, très controversée à l'IETF, de

configurer cela dans le navigateur Web (ou

bien dans le système d'exploitation, pour que

tous les clients HTTP le fassent), qui va indiquer au serveur

les préférences (un peu comme le Do Not

Track, dont on sait qu'il est largement ignoré

par les sites Web). La technique utilisée est celle des préférences

HTTP, normalisées dans le RFC 7240,

préférences dont je rappelle que leur respect par le serveur est

optionnel. La préférence safe envoyée par le

client est donc à prendre comme un appel à « faire au mieux » et

« je te fais confiance pour la définition de "sûr" », pas plus.

La section 2 de notre RFC est plus concrète, présentant la

syntaxe exacte de safe. Voici un exemple de

requête HTTP exprimant cette préférence :

GET /foo.html HTTP/1.1 Host: www.example.org User-Agent: ExampleBrowser/1.0 Prefer: safe

La préférence est enregistrée

à l'IANA. Le RFC impose que les requêtes « sûres » soient

faites en HTTPS, pour éviter la surveillance spécifique

des gens qui demandent du safe (et qui peuvent

être des enfants), et pour éviter qu'un intermédiaire ne bricole la

requête, ajoutant ou enlevant cette préférence. Une réponse possible

à la requête ci-dessus serait :

HTTP/1.1 200 OK Transfer-Encoding: chunked Content-Type: text/html Preference-Applied: safe Server: ExampleServer/2.0 Vary: Prefer

Le Vary: (RFC 7231,

section 7.1.4) indique aux relais/caches intermédiaires qu'ils

doivent tenir compte de la valeur de Prefer:

avant de renvoyer la page mémorisée à un autre client.

Si vous voulez tester en vrai, la page https://www.bortzmeyer.org/apps/pornPrefer: safe ou pas. Voici un exemple avec

curl :

% curl --header "Prefer: safe" https://www.bortzmeyer.org/apps/porn

Le code est du Python/WSGI et se résume à :

def porn(start_response, environ):

# Apache/WSGI always give us one Prefer: header even if the client sent several.

preferences = re.split("\s*,\s*", environ['HTTP_PREFER'])

safe = False

for pref in preferences:

if pref.lower() == 'safe':

safe = True

break

begin = """<html><head>..."""

end = """</body></html>"""

safe_content = """<p>Safe ..."""

unsafe_content = """<p>Unsafe ..."""

if safe:

output = begin + safe_content + end

else:

output = begin + unsafe_content + end

status = '200 OK'

response_headers = [('Content-type', 'text/html'),

('Content-Length', str(len(output)))]

start_response(status, response_headers)

return [output]

Cette préférence semble répondre à une forte demande, puisqu'elle est déjà reconnue :

- Dans Internet Explorer (cf. la documentation),

- Dans Bing (cf. Bing),

- Dans les boitiers Cisco (cf. la documentation).

La section 3 du RFC rassemble quelques informations de sécurité :

- HTTPS est indispensable, sinon un

intermédiaire pourra ajouter (ou retirer) la préférence

safe, - Paradoxalement,

safepeut être dangereux puisqu'il transmet une information supplémentaire au serveur, aidant au fingerprinting, - On n'a évidemment aucune garantie que le serveur a bien

adapté le niveau du contenu à ce qu'on voulait. Le RFC fait même

remarquer qu'un serveur sadique pourrait envoyer du contenu

« pire » lorsque la préférence

safeest présente.

Enfin, l'annexe A donne quelques conseils aux auteurs de

navigateurs quant à la mise en œuvre de cette

préférence. L'UI n'est pas évidente. Il est

crucial de ne pas donner à l'utilisateur ou l'utilisatrice

l'impression que cette préférence fournirait des garanties. Le RFC

suggère un texte plus prudent pour une case à

cocher « Demander du contenu "sûr" aux sites Web ». Et

l'annexe B a des conseils pour les gérants de sites Web comme, par

exemple, ne pas permettre aux utilisateurs de demander (via leur

profil, par exemple) d'ignorer la préférence

safe puisqu'elle a pu être placée par un

logiciel de contrôle parental.

Ce RFC a le statut « pour information » et a été publié sur la voie indépendante (cf. RFC 5742) puisqu'il n'a pas fait l'objet d'un consensus à l'IETF (euphémisme…) Les principales objections étaient :

- « Sûr » n'a pas de définition précise et universelle, le terme est vraiment trop vague,

- Les navigateurs Web envoient déjà beaucoup trop d'informations aux serveurs, en ajouter une, qui pourrait, par exemple, permettre de cibler les mineurs, n'est pas forcément une bonne idée.

L'article seul

RFC 8689: SMTP Require TLS Option

Date de publication du RFC : Novembre 2019

Auteur(s) du RFC : J. Fenton (Altmode Networks)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF uta

Première rédaction de cet article le 28 novembre 2019

Ah, la sécurité, c'est toujours compliqué. Pour le courrier électronique, par exemple, SMTP peut être fait sur TLS, pour garantir la confidentialité et l'intégrité du message. Mais TLS est optionnel. Cela entraine deux problèmes : si la politique du MTA est laxiste, le message risque de passer en clair à certains moments, et si elle est stricte, le message risque d'être rejeté alors que l'expéditeur aurait peut-être préféré qu'il passe en clair. Ce nouveau RFC fournit deux mécanismes, un pour exiger du TLS à toutes les étapes, un au contraire pour demander de la bienveillance et de la tolérance et d'accepter de prendre des risques.

SMTP

(RFC 5321) a une option nommée

STARTTLS (normalisée dans le RFC 3207), qui permet, si le pair en face l'accepte, de passer

la session SMTP sur TLS, assurant ainsi sa

sécurité. STARTTLS a plusieurs problèmes,

notamment son caractère optionnel. Même avec des sessions SMTP

entièrement TLS (sans STARTTLS, cf. RFC 8314), le problème demeure. Que doit faire un

MTA s'il ne peut

pas lancer TLS, parce que le MTA en face ne l'accepte pas, ou parce

que son certificat est invalide (RFC 6125) ou

encore car DANE (RFC 7672) est

utilisé et que le certificat ne correspond pas ? Jusqu'à présent, la

décision était prise par chaque MTA et, comme SMTP repose sur le

principe du relayage, l'émetteur original ne pouvait pas exprimer

ses préférences, entre « je suis parano, j'ai lu le bouquin de Snowden, j'exige du TLS

tout le temps » et « je m'en fous, je suis inconscient, je crois que

je n'ai rien à cacher, je

veux que le message soit envoyé, même en clair ». La politique des

serveurs SMTP était typiquement de privilégier la distribution du

message plutôt que sa sécurité. Désormais, il possible pour

l'émetteur de donner ses préférences : l'option SMTP

REQUIRETLS permet d'exiger du TLS tout le

temps, et l'en-tête TLS-Required: (bien mal

nommé) permet d'indiquer qu'on préfère au contraire la délivrance du

message à sa sécurité.

En général, aujourd'hui, les MTA acceptent d'établir la session TLS, même si

le certificat est invalide. En effet, dans le

cas contraire, peu de messages seraient livrés, les certificats dans

le monde du courrier étant fréquemment

invalides, à l'opposé de ce qui se passe dans le monde du Web, où les navigateurs sont bien plus

stricts. Pour durcir cette politique par défaut, et aussi parce

qu'un attaquant actif peut retirer l'option

STARTTLS et donc forcer un passage en clair, il existe

plusieurs mécanismes permettant de publier une politique, comme

DANE (RFC 7672) et

MTA-STS (RFC 8461). Mais elles sont contrôlées par le récepteur, et on

voudrait permettre à l'émetteur de donner son avis.

Commençons par REQUIRETLS, l'extension

SMTP. (Désormais dans le registre IANA des

extensions SMTP.) Il s'agit pour l'émetteur d'indiquer qu'il

ne veut pas de laxisme : il faut du TLS du début à la fin, et,

évidemment, avec uniquement des certificats valides. En utilisant

cette extension, l'émetteur indique qu'il préfère que le message ne

soit pas distribué, plutôt que de l'être dans de mauvaises

conditions de sécurité. Cette extension peut être utilisée entre

deux MTA, mais aussi quand un MUA se connecte au premier MTA, pour une

soumission de message (RFC 6409). Voici un

exemple (« C: » = envoyé par le client, « S: » = envoyé par le

serveur) :

S: 220 mail.example.net ESMTP C: EHLO mail.example.org S: 250-mail.example.net Hello example.org [192.0.2.1] S: 250-SIZE 52428800 S: 250-8BITMIME S: 250-REQUIRETLS C: MAIL FROM:<roger@example.org> REQUIRETLS S: 250 OK C: RCPT TO:<editor@example.net> S: 250 Accepted C: DATA S: 354 Enter message, ending with "." on a line by itself (Le message) C: . S: 250 OK C: QUIT

(Le lecteur ou la lectrice astucieux aura remarqué qu'il y a un

piège, le risque qu'un attaquant actif ne retire le

REQUIRETLS du client ou bien du serveur. Ce cas

est traité plus loin.)

Dans l'exemple ci-dessus, le serveur a annoncé qu'il savait faire

du REQUIRETLS, et le client a demandé à ce que

l'envoi depuis roger@example.org soit protégé

systématiquement par TLS. Cela implique que pour toutes les sessions

SMTP suivantes :

- L'enregistrement MX soit résolu en utilisant DNSSEC (ou alors on utilise MTA-STS, RFC 8461),

- Le certificat soit valide et soit authentifié par une AC ou par DANE,

- Le serveur suivant doit accepter la consigne REQUIRETLS (on veut une chaîne complète, de l'émetteur au récepteur).

Puisque l'idée est d'avoir du TLS partout, cela veut dire qu'un MTA

qui reçoit un message marqué REQUIRETLS doit

noter cette caractéristique dans sa base et s'en souvenir, puisqu'il

devra passer cette exigence au serveur suivant.

Si le serveur en face ne sait pas faire de

REQUIRETLS (ou, pire, pas de TLS), l'émetteur

va créer une erreur

commençant par 5.7 (les erreurs SMTP étendues sont décrites dans le

RFC 5248) :

REQUIRETLS not supported by server: 5.7.30 REQUIRETLS needed

Et l'en-tête TLS-Required: ? (Ajouté dans le

registre IANA des en-têtes.) Il fait

l'inverse, il permet à l'émetteur de spécifier qu'il préfère la

distribution du message à la sécurité, et qu'il faut donc débrayer

les tests qu'on pourrait faire. Ce nom de

TLS-Required: est mal choisi, car cet en-tête

ne peut prendre qu'une seule valeur, no (non),

comme dans cet exemple amusant du RFC :

From: Roger Reporter <roger@example.org>

To: Andy Admin <admin@example.com>

Subject: Certificate problem?

TLS-Required: No

Date: Fri, 18 Jan 2019 10:26:55 -0800

Andy, there seems to be a problem with the TLS certificate

on your mail server. Are you aware of this?

Roger

Si l'en-tête est présent, le serveur doit être plus laxiste que

d'habitude et accepter d'envoyer le message même s'il y a des

problèmes TLS, même si la politique normale du serveur serait de

refuser. Bien sûr, TLS-Required: no n'interdit

pas d'utiliser TLS, si possible, et l'émetteur doit quand même

essayer. Notez aussi que les MTA sont libres de leur politique et qu'on peut

parfaitement tomber sur un serveur SMTP qui refuse de tenir compte

de cette option, et qui impose TLS avec un certificat correct, même

en présence de TLS-Required: no.

(Le lecteur ou la lectrice astucieux aura remarqué qu'il y a un

piège, le risque qu'un attaquant actif n'ajoute

TLS-Required: no. Ce cas est traité plus

loin.)

Ah, et si on a les deux, REQUIRETLS et

TLS-Required: no ? La section 4.1 du RFC couvre

ce cas, en disant que la priorité est à la sécurité (donc,

REQUIRETLS).

La section 5 de notre RFC couvre le cas des messages d'erreur

générés par un MTA lorsqu'il ne peut pas ou ne veut pas envoyer le

message au MTA suivant (ou au MDA). Il

fabrique alors un message envoyé à l'expéditeur

(bounce, en anglais, ou message de non-distribution). Ce message contient

en général une bonne partie, voire la totalité du message

original. Sa confidentialité est donc aussi importante que celle du

message original. Si celui-ci était protégé par

REQUIRETLS, le courrier d'erreur doit l'être

aussi. Le MTA qui génère ce courrier d'erreur doit donc lui-même

activer l'extension REQUIRETLS. (Notez que,

comme le chemin que suivra cet avis de non-remise ne sera pas

forcément le même que celui suivi par le message originel, s'il y a

un serveur non-REQUIRETLS sur le trajet, le

courrier d'erreur ne sera pas reçu.)

Si un logiciel ré-émet un message (par exemple un gestionnaire de

liste de diffusion transmettant aux membres

de la liste, cf. RFC 5598), il devrait,

idéalement, appliquer également le REQUIRETLS

sur le message redistribué. Le RFC ne l'impose pas car, en pratique,

cela risquerait d'empêcher la réception du message par beaucoup.

Notre RFC se termine par une longue

section 8 sur la sécurité, car les problèmes qu'essaie de résoudre

ces solutions sont complexes. Le cas des attaques

passives est facile : TLS protège presque parfaitement

contre elles. Mais les attaques actives

soulèvent d'autres questions. REQUIRETLS mènera

à un refus des connexions SMTP sans TLS, protégeant ainsi contre

certaines attaques actives comme le SSL

stripping ou comme une attaque de

l'Homme du Milieu avec un mauvais

certificat. (Cette dernière attaque est facile aujourd'hui dans le

monde du courrier, où bien des serveurs SMTP

croient aveuglément tout certificat présenté.)

REQUIRETLS protège également contre beaucoup

d'attaques via le DNS, en exigeant

DNSSEC (ou, sinon,

MTA-STS).

Par contre, REQUIRETLS ne protège pas contre

un méchant MTA qui prétendrait gérer REQUIRETLS

mais en fait l'ignorerait. De toute façon, SMTP sur TLS n'a jamais

protégé des MTA intermédiaires, qui ont le texte du message en

clair. Si on veut se protéger contre un tel MTA, il faut utiliser

PGP (RFC 9580) ou

équivalent. (Par contre, le risque de l'ajout d'un

TLS-Required: no par un MTA malveillant ne

semble pas traité dans le RFC ; PGP ne protège pas contre cela.)

Il peut y avoir un conflit entre TLS-Required:

no et la politique du MTA, qui tient absolument à

vérifier les certificats des serveurs auxquels il se connecte, via

PKIX ou via DANE. Le RFC laisse

entendre que le dernier mot devrait revenir à l'expéditeur, au moins

si le message a été envoyé via TLS et donc pas modifié en route. (Le

cas d'un message reçu en clair - donc pas sécurisé - et demandant de

ne pas exiger TLS reste ouvert…)

Et pour finir, l'exemple de session SMTP où le serveur annonçait

qu'il gérait REQUIRETLS (en disant

250-REQUIRETLS) était simplifié. Si la session

commençait en clair, puis passait à TLS après, avec la commande

STARTTLS, le client doit recommencer la session

une fois TLS activé, pour être sûr que ce qu'annonce le serveur est réel.

Bien qu'il y ait déjà des programmeurs ayant travaillé sur ce RFC, je ne trouve encore rien du tout dans le source de Postfix, le MTA que j'utilise, même dans la version expérimentale.

L'article seul

Pourquoi ne pas mélanger résolveur DNS et serveur DNS faisant autorité ?

Première rédaction de cet article le 22 novembre 2019

Je donne souvent le conseil de ne pas configurer un serveur DNS à la fois en résolveur et en serveur faisant autorité. Mais pourquoi, au juste ?

D'abord, fixons la terminologie. Parler de « serveur DNS » tout

court (ou, encore pire de « DNS » pour désigner un serveur, du genre

« pour être sûr que la NSA ait mes données, j'utilise 8.8.8.8 comme DNS ») est

générateur de confusion. En effet, les deux types de serveurs DNS,

résolveurs et serveurs faisant

autorité sont très différents, posent des questions bien

diverses, et il est rare qu'on ait besoin de parler des deux

ensemble. Quand quelqu'un écrit ou dit « serveur DNS », il s'agit

en général de l'un ou de l'autre type, et cela vaudrait donc la

peine de le préciser. Les termes de résolveur

et de serveur faisant autorité sont bien

définis dans le RFC 9499 mais il est sans

doute utile de rappeler ces définitions et quelques explications

ici :

- Un résolveur (en anglais resolver) est un serveur DNS qui ne connait presque rien au démarrage, mais qui va interroger, pour le compte du client final, d'autres serveurs jusqu'à avoir une réponse qu'il transmettra au client final. Dans une configuration typique, le résolveur que vous utilisez est géré par votre FAI ou bien par le service informatique de l'organisation où vous travaillez. (Il existe aussi des résolveurs publics, comme ceux de Cloudflare ou de Quad9.)

- Un serveur faisant autorité (en anglais authoritative server, parfois bêtement traduit par « serveur autoritaire ») connait (« fait autorité pour ») une ou plusieurs zones DNS et il sert l'information sur ces zones aux résolveurs qui l'interrogeront. Il est typiquement géré par un hébergeur DNS ou par le bureau d'enregistrement ou directement par le titulaire du nom de domaine.

Par exemple, au moment de la rédaction de cet article, je suis dans

un train, avec le Wi-Fi, et le résolveur annoncé est

10.26.0.4, une machine gérée par la

SNCF. Si je veux me connecter à

celsa.fr, ma machine demandera au résolveur

10.26.0.4, qui relaiera aux deux serveurs

faisant autorité, ns0.idianet.net et

ns1.idianet.net (Idianet étant l'hébergeur DNS

choisi par le CELSA), puis me retransmettra

leur réponse.

La plupart des logiciels permettant de faire un serveur DNS ne permettent de faire qu'un résolveur, ou bien qu'un serveur faisant autorité. Comme je l'ai dit, c'est logique puisque ce sont deux fonctions très différentes, avec des problèmes bien distincts :

- Le serveur faisant autorité est public (s'il est interne à une organisation, la question de la séparation entre résolveur et serveur faisant autorité est différente), donc il doit faire face à un Internet pas toujours sympathique,

- Le résolveur, lui, est privé (il est déconseillé d'avoir des résolveurs ouverts, sauf si on est Google et qu'on sait ce qu'on fait, cf. RFC 5358),

- Le serveur faisant autorité a des temps de réponse connus, et une consommation de mémoire stable,

- Le résolveur, lui, ne sait pas à l'avance combien de temps prendront les requêtes, et il peut avoir à allouer des ressources variables,

- Et, bien sûr, le serveur faisant autorité connait exactement les données, alors que le résolveur les obtient de l'extérieur, ce qui diminue la confiance qu'on peut leur accorder.

Mais certains logiciels (comme BIND) permettent d'assurer les deux fonctions, et en même temps. Certains administrateurs système ont donc configuré une machine où le même démon est résolveur et serveur faisant autorité. C'est une mauvaise idée, et ces administrateurs système ont tort. Pourquoi ?

Le principal problème pratique est de débogage. En effet, si le même serveur DNS est à la fois résolveur et serveur faisant autorité, les réponses reçues par un client DNS peuvent être issues du résolveur ou directement des zones DNS gérées. Normalement, avec un logiciel bien fait, les données faisant autorité auront toujours priorité (c'est bien ce que veut dire « faire autorité ») et les données issues de la résolution ne les remplaceront jamais. C'est ainsi que se comporte BIND aujourd'hui, mais cela n'a pas toujours été le cas, et ce n'est toujours pas le cas pour d'autres logiciels. On voit ainsi parfois des données récupérées lors du processus de résolution (et donc moins fiables, surtout lors d'attaques type empoisonnement de cache) masquer les données faisant autorité.