Ce blog n'a d'autre prétention que de me permettre de mettre à la disposition de tous des petits textes que j'écris. On y parle surtout d'informatique mais d'autres sujets apparaissent parfois.

Fiche de lecture : Cryptographie par la pratique avec Python et OpenSSL

Auteur(s) du livre : Rémi Boulle

Éditeur : Dunod

978-2-10-087133-9

Publié en 2024

Première rédaction de cet article le 26 décembre 2024

Vous le savez tous et toutes, la cryptographie est une composante essentielle de la sécurité de l'Internet. Si tout le monde ne va pas devenir expert·e en cryptographie, en revanche, il est utile de connaitre les principes de base. Ce livre, destiné à des étudiant·es plutôt qu'au grand public, est une approche très concrète de la cryptographie, avec des exemples pratiques. J'ai beaucoup apprécié cette approche terre-à-terre.

Le livre commence par rappeler l'enjeu de la cryptographie, indispensable pour protéger l'utilisateurice de l'Internet des nombreuses activités de surveillance qui s'exercent contre lui ou elle. Les révélations d'Edward Snowden, par exemple, ont montré que la surveillance massive par les États est une réalité. La cryptographie soulève de nombreuses questions politiques, ce livre les mentionne mais parle surtout de technique.

Vous aurez en effet ensuite une explication des principes de la cryptographie, puis des différents algorithmes. Il faudra accepter un peu de mathématique, mais c'est nécessaire dans ce domaine.

Pour les exemples de code, le livre utilise Python, et commence par une

introduction (ou un rappel) de ce langage, si vous ne le connaissez

pas bien. Il dépend ensuite de plusieurs bibliothèques qu'il

présente, dont cryptography et,

comme le titre l'indique, OpenSSL. La

cryptographie nécessite des opérations de bas niveau, comme des

décalages de bits mais ne vous inquiétez pas, tout cela est

rappelé.

On commence par un exemple trivial et d'intérêt purement historique, l'algorithme de César :

import sys

KEY=3

def chiffre_Cesar_texte(texte_clair, k):

texte_chiffre = ""

for lettre in texte_clair:

code_lettre = ord(lettre)-65

chiffre = (code_lettre + k) % 26

lettre_chiffre = chr(chiffre + 65)

texte_chiffre = texte_chiffre + lettre_chiffre

return texte_chiffre

for texte in sys.argv[1:]:

print(chiffre_Cesar_texte(texte, KEY))

Mais vous aurez d'innombrables exemples de codes plus sérieux, utilisant des services réels, par exemple récupérer des données sur la chaine de blocs Bitcoin, l'analyser, la vérifier et même faire du minage de bitcoins. Même un·e connaisseur·se en cryptographie y découvrira certainement quelque chose, par exemple qu'il existe une courbe elliptique souveraine en France.

Conçu comme livre de classe, il contient de nombreux exercices. Si vous voulez récupérer l'intégralité des exemples et des solutions, allez sur le site officiel (on vous demande votre adresse de courrier mais mettez n'importe quoi, ça marche).

Le livre ne se contente pas de généralités sur la cryptographie mais explique aussi les détails de certains protocoles de communication sécurisés, très utilisés sur l'Internet, comme HTTPS et SSH, ou bien dans le contexte de l'Internet des objets, comme LoRaWAN, avec décorticage de paquets. Bref, si vous êtes prêt à vous plonger dans la cryptographie, voici un excellent guide.

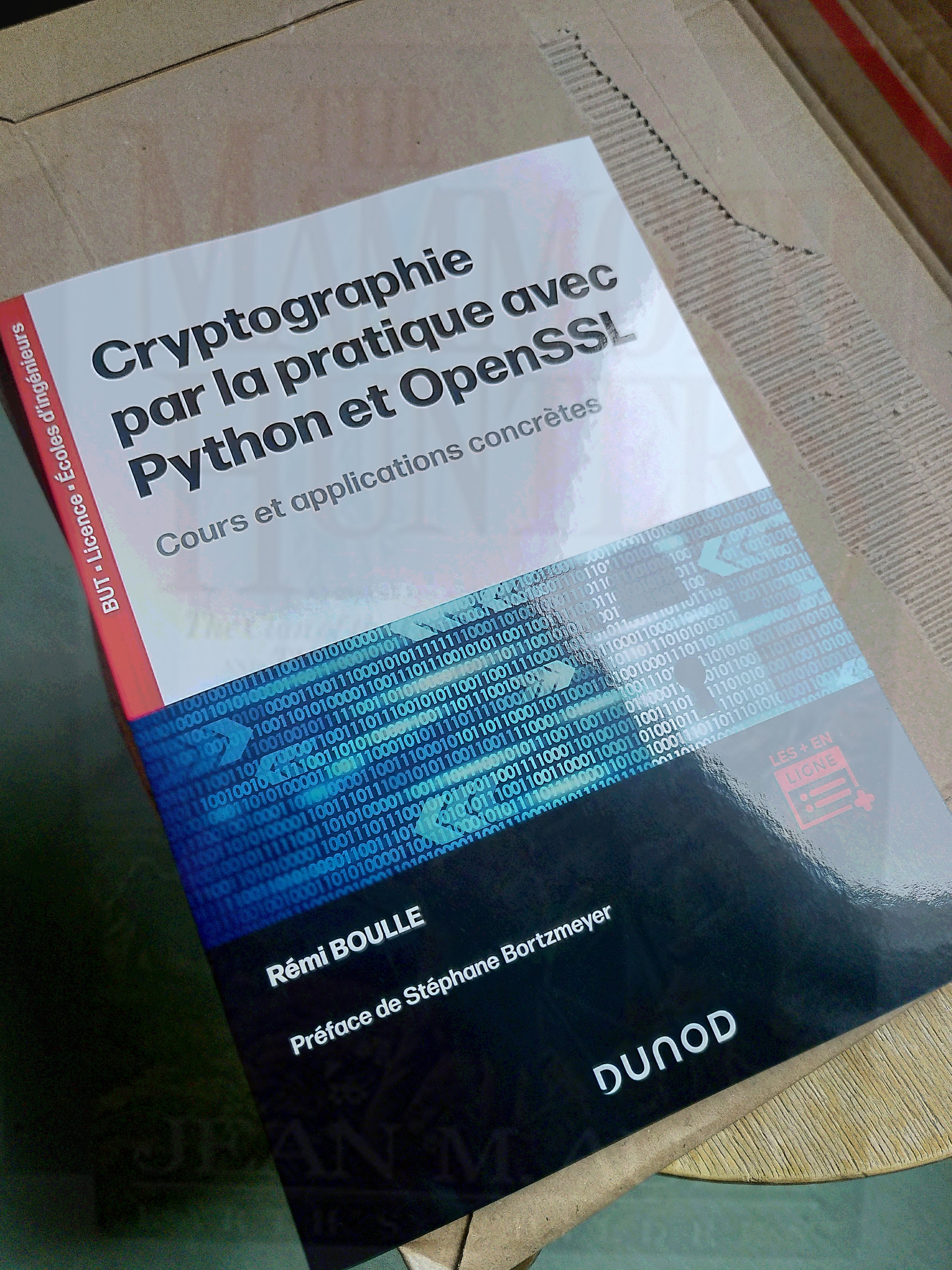

La photo du livre, ci-dessous, contient une autre image,

cachée. Lisez le chapitre sur la

stéganographie et vous pourrez récupérer

cette image cachée (les quatre bits de poids faible contiennent les

bits de poids fort de l'image cachée, cf. section 4.5.2, p. 43 et

44).

L'article seul

La robustesse de la connectivité Internet, l'exemple du Pakistan

Première rédaction de cet article le 22 décembre 2024

Si vous êtes en vacances dans les prochains jours, cela peut être l'occasion de lire des articles scientifiques riches. Par exemple, si vous voulez en apprendre davantage sur la robustesse des connexions Internet face aux coupures de câbles, regardez le cas du Pakistan dans cet article (en anglais).

Régulièrement, la question de la vulnérabilité des câbles qui forment l'infrastructure physique de l'Internet est posée. Souvent, elle est traitée de manière sensationnaliste (« les russechinoicoréeniraniens vont couper notre Internet, on ne pourra plus voir Netflix »), par exemple par des politiciens qui veulent jouer au chef de temps de guerre. Si on veut traiter le sujet plus sérieusement, il faut analyser en détail, et ça prend davantage de temps que de faire un titre putaclic. C'est ce que font Nowmay Opalinski, Zartash Uzmi et Frédérick Douzet pour le cas du Pakistan. Leur article « The Quest for a Resilient Internet Access in a Constrained Geopolitical Environment » étudie en détail la connectivité d'un pays. Combien de câbles vers l'extérieur ? Par où passent-ils ? (Je vous laisse lire l'article pour voir leur méthodologie, mais notez qu'il ne suffit pas d'étudier l'infrastructure physique, leur article décortique aussi l'infrastructure logicielle.) Cela donne une bonne idée de la robustesse de la connectivité d'un pays, de ses chances de résister à des coupures de câble, qu'elles soient volontaires ou accidentelles (et je rappelle qu'il y a davantage de maladroits que de malveillants).

Si vous regardez la carte, vous pouvez vous dire que le Pakistan n'a pas trop besoin de câbles sous-marins, il peut passer par des connexions terrestres avec ses voisins. Mais la question n'est évidemment pas purement technique, il faut prendre en question la géopolitique. Pas question de passer par l'Inde, par exemple. Et, avec l'Iran, ce n'est pas beaucoup mieux. Il reste l'Afghanistan… Et il y a même un lien avec la Chine, avec qui les relations sont bien plus cordiales, mais, ici, c'est la géographie qui n'est pas d'accord (le câble, dont l'utilisation n'est pas claire, passe par un col difficile).

Bref, les connexions internationales du Pakistan passent pour l'essentiel par des liaisons sous-marines depuis Karachi, vers des pays plus lointains. Une panne dans cette région met donc en péril toute la connectivité extérieure du pays.

Ce ne serait pas trop grave si les Pakistanais·es pouvaient encore dialoguer entre ielles. Mais, comme dans beaucoup de pays, les communications, même locales, sont souvent médiées par les GAFA. Et ceux-ci n'ont souvent pas d'infrastructure dans le pays, suggérant parfois de passer par l'Inde, ce qui est évidemment irréaliste vu les relations entre les deux pays. Une coupure des liens avec l'extérieur pourrait donc avoir de sérieuses conséquences. Si on utilisait davantage les liaisons pair-à-pair et l'auto-hébergement, il y aurait davantage de robustesse.

Un exemple (j'ai pris le DNS parce que c'est ce que je connais mais lisez l'article, il y aura d'autres exemples), l'instance de Google Public DNS qu'on peut joindre depuis le Pakistan, vue par les sondes RIPE Atlas, est aux Émirats, de l'autre côté du golfe :

% blaeu-resolve --requested 100 --country PK --nameserver 8.8.8.8 \

--nsid --type A lums.edu.pk

Nameserver 8.8.8.8

[110.93.234.24 111.68.103.174 203.135.62.24 NSID: gpdns-fjr;] : 3 occurrences

Test #85285321 done at 2024-12-22T13:48:31Z

(Voir mon autre article sur l'utilisation des sondes Atlas. Regardez le NSID - RFC 5001 de l'instance, qui pointe vers les EAU.)

En parlant d'histoire-géographie, notez aussi que l'article met en évidence que les liaisons intérieures du pays sont très concentrées dans la vallée de l'Indus. La technologie moderne utilise la même voie de communication qu'il y a cinq mille ans.

Quelques autres références :

- Un bon résumé (en anglais) par un des auteurs.

- Les transparents d'un exposé (en anglais) par ce même auteur à une réunion SANOG (très détaillés, avec cartes et photos).

- Le blog d'Anurag Bhatia (en anglais) est une des meilleures sources sur la connectivité Internet de la région (voir par exemple son « Pakistan-Europe connectivity via China » sur le lien à travers le col de Khunjerab).

- Loin du Pakistan, un exemple d'analyse sérieuse de coupure de câbles, loin de tout sensationnalisme, « Does the Internet Route Around Damage? - Baltic Sea Cable Cuts » et « A Deep Dive Into the Baltic Sea Cable Cuts ».

L'article seul

RFC 9639: Free Lossless Audio Codec

Date de publication du RFC : Décembre 2024

Auteur(s) du RFC : M.Q.C. van

Beurden, A. Weaver

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF cellar

Première rédaction de cet article le 19 décembre 2024

Le format FLAC, normalisé dans ce RFC, permet de stocker et de transmettre du son sans perte (contrairement à des mécanismes de compression comme MP3). Il est donc utile, par exemple pour l'archivage à long terme (mais aussi pour la haute fidélité).

Le multimédia, c'est compliqué. Le RFC fait près de 100 pages, pour un format audio qui se veut pourtant simple. FLAC fait de la compression pour limiter l'espace de stockage nécessaire mais en prenant soin de permettre une décompression qui redonne exactement le fichier originel (d'où le « sans perte » dans son nom, qu'il partage avec d'autres formats, comme le FFV1 du RFC 9043). Je ne connais pas assez le domaine de l'audio pour faire un résumé intelligent du RFC donc je vous invite à le lire si vous voulez comprendre comment FLAC fonctionne (les sections 4 à 6 vous font une description de haut niveau).

Si on prend un fichier FLAC, un programme comme file peut le comprendre :

% file Thélème.flac Thélème.flac: FLAC audio bitstream data, 24 bit, stereo, 44.1 kHz, length unknown

Le fait que l'échantillonage soit à 44,1 kHz est encodé dans les métadonnées (cf. section 9.1.2 du RFC), que file a pu lire (section 9.1.3 pour le fait que le fichier soit en stéréo).

Il y a quelques fichiers FLAC sur Wikimedia Commons. Mais un bon exemple de l'utilisation de FLAC est donné par l'enregistrement des Variations Goldberg par Kimiko Ishizaka, que vous pouvez télécharger en FLAC et sous une licence libre (CC0).

La mise en œuvre de référence de FLAC est en logiciel libre et se nomme libFLAC. Mais il existe beaucoup d'autres programmes qui savent gérer FLAC (j'ai écouté plusieurs fichiers FLAC avec vlc pour cet article), le lire, l'écrire, l'analyser, etc. Une liste est disponible sur le site du groupe de travail IETF. Il faut dire que FLAC, bien qu'il vienne seulement d'être normalisé, est un format ancien, dont le développement a commencé en 2000, et il n'est donc pas étonnant que les programmeur·ses aient eu le temps de travailler.

Si vous voulez ajouter du code à cette liste, lisez bien la section 11 du RFC, sur la sécurité. Un programme qui lit du FLAC doit être paranoïaque (comme avec n'importe quel autre format, bien sûr) et se méfier des cas pathologiques. Ainsi, le RFC note qu'on peut facilement créer un fichier FLAC de 49 octets qui, décomprimé, ferait 2 mégaoctets, ce qui pourrait dépasser la mémoire qui avait été réservée. Ce genre de surprises peut arriver à plusieurs endroits. L'annexe D du RFC contient plusieurs fichiers FLAC intéressants (et vous pouvez les retrouver en ligne) et il existe également une collection de fichiers FLAC, dont certains sont délibérément anormaux, pour que vous puissiez tester la robustesse de votre programme. Autre piège (mais lisez toute la section 11, il y en a beaucoup), FLAC permet de mettre des URL dans les fichiers, URL qu'il ne faut évidemment pas déréférencer bêtement.

Ce RFC est également la documentation pour l'enregistrement

du type MIME audio/flac

(section 12.1).

Pour une analyse technique de la prétention « sans perte » de FLAC, voir cet article de Guillaume Seznec.

L'article seul

RFC 9300: The Locator/ID Separation Protocol (LISP)

Date de publication du RFC : Octobre 2022

Auteur(s) du RFC : D. Farinacci (lispers.net), V. Fuller (vaf.net Internet Consulting), D. Meyer (1-4-5.net), D. Lewis (Cisco Systems), A. Cabellos (UPC/BarcelonaTech)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF lisp

Première rédaction de cet article le 14 décembre 2024

Le protocole LISP (qui n'a rien à voir avec le langage de programmation du même nom), vise à résoudre un problème documenté dans le RFC 4984 : les difficultés que rencontre le système de routage de l'Internet devant les pressions imposées par la croissance du réseau et par le désir des utilisateurs de ne pas être lié à un unique fournisseur d'accès. Actuellement, tout changement de routage sur n'importe quel site se propage à tous les autres routeurs de la DFZ. Un tel système ne passe pas réellement à l'échelle (il ne peut pas croitre indéfiniment). LISP propose une solution, dans un ensemble de RFC dont ce RFC 9300 (qui succède au RFC 6830) est le principal. LISP n'est désormais plus considéré comme expérimental et ce nouveau RFC est sur le chemin des normes (Standards Track) mais, en pratique, le projet LISP semble plutôt en panne.

Avant de plonger dans ce RFC, voyons les motivations pour LISP et ses principes essentiels (si vous préférez les lire dans le RFC et pas dans mon article, c'est en section 4 mais la lecture recommandée est le RFC 9299). Aujourd'hui, les adresses IP ont deux rôles, localisation (où suis-je connecté au réseau) et identité (qui suis-je). Une adresse IP est un localisateur car changer de point d'attachement (par exemple parce qu'on change de FAI) vous fait changer d'adresse IP, et c'est un identificateur car c'est ce qui est utilisé par les protocoles de transport comme TCP pour identifier une session en cours : changer d'adresse IP casse les connexions existantes.

Le principal problème de cette approche concerne le routage. Un routage efficace nécessiterait une cohérence entre les adresses et la topologie du réseau, par exemple que deux sites proches sur le réseau aient des adresses proches. Mais on n'a pas cette cohérence actuellement. On notera qu'IPv6 ne résolvait pas ce problème, et délibérément (le cahier des charges d'IPv6 ne prévoyait pas de changer le modèle de routage).

Résultat, les routeurs doivent gérer bien plus de routes que nécessaire, augmentant leur prix (en attendant le jour où, même en payant, on n'arrivera pas à manipuler autant de routes, avec leurs changements fréquents). Le RFC 4984 insistait sur ce problème en affirmant que « The workshop participants believe that routing scalability is the most important problem facing the Internet today and must be solved, although the time frame in which these problems need solutions was not directly specified. »

Cette croissance de la table de routage peut être suivie sur le célèbre site de Geoff Huston. Notez que la taille n'est pas le seul aspect, le rythme de changement (le nombre d'updates BGP par seconde) est au moins aussi important.

LISP vise donc à résoudre ce problème par une technique connue sous le nom de séparation du localisateur et de l'identificateur (son nom, « Locator/ID Separation Protocol », en dérive d'ailleurs, bien qu'il soit loin d'être le seul protocole dans cette catégorie). Au lieu que tous les préfixes IP aillent dans la DFZ, seuls les localisateurs, les RLOC (Routing LOCators) y iront. Les identificateurs, les EID (Endpoint IDentifiers) sont dans un nouveau système, le système de correspondance (mapping, RFC 9301), qui permettra de trouver un RLOC à partir d'un EID. LISP est donc l'application d'un vieux principe de l'informatique : « Tout problème peut être résolu en ajoutant un niveau d'indirection. »

À quoi ressemblent RLOC et EID ? Physiquement, ce sont juste des adresses IP (v4 ou v6), avec une nouvelle sémantique. Le RFC 8060 décrit plus en détail comment représenter les EID.

Par rapport aux autres solutions de séparation de l'identificateur et du localisateur (la plus achevée étant HIP), LISP s'identifie par les points suivants :

- Solution dans le réseau, pas dans les machines terminales. Seuls des routeurs (mais pas tous les routeurs de l'Internet) seront modifiés pour gérer LISP.

- Déployable de manière incrémentale (il n'est pas nécessaire que tout le monde passe à LISP).

- Pas de cryptographie (et donc pas plus de sécurité que l'IP d'aujourd'hui).

- Indépendant de la famille IP utilisée (v4 ou v6).

- Outre une solution au problème du passage à l'échelle du système de routage, LISP se veut aussi utilisable pour la mobilité et la virtualisation de réseaux (imaginez une machine virtuelle migrant d'un centre d'hébergement à un autre sans changer d'identificateur...).

Comment se passe l'envoi d'un paquet avec LISP ? Supposons qu'une machine

veuille écrire à www.example.com. Elle utilise

le DNS comme

aujourd'hui, pour trouver que l'adresse est

2001:db8:110:2::e9 (c'est un EID, un

identificateur, mais la machine n'a pas besoin de le savoir, les

machines terminales ne connaissent pas LISP et ne savent même pas

qu'elles l'utilisent). Elle envoie le paquet à son routeur

habituel. À un moment dans le réseau, le paquet va arriver dans un

routeur LISP (qui, lui, a été modifié pour gérer LISP). Il va alors

chercher le RLOC (le localisateur). Il demande au système de

correspondance (l'équivalent LISP du DNS) qui va lui dire « le RLOC de

2001:db8:110:2::e9 est

198.51.100.178 » (notez au passage que RLOC et

EID peuvent être des adresses v4 ou v6). (L'information est stockée

dans un cache du

routeur, pour le prochain paquet.) Le paquet est alors encapsulé dans un paquet

LISP qui est transmis en UDP (port 4341) à

198.51.100.178. (En raison de ces deux étapes,

correspondance puis encapsulation, LISP fait partie des protocoles

nommés Map and Encap.)

198.51.100.178 décapsule et le paquet suit

ensuite un chemin normal vers la machine

2001:db8:110:2::e9. Pendant le trajet dans le

tunnel,

le paquet aura donc deux en-têtes, l'interne

(celui placé par la machine d'origine et qui utilise des EID dans

les champs « Adresse IP source » et « Adresse IP destination ») et

l'externe (celui placé par le routeur d'entrée du tunnel, et qui

utilise des RLOC).

Si le système de correspondance avait répondu négativement « Ce

n'est pas un EID, je n'ai pas de RLOC pour

2001:db8:110:2::e9 » (Negative map

reply) ? Cela aurait voulu dire que le site cible

n'utilise pas LISP et, dans ce cas, on lui transmet le paquet par

les mécanismes habituels d'IP.

Ainsi, pour prendre le scénario d'usage principal de LISP, un site qui veut être multi-homé n'aura pas besoin de BGP et d'annoncer ses routes dans la DFZ. Il aura ses identificateurs, ses EID, et les paquets entrant ou sortant de son réseau seront encapsulés en LISP (le système de correspondance peut renvoyer plusieurs RLOC pour un EID, avec des préférences différentes, pour faire de l'ingénierie de trafic). Pour les routeurs de la DFZ, ce seront juste des paquets IP ordinaires. Seules les deux extrémités du tunnel sauront que LISP est utilisé.

Le système de correspondance de LISP n'est pas unique : plusieurs choix sont possibles comme ALT (RFC 6836). Comme le DNS, il fonctionne en tirant les informations nécessaires (pas en les poussant vers tout le monde, comme le fait BGP), ce qui devrait lui donner une bonne capacité de croissance. De toute façon, LISP spécifie une interface vers le système de correspondance (RFC 9301) et les différents systèmes ont juste à mettre en œuvre cette interface pour qu'on puisse en changer facilement. Ainsi, ALT pourra être remplacé par un de ses concurrents, CONS, EMACS ou NERD (leurs noms sont des références au langage de programmation). NERD est documenté dans le RFC 6837.

Ce RFC est un gros morceau (d'autant plus que d'autres parties de LISP sont dans d'autres RFC). Je ne vais pas le couvrir en entier. Mais quelques points méritent d'être gardés en tête :

- Un paquet dont l'adresse de destination est un EID ne peut être acheminé que via LISP. L'EID n'est pas routé sur l'Internet habituel. (Les EID peuvent être des adresses RFC 1918, par exemple.)

- Pour éviter que la base des EID ne pose les mêmes problèmes de croissance que la DFZ d'aujourd'hui, les EID seront agrégés, mais cela sera fait de manière indépendante de la topologie : si on change de FAI, cette agrégation ne changera pas.

Pour les fanas de format de paquets, la section 5 décrit l'encapsulation. LISP est indépendant de la famille d'adresses, donc on peut avoir un paquet IP où les EID sont IPv4 qui soit tunnelé avec des RLOC IPv6 ou bien le contraire. Devant le paquet normal, LISP va ajouter un en-tête IP standard pour les RLOC, où la source sera l'ITR (routeur d'entrée du tunnel) et la destination l'ETR (routeur de sortie du tunnel), puis un en-tête UDP (l'UDP a davantage de chances de passer les middleboxes que de l'IP mis directement dans l'IP, des protocoles comme QUIC ont le même problème), avec le port de destination à 4341, puis un en-tête spécifique à LISP et enfin le paquet original. Donc, pour résumer :

- En-tête du paquet original (inner header en terminologie LISP) : les adresses IP source et destination sont des identificateurs, des EID,

- En-tête vu par les routeurs situés entre l'ITR et l'ETR (outer header) : les adresses IP source et destination sont des localisateurs, des RLOC.

L'en-tête spécifique à LISP contient notamment (section 5 si vous voulez tout connaître) :

- Cinq bits de contrôle, nommés N, L, E, V et I

- Si le bit N est à 1, un champ Nonce (section 10.1). Il s'agit d'un nombre tiré au hasard : si le destinataire d'un paquet peut le renvoyer, cela prouve qu'il avait reçu le message original (et qu'on parle donc bien au bon destinataire : ce numnique sert à éviter les attaques en aveugle).

- Si le bit L est à 1, un champ Locator Status Bits, qui indique l'état (joignable ou pas) des machines situées sur le site de départ du paquet. (À ne pas utiliser sur l'Internet public, cf. section 4.1.)

Comme toutes les solutions à base de tunnel, LISP va souffrir de la mauvaise gestion de la PMTUD dans l'Internet d'aujourd'hui (cf. RFC 4459), l'en-tête LISP supplémentaire réduisant la MTU (cf. section 7 pour des solutions possibles).

La section 5 décrivait les paquets de données, ceux encapsulant les données envoyées par le site original. La section 6 couvre les paquets de contrôle, utilisés par LISP pour ses propres besoins, notamment le système de correspondance (cf. RFC 9301 pour les détails). On y retrouve l'utilisation d'UDP :

- Map Requests, où le port de destination est 4342,

- Map Replies,

- et quelques autres qui partagent des formats proches.

Il est évidemment essentiel qu'on sache si son correspondant est joignable ou pas. Comment cette « joignabilité » est-elle vérifiée ? La section 6.3 énumère les mécanismes disponibles. Entre autres :

- Les Locator Status Bits où un ITR (le routeur LISP à l'entrée du tunnel) indique si les sites qu'il contrôle sont joignables. Si on souhaite répondre à un message transmis en LISP, c'est une information cruciale. (Ils ne doivent pas être utilisés sur l'Internet public, voir la section 4.1 pour les détails.)

- Les classiques messages ICMP comme Host Unreachable. Comme ils ne sont pas authentifiés, les croire aveuglément est dangereux. Mais les ignorer totalement serait dommage.

- La réception récente d'un message Map Reply est une bonne indication que le site à l'autre bout fonctionne.

Mais on peut aussi tester explicitement, par le mécanisme Echo Nonce de la section 10.1. Le testeur émet un message LISP avec les bits N (numnique présent) et E (écho demandé), met le numnique à une valeur aléatoire (RFC 4086), et envoie le paquet. (La section 4.1 précise toutefois que cela ne doit pas être utilisé sur l'Internet public.) L'ETR à l'autre bout doit normalement renvoyer ce numnique dans son prochain paquet. Notons que cela teste la bidirectionnalité de la connexion. Si on n'obtient pas de réponse, cela peut signifier que la connexion est complètement coupée ou tout simplement qu'elle ne marche que dans un seul sens. Mais, surtout, l'absence de réponse peut indiquer le cas où l'ETR qui reçoit le trafic pour un site n'est pas le même routeur que l'ITR qui génère le trafic sortant. Dans ce cas, l'absence de réponse n'est pas un problème. Enfin, le routeur en face peut tout simplement être configuré pour ignorer les demandes d'écho.

Une autre solution pour tester est donc d'utiliser les messages du système de correspondance EID->RLOC, les Map Request et Map Reply. Ces messages ont un bit P (pour probe) qui indique que le demandeur est intéressé par la joignabilité du site demandé.

LISP impose donc des traitements supplémentaires, par rapport à ceux de l'IP classique. Est-ce que cela ne ralentit pas trop les routeurs ? La section 15 explore le problème et explique pourquoi LISP ne nécessite pas de changement du matériel de forwarding (les ASIC du routeur). La plupart des routeurs ont déjà du code prévu pour gérer des tunnels (encapsuler et décapsuler) rapidement.

Comment sera déployé LISP ? Le RFC 7215 décrit plusieurs scénarios possibles et les détails. Principal problème : combien d'ITR et d'ETR pour un opérateur ? Grâce aux tunnels, on peut n'avoir qu'un seul ITR et un seul ETR pour tout le trafic. Cela poserait évidemment des problèmes de redondance et de performance. Mais avoir beaucoup de xTR peut poser des problèmes d'administration. Si les ITR sont largement automatiques (leur cache des correspondance EID->RLOC est bâti dynamiquement), avoir beaucoup d'ETR risque d'être compliqué à maintenir (car l'ETR doit avoir dans sa configuration une liste des EID qu'il va gérer).

Un des gros problèmes que pose la séparation de l'identificateur et du localisateur est la sécurité : nouvelles attaques (par exemple contre le système de correspondance), nouveaux pièges (une machine qui utiliserait le vrai RLOC mais mentirait sur l'EID, par exemple). La section 16 du RFC examine les risques théoriquement présents dans LISP, mais lisez aussi les RFC 7835 et RFC 9303.

Comme avec toutes les techniques de tunnel, un émetteur peut facilement tricher sur l'adresse source interne (celle qui sera utilisée après décapsulation par l'ETR). Pour se protéger, un ITR devrait n'encapsuler un paquet que si l'adresse source est un EID qu'il contrôle. Et un ETR ne devrait transmettre un paquet que si la destination est un EID sous sa responsabilité.

Le test de la réversibilité (via les numniques, cf. section 3) est essentiel contre ces risques. Sans ce test, un ETR pirate pourrait par exemple envoyer un Map Reply en réponse aveugle à un Map Request, et le voir accepté, avec des données mensongères (naturellement, l'ITR n'accepte que des Map Replies qui sont en réponse à un Map Request de sa part). Avec ce système de numnique que le récepteur doit mettre dans sa réponse, un attaquant aveugle (qui n'est pas situé sur le chemin des paquets et ne peut donc pas les observer) aura donc peu de chances de réussir à faire accepter ses paquets.

En revanche, un attaquant situé sur le chemin, et qui peut observer les paquets qui passent, a la possibilité de commettre bien plus de dégâts. Mais c'est déjà le cas avec les protocoles actuels (par exemple, les numéros de séquence difficiles à deviner du RFC 6528 ne protègent pas TCP contre des attaquants situés sur le chemin).

Les attaques par déni de service sont évidemment possibles avec LISP : une des précautions recommandées est de limiter le trafic des Map Requests et Map Replies. Autre attaque par déni de service, un ITR peut être victime d'une machine qui essaie de remplir la table des correspondances EID->RLOC du routeur. Il est donc important d'envisager ce cas, par exemple en permettant de garder dans le cache les entrées les plus fréquemment accédées (pour éviter qu'elles ne soient retirées automatiquement pour faire de la place). Mais il n'existe pas de solution miracle contre ce problème d'envahissement de cache.

Le fonctionnement de LISP est schématisé sur ce dessin : Alice a l'identificateur (EID)

2001:db8:1::1 et veut écrire à Bob qui a le

2001:db8:2::42 (dans la plupart des cas, Alice

aura trouvé l'adresse de Bob dans le DNS, comme aujourd'hui). Ni Alice, ni Bob n'ont

à connaître LISP, chacun croit utiliser de l'IP normal. Alice envoie

donc un paquet standard, à destination de

2001:db8:2::42. Mais, sur le trajet, il y a un

ITR, un routeur LISP. Celui-ci va chercher (dans le système de

correspondance, non montré ici) le RLOC (le localisateur) de Bob

(ou, plus exactement, de son site). Une fois qu'il a trouvé

2001:db8:ff::666, il encapsule le paquet

derrière un en-tête LISP et envoie ce paquet à l'ETR, l'autre

routeur LISP en face, 2001:db8:ff::666. Les

routeurs de l'Internet, entre l'ITR et l'ETR, ne connaissent pas

LISP non plus et routent ce qui leur semble un paquet IP

normal. Arrivé à l'ETR, le paquet est décapsulé et poursuit son

chemin par du routage IP classique. Sur tout le schéma, seuls l'ITR

et l'ETR sont des nouveautés LISP.

Modifions légèrement le schéma pour y mettre le système de

correspondance : On y voit l'ITR

demander à son résolveur « Quel est le localisateur de

2001:db8:2::42 ? » et son résolveur lui

répondre. Le résolveur avait demandé au serveur qui avait reçu de

l'ETR un enregistrement disans « Le localisateur de

2001:db8:2::42 est

2001:db8:ff::666 ». Entre le résolveur et le

serveur se trouve le cœur du système de correspondance. LISP

en a plusieurs possibles, comme le ALT du RFC 6836.

Où trouve-t-on du code LISP aujourd'hui ?

- Bien sûr dans IOS puisque LISP est l'enfant de Cisco.

- FreeBSD avait OpenLISP, qui semble abandonné (ou intégré dans le système ? Quelqu'un sait ?).

- Pour Linux, je ne connais que LispMob, qui traite un besoin spécifique (la mobilité).

- Il parait qu'un code Cisco mettant en œuvre LISP tourne sur Android.

Comme pour tous les protocoles fondés sur le principe de la séparation de l'identificateur et du localisateur, il est toujours utile, si on veut en comprendre les principes, de (re)lire l'article fondateur de Chiappa, « Endpoints and Endpoint names: A Proposed Enhancement to the Internet Architecture ». Autres articles à lire :

- Le RFC 9299, une introduction à LISP et ses concepts,

- Un bon résumé de LISP.

- Le premier article pratique sur le protocole. Avec instructions, commandes, et résultat (sur des routeurs Cisco). Parfait pour les ingénieurs qui ont du mal à se taper les RFC LISP mais veulent quand même comprendre comment ça marche. Très détaillé. Le même auteur a d'autres articles sur LISP comme celui expliquant comment tunneler IPv6 sur IPv4.

- Le compte-rendu de la connexion de Facebook à LISP (Facebook a été le premier gros site à sauter le pas mais je ne sais pas si cela fonctionne toujours aujourd'hui).

La section 18 de notre RFC décrit les changements depuis le RFC 6830. Le principal est bien sûr que LISP n'est plus considéré comme expérimental, on peut le déployer sur l'Internet public, modulo les précautions de la section 4.1. Sinon :

- Les trois bits qui étaient réservés dans l'en-tête ont été alloués par le RFC 8061,

- La récolte automatique d'informations de correspondance entre EID et RLOC (gleaning) est désormais optionnelle,

- Sur la forme, notons que bien des points, notamment le mécanisme de contrôle (et pas seulement d'acheminement de données) ont été déplacés vers le RFC 9301.

La section 4.1 décrit ce qu'il faut faire et ne pas faire lorsqu'on déploie LSIP « en vrai » sur l'Internet public. Quand on n'est plus expérimental, il faut faire attention. Bien des techniques de LISP (comme la mise à jour automatique des données des routeurs juste en regardant un paquet qui passe, le gleaning, clairement dangereux) ne sont sûres que dans un environnement fermé.

L'article seul

RFC 9549: Internationalization Updates to RFC 5280

Date de publication du RFC : Mars 2024

Auteur(s) du RFC : R. Housley (Vigil Security)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF lamps

Première rédaction de cet article le 22 novembre 2024

Ce court RFC ajoute aux certificats PKIX du RFC 5280 la possibilité de contenir des adresses de courrier électronique dont la partie locale est en Unicode. Et il modifie légèrement les règles pour les noms de domaine en Unicode dans les certificats. Il remplace le RFC 8399, avec peu de changements.

Les certificats sur

l'Internet sont normalisés dans le RFC 5280, qui décrit un profil de

X.509 nommé PKIX

(définir un profil était nécessaire car la norme X.509 est bien trop

riche et complexe). Ce RFC 5280 permettait des

noms de domaine en

Unicode (sections 4.2.1.10 et 7 du RFC 5280) mais il suivait l'ancienne norme IDN, celle des

RFC 3490 et suivants. Depuis, les IDN sont

normalisés dans le RFC 5890 et suivants, et

notre nouveau RFC 9549 modifie très légèrement le RFC 5280 pour s'adapter à cette nouvelle norme de

noms de domaines en Unicode. Les noms de domaine dans un certificat

peuvent être présents dans les champs Sujet (titulaire du

certificat) et Émetteur (AC ayant signé le certificat) mais aussi

dans les contraintes sur le nom (une autorité de certification peut être

limitée à des noms se terminant en example.com,

par exemple).

Notez que, comme avant, ces noms sont exprimés dans le certificat

en Punycode (RFC 3492,

xn--caf-dma.fr au lieu de

café.fr), appelé A-label

dans notre RFC. C'est un bon exemple du fait que les

limites qui rendaient difficiles d'utiliser des noms de domaine en

Unicode n'avaient rien à voir avec le DNS (qui n'a jamais été limité à

ASCII, contrairement à ce qu'affirme une légende

courante). En fait, le problème venait des applications (comme

PKIX), qui ne s'attendaient pas à des noms en

Unicode. Un logiciel qui traite des certificats aurait été bien

étonné de voir des noms de domaines non-ASCII, et

aurait peut-être planté. D'où ce choix du

Punycode (A-label) par opposition à la forme plus

lisible du U-label.

Nouveauté plus importante du RFC 8399, mis à jour par notre RFC 9549, les adresses de courrier électronique en Unicode (EAI pour Email Address Internationalization). Elles étaient déjà permises par la section 7.5 du RFC 5280, mais seulement pour la partie domaine (à droite du @). Désormais, elles sont également possibles dans la partie locale (à gauche du @). Le RFC 8398 donne tous les détails sur ce sujet.

Reste à savoir quelles AC acceptent

Unicode. En 2018, j'avais testé avec

Let's Encrypt (avec le

client Dehydrated, en

mettant le Punycode dans domains.txt) et ça

marchait, regardez le certificat de https://www.potamochère.fr/

% gnutls-cli www.potamochère.fr

...

- subject `CN=www.xn--potamochre-66a.fr', issuer `CN=R10,O=Let's Encrypt,C=US', serial 0x03a34cfc017b4311da0b21797cd250ebd3c0, RSA key 4096 bits, signed using RSA-SHA256, activated `2024-11-01 05:26:59 UTC', expires `2025-01-30 05:26:58 UTC', pin-sha256="6y…

D'autres AC acceptent ces noms en Unicode : Gandi le fait aussi, par exemple. On

notera que le célèbre service de test de la qualité des

configurations TLS, SSLlabs, gère bien les IDN :

Enfin, le registre du

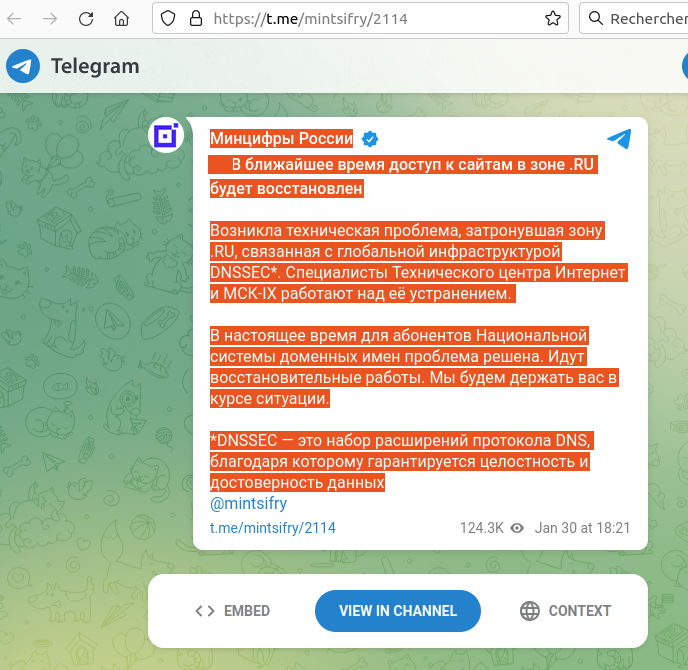

.ru a participé au développement de

logiciels pour traiter l'Unicode dans les certificats.

La section 1.2 résume les changements depuis le RFC 8399. Notamment :

- Le RFC 8399 ne les mentionnait pas

mais les emojis ne sont pas

autorisés dans les noms de domaine (ils appartiennent à la

catégorie Unicode So, « Autres symboles », que le RFC 5890 n'inclut pas). Comme le rappelle notre RFC 9549, un nom comme

♚.examplene serait pas légal. Ce point est désormais explicite. - Si le RFC 8399 prescrivait certains

traitements à faire sur la forme Unicode

(U-label) des noms, désormais, tout se fait sur

la forme en Punycode (A-label, donc

xn--potamochre-66a.fret paspotamochère.fr). Cela permet d'éviter de déclencher certaines failles de sécurité.

L'article seul

RFC 9682: Updates to the CDDL grammar of RFC 8610

Date de publication du RFC : Novembre 2024

Auteur(s) du RFC : C. Bormann (Universität Bremen

TZI)

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF cbor

Première rédaction de cet article le 19 novembre 2024

Voici une légère mise à jour de la grammaire du langage de description de schéma CDDL (Concise Data Definition Language), originellement normalisé dans le RFC 8610. Pas de gros changement.

Il y avait juste quelques errata à traiter, et des ambiguités concernant notamment les chaines de caractères. Il était devenu nécessaire de modifier l'ABNF. CDDL a été décrit dans le RFC 8610, puis étendu par le RFC 9165. Il vise à décrire un schéma pour des fichiers CBOR ou JSON. Depuis quatre ans qu'il est normalisé, plusieurs erreurs ont été relevées dans la norme. (Dont une, c'est amusant, causée par le traitement du source du RFC, traitement qui avait fait disparaitre accidentellement des barres obliques inversées.)

Donc, notre RFC 9682 modifie l'ABNF qui décrit les littéraux pour les chaines de caractères, ABNF qui était trop laxiste (section 2 du RFC). Il change également la grammaire générale (section 3) pour autoriser (au niveau syntaxique) des schémas vides (ils restent interdits au niveau sémantique). Ainsi, l'ancienne règle :

cddl = S 1*(rule S)

devient :

cddl = S *(rule S)

L'article seul

RFC 9649: WebP Image Format

Date de publication du RFC : Novembre 2024

Auteur(s) du RFC : J. Zern, P. Massimino, J. Alakuijala

(Google)

Pour information

Première rédaction de cet article le 19 novembre 2024

Un RFC sur un

format d'image : il décrit le format WebP et

enregistre officiellement le type image/webp.

Bon, des images au format WebP, vous en avez forcément vu un peu partout sur le Web. Mais le format n'était pas encore documenté par un organisme de normalisation. C'est désormais fait. WebP s'appuie sur le format RIFF. Plus précisément, RIFF est un cadre générique qui peut se décliner en divers formats. C'est pour cela que les fichiers WebP commencent par les quatre codes ASCII correspondant à "RIFF".

WebP permet de la compression avec perte ou sans perte, et, d'une manière générale, tout ce qu'on attend d'un format graphique. C'est donc un concurrent de JPEG, PNG (RFC 2083), GIF… L'encodage lors de la compression avec perte est celui de VP8 (RFC 6386), produisant des images plus petites que ses prédécesseurs, ce qui est bon pour le réseau. La compression sans perte est faite en LZ77 et Huffman. WebP permet également le stockage de métadonnées codées en EXIF ou en XMP. Ah, et WebP permet des animations.

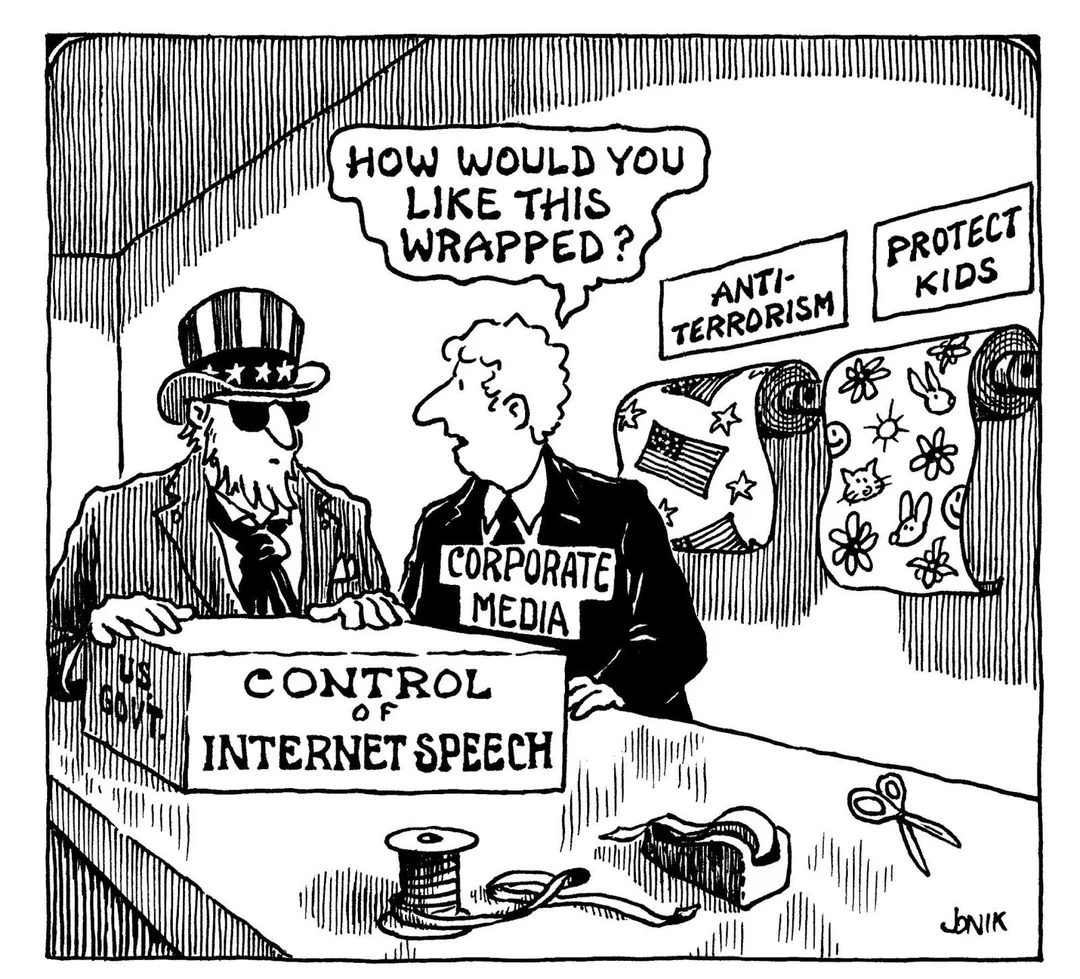

Cette image, sur un sujet politique qui est toujours d'actualité,

est au format WebP :

La section 2 du RFC décrit le format en détail. Les trois premiers champs sont la chaine "RIFF", la taille du fichier en binaire et la chaine "WEBP", chacun sur quatre octets. Affichons ces trois champs :

% dd if=how-do-you-like-it-wrapped.webp bs=4 count=3 RIFFXWEBP 3+0 records in 3+0 records out 12 bytes copied…

La section 3 décrit ensuite le stockage des pixels sans perte.

Comme avec tout format, les logiciels qui lisent les fichiers WebP (qu'on télécharge souvent depuis l'Internet, via des sources pas forcément de confiance) doivent être prudents dans l'analyse des fichiers. Les fichiers peuvent être invalides, par accident ou délibérément, et mener le logiciel négligent à lire en dehors d'un tableau ou déréférencer un pointeur invalide. La paranoïa est recommandée quand on lit ces fichiers. Plusieurs failles ont touché la libwebp, l'implémentation de référence, dont la grave CVE-2023-4863 en 2023 qui avait fait, à juste titre, beaucoup de bruit.

Toujours question sécurité, WebP n'a pas de contenu exécutable (contrairement à, par exemple, TrueType). Mais les métadonnées EXIF ou en XMP peuvent poser des problèmes de sécurité et doivent donc être interprétées avec prudence.

Le type

image/webp est désormais dans

le registre des types de médias (cf. le

formulaire rempli).

Si on regarde des fichiers WebP, on a ce genre d'informations :

% file resolution-dns.webp resolution-dns.webp: RIFF (little-endian) data, Web/P image % file --mime-type resolution-dns.webp resolution-dns.webp: image/webp

Pour finir, produisons un peu d'images WebP pour voir. Si on utilise Asymptote, c'est facile :

% asy -f webp -o resolution-dns.webp resolution-dns.asy

On peut aussi convertir depuis les formats existants, ici avec ImageMagick :

% convert -verbose resolution-dns.png resolution-dns.webp resolution-dns.png PNG 823x508 823x508+0+0 8-bit sRGB 31713B 0.020u 0:00.011 resolution-dns.png=>resolution-dns.webp PNG 823x508 823x508+0+0 8-bit sRGB 16580B 0.040u 0:00.047

Si on fait des graphiques depuis ses programmes en Python avec Matplotlib, il suffit, depuis la version 3.6, de :

plot.savefig(fname="test.webp") # No need to indicate the format, it

# is taken from the file extension.

(Voir aussi ce beau résultat sur Wikimedia Commons.)

L'article seul

Le cas du serveur DNS qui ne se mettait plus à jour

Première rédaction de cet article le 11 novembre 2024

La semaine dernière, 26 TLD africains avaient des problèmes DNS. Pourquoi ? Parce qu'une machine quelque part ne se mettait plus à jour et servait des données erronées.

Le problème semble s'être déclenché autour du 29 octobre. Des signalements ont été faits sur les réseaux

sociaux comme quoi certain·es utilisateurices n'arrivaient pas à

résoudre des noms en

.mg. On voit ici un test

fait avec les sondes RIPE

Atlas et le logiciel Blaeu :

% blaeu-resolve --requested 100 --displayvalidation --type NS mg [dns-tld.ird.fr. ns-mg.afrinic.net. ns-mg.malagasy.com. ns.dts.mg. ns.nic.mg. pch.nic.mg.] : 39 occurrences [ (Authentic Data flag) dns-tld.ird.fr. ns-mg.afrinic.net. ns-mg.malagasy.com. ns.dts.mg. ns.nic.mg. pch.nic.mg.] : 52 occurrences [ERROR: SERVFAIL] : 5 occurrences [ERROR: NXDOMAIN] : 2 occurrences Test #81689686 done at 2024-11-08T15:45:06Z

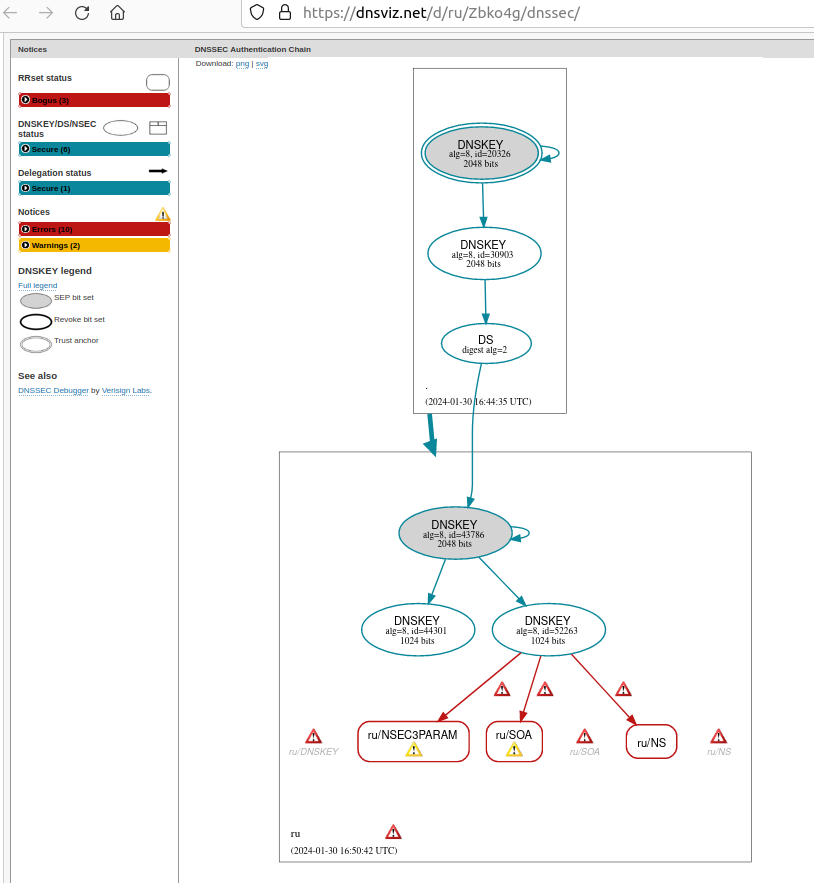

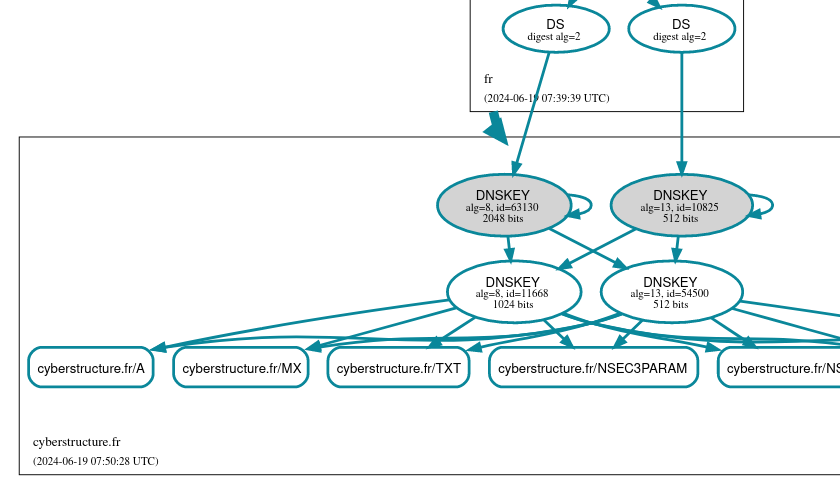

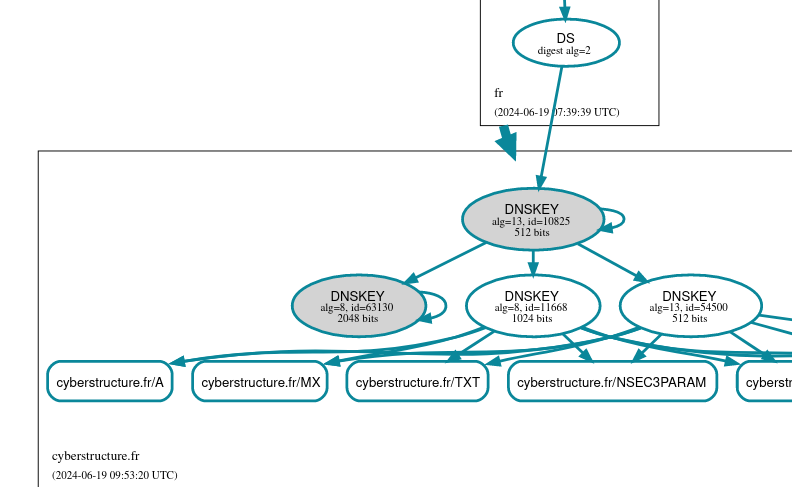

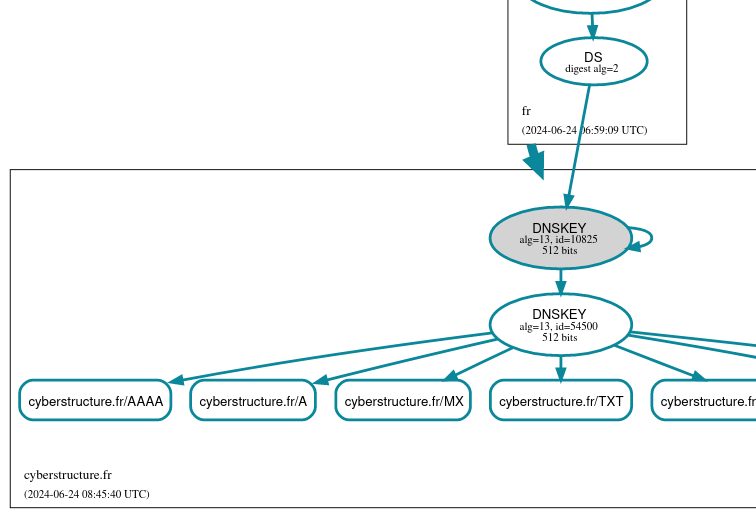

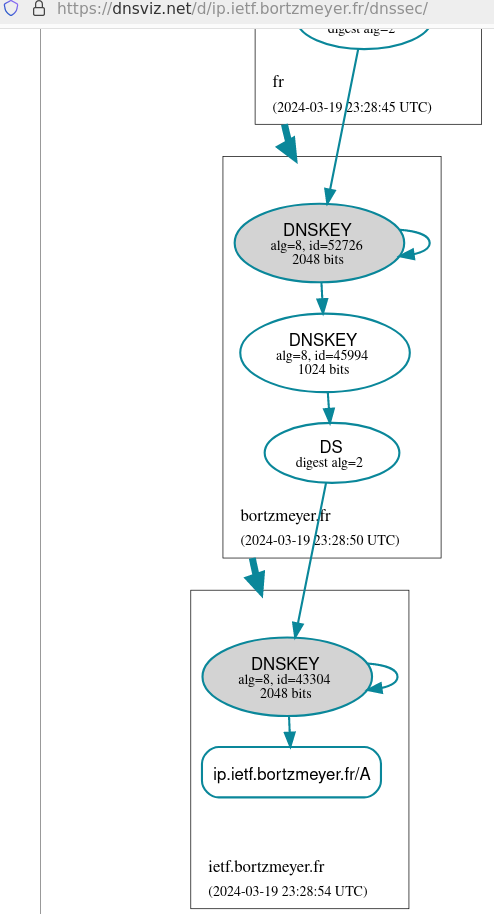

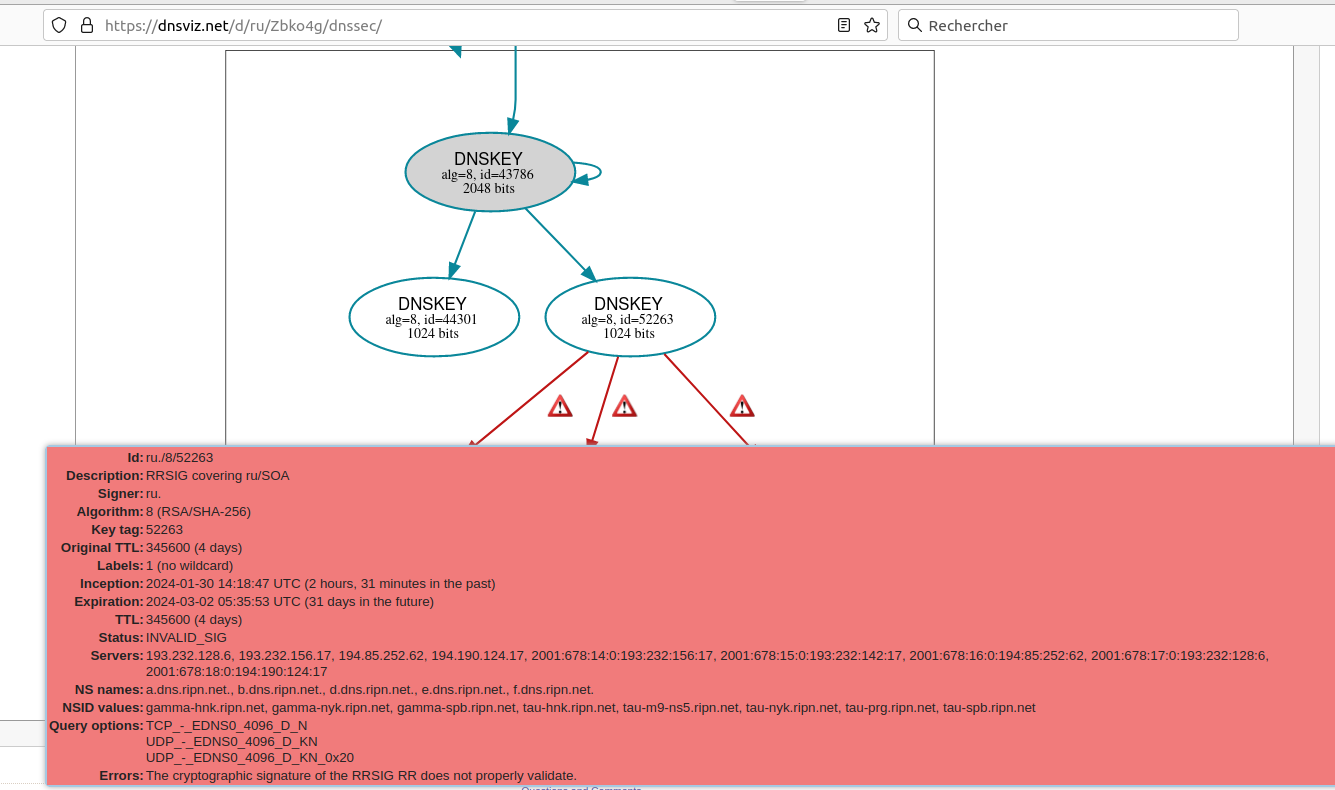

Cinq sondes ont un résolveur qui

répond SERVFAIL (Server Failure). On peut

soupçonner un problème DNSSEC et on voit en effet avec DNSviz que

des signatures expirées sont reçues par

certains clients DNS. Le fait que la plupart des utilisateurices ne

voient pas de problème laisse entendre que tous les serveurs faisant

autorité pour .mg ne sont pas également

affectés. Examinons-les tous :

% for ns in ns.dts.mg. ns-mg.malagasy.com. dns-tld.ird.fr. pch.nic.mg. ns.nic.mg. ns-mg.afrinic.net.; do for> echo $ns for> dig @$ns mg. NS for> done ns.dts.mg. … ;; ANSWER SECTION: mg. 7200 IN NS ns.nic.mg. mg. 7200 IN NS ns-mg.afrinic.net. mg. 7200 IN NS ns.dts.mg. mg. 7200 IN NS ns-mg.malagasy.com. mg. 7200 IN NS pch.nic.mg. mg. 7200 IN NS dns-tld.ird.fr. mg. 7200 IN RRSIG NS 8 1 7200 ( 20241113113756 20241030045734 18 mg. ExrGRrWttb4umpOtW2d8gbW2J1p68LENdw3X409lP1hm … ;; Query time: 193 msec ;; SERVER: 196.192.32.2#53(ns.dts.mg.) (UDP) ;; WHEN: Fri Nov 08 16:46:03 CET 2024 ;; MSG SIZE rcvd: 548 ns-mg.afrinic.net. … ;; ANSWER SECTION: mg. 7200 IN NS ns.dts.mg. mg. 7200 IN NS ns.nic.mg. mg. 7200 IN NS dns-tld.ird.fr. mg. 7200 IN NS ns-mg.malagasy.com. mg. 7200 IN NS pch.nic.mg. mg. 7200 IN NS ns-mg.afrinic.net. mg. 7200 IN RRSIG NS 8 1 7200 ( 20241101171148 20241018111647 18 mg. UIIoFCD8kaXyqTIVsrgBdiwQZxwHOXsnZjpPky5p5dRa … ; Query time: 156 msec ;; SERVER: 2001:43f8:120::35#53(ns-mg.afrinic.net.) (UDP) ;; WHEN: Fri Nov 08 16:46:04 CET 2024 ;; MSG SIZE rcvd: 504

Je n'ai gardé que la réponse de deux des serveurs. Celle de

ns.dts.mg ne montre aucun problème particulier

mais celle de ns-mg.afrinic.net montre une

signature expirée (20241101171148 = 1 novembre alors que le test a

été fait le 8). Pas étonnant que les résolveurs qui valident avec

DNSSEC soient mécontents. Mais pourquoi ce serveur fait-il cela ? En

testant avec le logiciel

check-soa, on voit :

% check-soa mg dns-tld.ird.fr. 13.39.116.127: OK: 2024110815 ns-mg.afrinic.net. 2001:43f8:120::35: OK: 2024102913 196.216.168.35: OK: 2024102913 ns-mg.malagasy.com. 51.178.182.212: OK: 2024110815 ns.dts.mg. 196.192.32.2: OK: 2024110815 ns.nic.mg. 196.192.42.153: OK: 2024110815 pch.nic.mg. 2001:500:14:6121:ad::1: OK: 2024110815 204.61.216.121: OK: 2024110815

Aïe, le numéro de série est en retard (2024102913 alors que les autres serveurs sont à 2024110815). Donc, ce serveur ne se met plus à jour avec son serveur maitre, il continue à distribuer de vieilles données.

Mais attention, ce serveur ns-mg.afrinic.net

est anycasté. Ce ne sont peut-être

pas toutes les instances anycast qui ont le

problème. D'ailleurs, check-soa depuis d'autres machines ne montre

pas de problème. Utilisons encore les sondes RIPE Atlas pour

interroger uniquement ce serveur, en demandant son NSID (RFC 5001) :

% blaeu-resolve --requested 100 --nameserver ns-mg.afrinic.net. --nsid --type SOA mg Nameserver ns-mg.afrinic.net. [NSID: s03-ns2.iso; ns.nic.mg. ramboa.nic.mg. 2024110815 14400 3600 604800 3600] : 41 occurrences [NSID: s01-ns2.pkl; ns.nic.mg. ramboa.nic.mg. 2024102913 14400 3600 604800 3600] : 28 occurrences [NSID: s01-ns2.pkl; ns.nic.mg. ramboa.nic.mg. 2024110815 14400 3600 604800 3600] : 24 occurrences [NSID: s04-ns2.jnb; ns.nic.mg. ramboa.nic.mg. 2024110815 14400 3600 604800 3600] : 4 occurrences [NSID: None; ns.nic.mg. ramboa.nic.mg. 2024110815 14400 3600 604800 3600] : 1 occurrences [TIMEOUT] : 2 occurrences Test #81689801 done at 2024-11-08T15:54:11Z

On voit ici que l'instance s01-ns2.pkl est

celle qui a le problème : le numéro de série est vieux. (Pour

compliquer les choses, notons qu'il y a deux instances ayant le même

NSID, ce qui ne facilite pas le déboguage.)

Une partie des clients DNS (ceux qui ont la malchance de tomber sur cette instance) reçoivent donc de la vieille information. Les domaines créés récemment, par exemple, ne sont pas connus de cette instance. Et, comme vu plus haut, elle sert des signatures expirées, ce qui peut planter DNSSEC. (Normalement, le résolveur validant, en recevant ces signatures expirées, devrait réessayer auprès d'un autre serveur du domaine mais, apparemment, certains ne le font pas.)

Et le problème n'affectait pas que .mg. Ce

serveur secondaire, géré par Afrinic, sert 26

TLD en

tout. (Les gérants de ces TLD ont été notifiés. Si vous voulez en

parler à Afrinic, c'est leur ticket [DNS

#924626]. Si vous connaissez l'Internet, vous ne serez pas surpris

d'apprendre que, dans deux cas, l'adresse de contact était invalide

et générait un message d'erreur.) Voici par exemple ce que cela

donnait pour .td :

% blaeu-resolve --requested 100 --nameserver ns-td.afrinic.net. --nsid --type SOA td Nameserver ns-td.afrinic.net. [NSID: s01-ns2.pkl; pch.nic.td. hostmaster.nic.td. 2024110815 21600 3600 604800 7200] : 20 occurrences [NSID: s01-ns2.pkl; pch.nic.td. hostmaster.nic.td. 2024102914 21600 3600 604800 7200] : 25 occurrences [NSID: s03-ns2.iso; pch.nic.td. hostmaster.nic.td. 2024110815 21600 3600 604800 7200] : 47 occurrences [NSID: None; pch.nic.td. hostmaster.nic.td. 2024110815 21600 3600 604800 7200] : 1 occurrences [NSID: s04-ns2.jnb; pch.nic.td. hostmaster.nic.td. 2024110815 21600 3600 604800 7200] : 5 occurrences Test #81691145 done at 2024-11-08T16:55:58Z

Le problème a finalement été réparé le 10 novembre. Afrinic a

retiré du service l'instance invalide. Ici, on voit qu'elle n'est

plus présente (test avec le .mz) :

% blaeu-resolve --requested 100 --displayvalidation --nsid --nameserver ns-mz.afrinic.net --type SOA mz Nameserver ns-mz.afrinic.net [NSID: s03-ns2.iso; anyns.uem.mz. hostmaster.nic.mz. 2024111106 480 300 259200 21600] : 48 occurrences [NSID: s01-ns2.jinx; anyns.uem.mz. hostmaster.nic.mz. 2024111106 480 300 259200 21600] : 13 occurrences [TIMEOUT] : 33 occurrences [NSID: s04-ns2.jnb; anyns.uem.mz. hostmaster.nic.mz. 2024111106 480 300 259200 21600] : 4 occurrences [NSID: None; anyns.uem.mz. hostmaster.nic.mz. 2024111106 480 300 259200 21600] : 1 occurrences Test #81847650 done at 2024-11-11T06:14:08Z

Les leçons à en tirer :

- Des cas similaires, voire très proches, avaient déjà existé (voir par exemple le problème de .com à Singapour et sa vision par Cloudflare).

- L'Internet, c'est compliqué, le DNS aussi,

- Du fait du caractère décentralisé de l'Internet et du DNS, deux clients différents placés à des endroits différents ne verront pas la même chose. Il ne faut pas donc déboguer depuis un seul point de mesure (tests avec dig et check-soa) mais depuis plusieurs, ce que permettent justement les sondes Atlas,

- Le DNS résiste beaucoup mieux aux pannes franches (câble coupé) qu'aux serveurs qui servent des réponses erronées ou dépassées. En cas de panne franche, un autre des serveurs faisant autorité aurait été interrogé. Si vous supervisez vos serveurs DNS (et vous le faites, j'en suis sûr), ne regardez pas seulement s'ils répondent mais aussi s'ils répondent avec les bonnes données.

Annexe : la liste des domaines africains servis par la machine d'Afrinic pendant la panne :

.bi .bj .bw .ci .cm .dz .gm .gn .ke .km .lr .ls .ly .mg .mr .mz .ne .rw .sd .ss .td .tn .ug .zm .موريتانيا .تونس

L'article seul

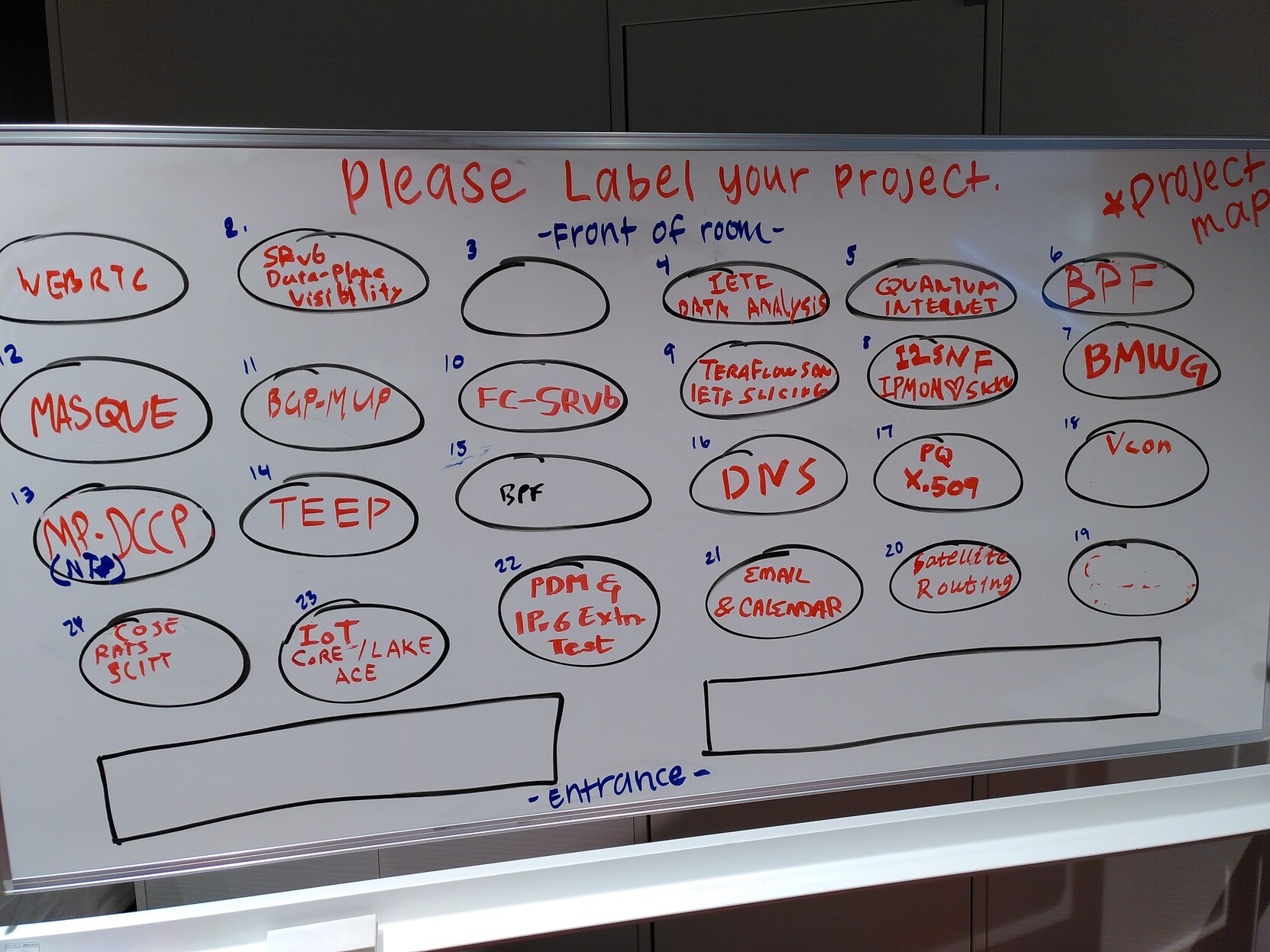

IETF 121 hackathon: greasing DNS answers

First publication of this article on 10 November 2024

On November 2 and 3 was the IETF hackathon in Dublin. I worked on the greasing of DNS answers from an authoritative name server. What is greasing? Continue reading.

One of the big technical problems of the Internet is its ossification: software is written by people who did not read the technical standards, or did not understand them, specially software in the middleboxes (load balancers, firewalls, etc). As a result, some things that are possible according to the technical specification are de facto forbidden by broken software. This makes difficult to deploy new things. For instance, TLS 1.3 had to pretend to be 1.2 (and add an extension to say "I am actually 1.3") because too many middleboxes prevented the establishement of TLS sessions if the version was 1.3 (see RFC 8446, section 4.1.2). This problem is widespread in the Internet, specially since there is typically no way to talk to the middlebox software authors and these boxes are popular among managers.

A way to fight ossification is greasing. Basically, the idea is to exercise all the features and options of a protocol from day one, not waiting that you really need them. This way, broken software will be detected immediately, not many years after, when it is entrenched. TLS was the first protocol to go that way (see RFC 8701) and it proved effective. QUIC also uses greasing (RFC 9287).

The DNS could

benefit from greasing as well, since it is often difficult to deploy

new features, because they sometimes break bad software (it was the

case with the cookies of RFC 7873). Hence the current

Internet Draft draft-ietf-dnsop-grease.

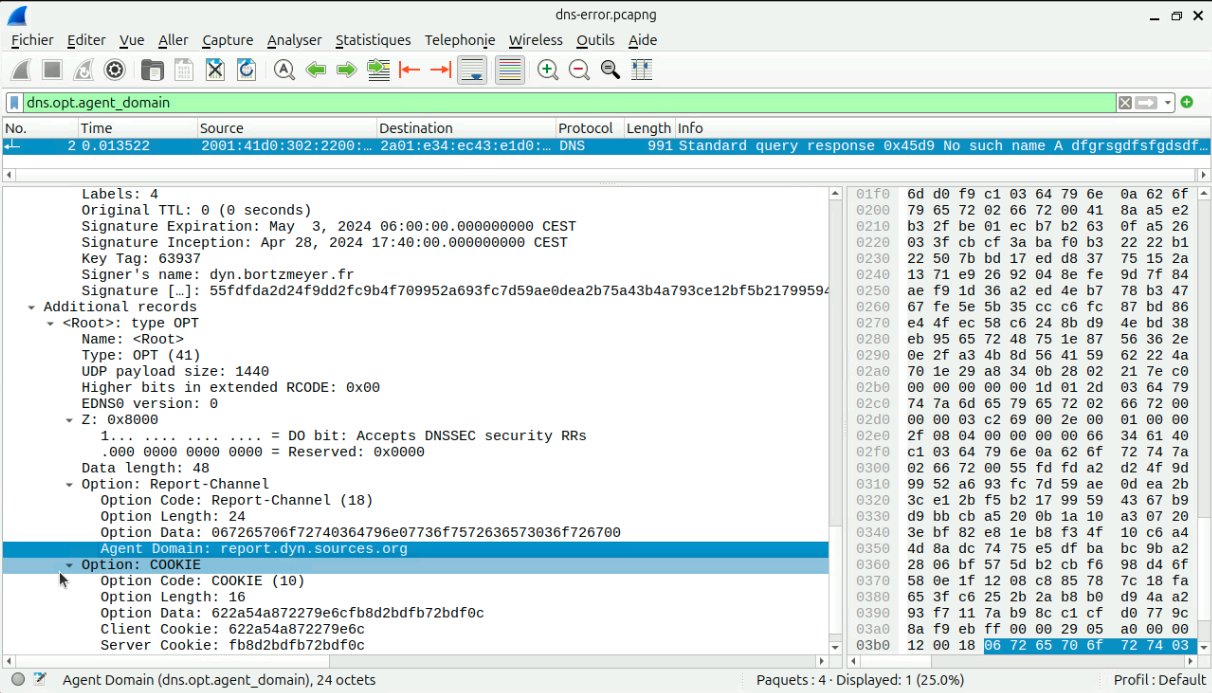

OK, so, let's grease the rusted parts of the Internet but where exactly, and how? DNS servers are basically of two kinds: resolver and authoritative servers. The version -00 of the draft only mentions resolvers because they are in the best place to test greasing and to report what broke. The general idea is that the resolver sends its queries with "unexpected" values (unallocated EDNS options, unallocated EDNS flags, etc, all of them "legal" according to the RFC). If it receives no reply from the authoritative server (or a bad one such as FORMERR), and, if retrying without greasing work, the resolver knows there is a problem in the path to this authoritative name server and can log it and/or report it (for instance through RFC 9567). The remaining question is: what we can grease? We need options that are legal to send but new and unexpected. For plain DNS, there is no hope: there is only one remaining (unallocated) bit in the flags (RFC 1035, section 4.1.1) of the DNS query. So, it means we can grease only with EDNS stuff: EDNS version number, EDNS options, and EDNS flags. For instance, unknown EDNS options are supposed to be ignored (otherwise, it would never be possible to deploy new options). Now, how to choose the unallocated values to send? TLS decided to reserve ranges of values for which to choose randomly. The risk is that some bad software will treat this range in a special way but, at least, it guarantees there will be no collision with a future allocation.

This is the current version (-00) of the draft. Now, the work at the hackahton. First, I decided to work on an authoritative server. A priori, it is less useful than a resolver, because, unlike the resolver, the authoritative name server cannnot know if its reply was accepted or not, or created problems. But it could be useful on test zones, to see (for instance through the use of RIPE Atlas probes) if they have resolution issues. The work was done on the software Drink.

First test, sending back in the reply two EDNS records. Sending two OPT records in a response does not seem forbidden by the RFC (which prohibit it only in a query, RFC 6891, section 6.1.1) but dig does not like it:

% dig +norec grease.courbu.re SOA @31.133.134.59 ;; Warning: Message parser reports malformed message packet.

It creates problems with many other programs and it is not clear if it is legitimate so let's stop here.

Second test, sending an EDNS reply with a version number which is higher than the one requested. This is legal, the last paragraph of Section 6.1.3 of RFC 6891 says that a responder can respond with a higher EDNS version than what was requested by the requestor. (And it explains why, and the limits, for instance to keep the same format.) I tried that for DNS greasing and typical resolvers seem to be happy with it. But DNS testing tools (very useful tools, do not forget to tests your zones with them!) disagree. ednscomp says "expect: OPT record with version set to 0" (not greater-or-equal, stricly equal). DNSviz says "The server responded with EDNS version 1 when a request with EDNS version 0 was sent, instead of responding with RCODE BADVERS. See RFC 6891, Sec. 6.1.3." (We obviously do not read this section in the same way. To me, it mentions BADVERS only in a different context.) And Zonemaster also disagrees with me. So, there is a debate: when a responder knows both version 0 and some higher version (say, version 1), can it reply to a EDNS=0 query with a EDNS=1 response? Can we use that for greasing?

Less controversial, adding EDNS options and flags. You can see the result here:

% dig @192.168.41.237 grease.courbu.re SOA

; <<>> DiG 9.18.28-0ubuntu0.24.04.1-Ubuntu <<>> @192.168.41.237 grease.courbu.re SOA

; (1 server found)

;; global options: +cmd

;; Got answer:

;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 61647

;; flags: qr aa rd; QUERY: 1, ANSWER: 1, AUTHORITY: 0, ADDITIONAL: 1

;; WARNING: recursion requested but not available

;; OPT PSEUDOSECTION:

; EDNS: version: 1, flags:; MBZ: 0x0072, udp: 1440

; OPT=16282: 58 ("X")

; OPT=17466: 58 58 58 58 58 58 58 58 58 ("XXXXXXXXX")

; OPT=18095: 58 58 58 58 58 58 58 58 58 58 58 58 58 58 58 58 58 58 58 ("XXXXXXXXXXXXXXXXXXX")

; OPT=16375: 58 58 58 58 58 58 58 58 58 58 58 58 58 58 58 58 ("XXXXXXXXXXXXXXXX")

; OPT=18: 06 72 65 70 6f 72 74 07 65 78 61 6d 70 6c 65 03 63 6f 6d 00 (".report.example.com.")

; COOKIE: db279863745c8e7198d4274c54233c48 (good)

;; QUESTION SECTION:

;grease.courbu.re. IN SOA

;; ANSWER SECTION:

grease.courbu.re. 0 IN SOA dhcp-863b.meeting.ietf.org. root.invalid. (

2024111007 ; serial

1800 ; refresh (30 minutes)

300 ; retry (5 minutes)

604800 ; expire (1 week)

86400 ; minimum (1 day)

)

;; Query time: 1 msec

;; SERVER: 192.168.41.237#53(192.168.41.237) (UDP)

;; WHEN: Sun Nov 10 07:33:30 GMT 2024

;; MSG SIZE rcvd: 224

Here, the authoritative name server (a recent version of Drink,using

the --greasing option at startup), sent:

- A EDNS response with version 1 (remember current version is 0),

- Four EDNS options with unallocated codes, with varying length and values (the last two options have allocated codes, even if dig knows only one, these two options are not greasing),

- Unallocated EDNS flags set (the "0x0072").

Apparently, from tests with various resolver software and through RIPE Atlas probes, it does not break anything, thus paving the way for future allocations. Note that option codes, flags and the number of options are choosen at random, following the draft.

If you want to see the changes it required in the name server, this is this pull request.

Thanks to Shumon Huque and Mark Andrews for code, conversation and explanations.

L'article seul

Fiche de lecture : L'avenir d'Internet - unité ou fragmentation ?

Auteur(s) du livre : Clément Perarnaud, Julien

Rossi, Francesca Musiani, Lucien

Castex

Éditeur : Le bord de l'eau

9782385190682

Publié en 2024

Première rédaction de cet article le 9 novembre 2024

La fragmentation d'Internet est un sujet complexe, et souvent mal traité. Ce court livre fait le point sur les différentes questions que soulève ce débat et d'abord « qu'est-ce que c'est que la fragmentation ? » J'en recommande la lecture.

Le terme de fragmentation a en effet souvent été utilisé dans un but politique. Des influenceurs étatsuniens ont dit que le RGPD (ou le DSA), avec son application extra-territoriale, menait à une fragmentation de l'Internet. D'autres influenceurs étatsuniens (ou les mêmes) dénoncent toute activité de souveraineté numérique (imposer le stockage des données dans le pays, imposer que les échanges entre entités du pays restent dans le pays, etc) comme de la fragmentation. On entend souvent dire que les Chinois ou les Russes auraient « leur propre Internet » (ce qui n'a aucun sens). On se demande souvent si les gens qui répètent avec gourmandise qu'il y a fragmentation de l'Internet avec les actions russes ou chinoises le déplorent, ou bien s'ils voudraient que d'autres pays fassent pareil… Enfin, le débat est souvent marqué par l'hypocrisie comme lorsque les USA dénoncent le fait que le gouvernement chinois veuille empêcher ses citoyens d'aller sur Facebook alors que lui-même fait tout pour bloquer TikTok. En paraphrasant OSS 117, on pourrait dire « non, mais la fragmentation, c'est seulement quand les gens ont des manteaux gris et qu'il fait froid ».

Bref, le débat est mal parti. D'où l'importance de ce livre, qui est tiré d'un rapport au Parlement européen des mêmes auteurs, et qui étudie sérieusement les différents aspects de la question.

Déjà, première difficulté, définir la fragmentation. Est-ce lorsque une machine ne peut plus envoyer un paquet IP à une autre ? (La traduction d'adresses est-elle un facteur de fragmentation ?) Est-ce lorsque le résolveur DNS par défaut ne résout pas certains noms ? (Et si on peut en changer ?) Est-ce quand les Chinois n'utilisent pas les mêmes réseaux sociaux ou moteurs de recherche que nous ? (Ne riez pas, j'ai déjà entendu cette affirmation.) Bien des participant·es au début ne connaissent pas le B.A. BA du modèle en couches et n'essaient même pas de définir rigoureusement la fragmentation. Les auteur·es du livre s'attachent à examiner les définitions possibles. Non, ielles ne fournissent pas « la bonne définition », le problème est trop complexe pour cela. Il est sûr que tout·e utilisateurice de l'Internet ne voit pas la même chose et n'a pas le même vécu. Mais enfermer cette observation évidente dans une définition rigoureuse reste difficile.

D'un côté, disent les auteure·es, il y a bien des tendances centrifuges. De l'autre, non, l'Internet n'est pas fragmenté, malgré les affirmations de ceux qui tentent des prophéties auto-réalisatrices (comme le notent les auteur·es, le thème de la fragmentation et l'utilisation de termes journalistiques comme « splinternet » est souvent simplement une arme rhétorique). Mais est-ce que cela durera ?

Le livre détaille l'action des États qui pousse à la fragmentation, le jeu des lois du marché qui peut mener à la création de silos fermés (la fameuse « minitélisation de l'Internet »), etc.

Bon, une critique, quand même. Tout débat sur la politique Internet est forcément complexe car il faut à la fois comprendre la politique et comprendre Internet. Et, s'agissant de l'Internet, des faits de base (comme le pourcentage d'utilisateurs qui utilisent un résolveur DNS public) sont souvent difficiles à obtenir. Néanmoins, prétendre que dix sociétés résolvent la moitié des requêtes DNS au niveau mondial est impossible à croire. Le chiffre, cité p. 73, est tiré d'un article grossièrement anti-DoH qui ne cite pas ses sources. (Pour voir à quel point ce chiffre est invraisemblable, pensez simplement que toutes les études montrent que les résolveurs DNS publics sont une minorité des usages, et surtout que cela dépend des pays, les Chinois n'utilisant pas les mêmes que les Français et ielles sont nombreux.) L'usage de chiffres « au doigt mouillé » est malheureusement fréquent dans les débats de politique Internet.

Mais, bon, je l'ai dit, la question est très complexe, les données souvent dures à obtenir et cette critique ne doit pas vous empêcher d'apprendre tout sur le débat « fragmentation » dans cet excellent livre. Et rappelez-vous, l'avenir de l'Internet dépend aussi de vous.

L'article seul

RFC 9687: Border Gateway Protocol 4 (BGP-4) Send Hold Timer

Date de publication du RFC : Novembre 2024

Auteur(s) du RFC : J. Snijders

(Fastly), B. Cartwright-Cox (Port

179), Y. Qu (Futurewei)

Chemin des normes

Première rédaction de cet article le 8 novembre 2024

Que doit faire un routeur BGP lorsque le pair en face ne traite manifestement plus ses messages ? Ce n'était pas précisé avant mais la réponse est évidente : raccrocher (mettre fin à la communication).

Un problème classique lors d'une connexion réseau, par exemple sur TCP, est de détecter si la machine en face est toujours là. Par défaut, TCP ne fournit pas ce service : s'il n'y a aucun trafic, vous ne pouvez pas savoir si votre partenaire est mort ou simplement s'il n'a rien à dire. Une coupure de réseau, par exemple, ne sera pas détectée tant que vous n'avez pas de trafic à transmettre (avec attente d'une réponse). Et BGP ne transmet que les changements donc l'absence de trafic ne signale pas forcément un problème. Il existe des solutions, comme d'envoyer périodiquement des messages même quand on n'a rien à dire (RFC 4271, section 4.4), mais aucune n'est parfaite : un programme qui utilise TCP ne sait typiquement pas immédiatement si ses messages sont vraiment partis (et l'alarme actuelle ne couvre que la réception des messages, pas leur envoi). Et BGP n'a pas de fonction « ping », qui exigerait une réponse.

Quand la coupure est franche et détectée, aucun problème, la session BGP (RFC 4271) s'arrête et les routes correspondantes sont retirées de la table de routage. Mais ce RFC traite le cas de où le routeur BGP d'en face a un problème mais qu'on ne détecte pas. Un exemple : si ce routeur en face a complètement fermé sa fenêtre TCP de réception (RFC 9293, notamment la section 3.8.6), on ne pourra pas lui envoyer de messages, mais la session BGP ne sera pas coupée et les paquets continueront à être transmis selon des annonces de routage dépassées, alors qu'ils finiront peut-être dans un trou noir (le problème des « zombies BGP »).

La solution (section 3 de notre RFC) est de modifier

l'automate de BGP (RFC 4271, section 8), en ajoutant une alarme (RFC 4271, section 10),

SendHoldTimer. Quand elle expire, on coupe la

connexion TCP et on retire les routes qu'avait annoncé le pair dont

on n'a plus de nouvelles. Le RFC recommande une configuration par

défaut de huit minutes de patience avant de déclencher l'alarme.

L'erreur « Send Hold Timer Expired » est désormais dans le registre IANA des erreurs BGP et tcpdump sait l'afficher. Il existe plusieurs mises en œuvre de ce RFC :

- Celle d'OpenBGPD (son source),

- Celle de FRRouting (son source),

- Celle de BIRD (son source).

Si les processus IETF vous passionnent, il y a une documentation des discussions autour de ce RFC.

L'article seul

RFC 9669: BPF Instruction Set Architecture (ISA)

Date de publication du RFC : Octobre 2024

Auteur(s) du RFC : D. Thaler

Chemin des normes

Réalisé dans le cadre du groupe de travail IETF bpf

Première rédaction de cet article le 1 novembre 2024

On a souvent envie de faire tourner des programmes à soi dans le noyau du système d'exploitation, par exemple à des fins de débogage ou d'observation du système. Cela soulève plein de problèmes (programmer dans le noyau est délicat) et la technique eBPF permet, depuis de nombreuses années, de le faire avec moins de risques. Ce RFC spécifie le jeu d'instructions eBPF. Programmeureuses en langage d'assemblage, ce RFC est pour vous.

eBPF désigne ici un jeu d'instructions (comme ARM ou RISC-V). Programmer en eBPF, c'est donc programmer en langage d'assemblage et, en général, on ne le fait pas soi-même, on écrit dans un langage de plus haut niveau (non spécifié ici mais c'est souvent un sous-ensemble de C) et on confie à un compilateur le soin de générer les instructions. Ce jeu d'instructions a plusieurs particularités. Notamment, il est délibérément limité, puisque toute bogue dans le noyau est particulièrement sérieuse, pouvant planter la machine ou pire, permettre son piratage. Vous ne pouvez pas faire de boucles générales, par exemple. eBPF est surtout répandu dans le monde Linux (et c'est là où vous trouverez beaucoup de ressources) où il est une alternative aux modules chargés dans le noyau. Pas mal du code réseau d'Android est ainsi en eBPF. Normalisé ici, eBPF peut être mis en œuvre sur d'autres noyaux (il tourne sur Windows, par exemple). Le monde eBPF est très riche, il y a plein de logiciels (pas toujours faciles à utiliser), plein de tutoriels (pas toujours à jour et qui ne correspondent pas toujours à votre système d'exploitation) mais cet article se focalise sur le sujet du RFC : le jeu d'instructions.

On trouve de nombreux exemples d'utilisation en production par exemple le répartiteur de charge Katran chez Facebook, via lequel vous êtes certainement passé, si vous utilisez Facebook. En plus expérimental, j'ai trouvé amusant qu'on puisse modifier les réponses DNS en eBPF.

Passons tout de suite à la description de ce jeu

d'instructions (ISA = Instruction Set

Architecture). D'abord, les types (section 2.1) :

u32 est un entier non

signé sur 32 bits, s16, un signé

sur 16 bits, etc. eBPF fournit des fonctions de conversions utiles

(section 2.2) comme be16 qui convertit en

gros boutien (le RFC cite IEN137…). Au

passage, une mise en œuvre d'eBPF n'est pas obligée de tout fournir

(section 2.4). La norme décrit des groupes de conformité et une

implémentation d'eBPF doit lister quels groupes elle met en

œuvre. Le groupe base32 (qui n'a rien à voir

avec le Base32 du RFC 4648) est le minimum requis dans tous les cas. Par

exemple, divmul32 ajoute multiplication et

division. Tous ces groupes figurent dans un registre IANA.

Les instructions eBPF sont encodées en 64 ou 128 bits (section

3). On y trouve les instructions classiques de tout jeu, les

opérations arithmétiques (comme ADD), logiques

(comme AND), les sauts

(JA, JEQ et autrs), qui se

font toujours vers l'avant, pour, je suppose, ne pas permettre de boucles

(souvenez-vous du problème de l'arrêt, qui n'a

pas de solution avec un jeu

d'instructions plus étendu), l'appel de fonction, etc.

En parlant de fonctions, eBPF ne peut pas

appeler n'importe quelle fonction. Il y a deux sortes de fonctions

utilisables, les fonctions d'aide (section 4.3.1), pré-définies par

la plateforme utilisée, et non normalisées (pour celles de Linux,

voir la

documentation, qui est sous

Documentation/bpf si vous avez les sources du

noyau). Il y a aussi les fonctions locales (section 4.3.2), définies

par le programme eBPF.

Il y a enfin des instructions pour lire et écrire dans la mémoire

(LD, ST, etc). Pour

mémoriser plus facilement, eBPF utilise

des dictionnaires (maps,

cf. section 5.4.1).

La section 6 concerne la sécurité, un point évidemment crucial puisque les programmes eBPF tournent dans le noyau, où les erreurs ne pardonnent pas. Un programme eBPF malveillant peut provoquer de nombreux dégâts. C'est pour cela que, sur Linux, seul root peut charger un tel programme dans le noyau. Le RFC recommande de faire tourner ces programmes dans un environnement limité (bac à sable), de limiter les ressources dont ils disposent et de faire tourner des vérifications sur le programme avant son exécution (par exemple, sur Linux, regardez cette documentation ou bien l'article « Simple and Precise Static Analysis of Untrusted Linux Kernel Extensions »).

Enfin, section 7, les registres (pas les registres du processeur, ceux où on enregistre les codes utilisés). Deux registres IANA sont créés, celui des groupes de conformité et celui du jeu d'instructions. L'annexe A du RFC donne les valeurs actuelles. Les registres sont extensibles et la politique d'enregistrement est « Spécification nécessaire » et « Examen par un expert », cf. RFC 8126. (J'avoue ne pas savoir pourquoi, si les opcodes sont enregistrés, les mnémoniques ne le sont pas, cela rend les registres difficiles à lire.)

Un peu d'histoire, au passage. eBPF est dérivé de BPF, ce qui voulait dire Berkeley Packet Filter, et était spécifique au filtrage des paquets réseau. Cet usage a été notamment popularisé par tcpdump. D'ailleurs, ce programme a une option pour afficher le code BPF produit :

% sudo tcpdump -d port 53 (000) ldh [12] (001) jeq #0x86dd jt 2 jf 10 (002) ldb [20] (003) jeq #0x84 jt 6 jf 4 (004) jeq #0x6 jt 6 jf 5 (005) jeq #0x11 jt 6 jf 23 (006) ldh [54] … (021) jeq #0x35 jt 22 jf 23 (022) ret #262144 (023) ret #0

Si vous voulez vous mettre à eBPF (attention, la courbe

d'apprentissage va être raide), man 4 bpf est

utile. Typiquement, vous écrirez vos programmes dans un

sous-ensemble de C et vous

compilerez en eBPF, par exemple avec clang,

après avoir installé tous les outils et bibliothèques nécessaires

(il faut souvent des versions assez récentes) :

% cat count.c

…

int count_packets(struct __sk_buff *skb) {

__u32 key = 0;

__u64 *counter;

counter = bpf_map_lookup_elem(&pkt_counter, &key);

if (counter) {

(*counter)++;

}

return 0;

}

…

% clang -target bpf -c count.c

% file count.o

count.o: ELF 64-bit LSB relocatable, eBPF, version 1 (SYSV), not stripped

% objdump -d count.o

…

0000000000000000 <count_packets>:

0: 7b 1a f8 ff 00 00 00 00 stxdw [%r10-8],%r1

8: b7 01 00 00 00 00 00 00 mov %r1,0

10: 63 1a f4 ff 00 00 00 00 stxw [%r10-12],%r1

18: 18 01 00 00 00 00 00 00 lddw %r1,0

20: 00 00 00 00 00 00 00 00

28: bf a2 00 00 00 00 00 00 mov %r2,%r10

30: 07 02 00 00 f4 ff ff ff add %r2,-12

(Notez l'utilisation du désassembleur objdump.) Vous pouvez alors charger le code eBPF dans votre noyau, par exemple avec bpftool (et souvent admirer de beaux messages d'erreur comme « libbpf: elf: legacy map definitions in 'maps' section are not supported by libbpf v1.0+ »). Si tout fonctionne, votre code eBPF sera appelé par le noyau lors d'événements particuliers que vous avez indiqués (par exemple la création d'un processus, ou bien l'arrivée d'un paquet par le réseau) et fera alors ce que vous avez programmé. Comme me le fait remarquer Pierre Lebeaupin, il y a une bogue dans le source ci-dessus : l'incrémentation du compteur n'est pas atomique et donc, si on a plusieurs CPU, on risque de perdre certaines incrémentations. La solution de ce problème est laissé à la lectrice.

Un exemple d'utilisation d'eBPF pour observer ce que fait le noyau (ici avec un outil qui fait partie de bcc), on regarde les exec :

% sudo /usr/sbin/execsnoop-bpfcc PCOMM PID PPID RET ARGS check_disk 389622 1628 0 /usr/lib/nagios/plugins/check_disk -c 10% -w 20% -X none -X tmpfs -X sysfs -X proc -X configfs -X devtmpfs -X devfs -X check_disk 389623 1628 0 /usr/lib/nagios/plugins/check_disk -c 10% -w 20% -X none -X tmpfs -X sysfs -X proc -X configfs -X devtmpfs -X devfs -X check_swap 389624 1628 0 /usr/lib/nagios/plugins/check_swap -c 25% -w 50% check_procs 389625 1628 0 /usr/lib/nagios/plugins/check_procs -c 400 -w 250 ps 389627 389625 0 /bin/ps axwwo stat uid pid ppid vsz rss pcpu etime comm args sh 389632 389631 0 /bin/sh -c [ -x /usr/lib/php/sessionclean ] && if [ ! -d /run/systemd/system ]; then /usr/lib/php/sessionclean; fi sessionclean 389633 1 0 /usr/lib/php/sessionclean sort 389635 389633 0 /usr/bin/sort -rn -t: -k2,2 phpquery 389638 389634 0 /usr/sbin/phpquery -V expr 389639 389638 0 /usr/bin/expr 2 - 1 sort 389642 389638 0 /usr/bin/sort -rn

Le code eBPF est interprété par une machine virtuelle ou bien traduit à la volée en code natif.

Même ChatGPT peut écrire de l'eBPF (les tours de Hanoi et un serveur DNS).

De nombreux exemples se trouvent dans le répertoire

samples/bpf des sources du noyau Linux. (Le

fichier README.rst explique comment compiler

mais seulement dans le cadre de la compilation d'un noyau. En gros,

c'est make menuconfig , cd

samples/bpf puis make -i.) Un bon

exemple, relativement simple, pour commencer avec le réseau est

tcp_clamp_kern.c.

Si vous préférez travailler en Go (là aussi, avec un Go récent…), il existe un bon projet. Si vous suivez bien la documentation, vous pourrez compiler des programmes et les charger :

% go mod init ebpf-test % go mod tidy % go get github.com/cilium/ebpf/cmd/bpf2go % go generate % go build % sudo ./ebpf-test 2024/08/20 15:21:43 Counting incoming packets on veth0.. … 2024/08/20 15:22:03 Received 25 packets 2024/08/20 15:22:04 Received 26 packets 2024/08/20 15:22:05 Received 27 packets 2024/08/20 15:22:06 Received 502 packets <- ping -f 2024/08/20 15:22:07 Received 57683 packets 2024/08/20 15:22:08 Received 75237 packets ^C2024/08/20 15:22:09 Received signal, exiting..

Vous trouverez beaucoup de ressources eBPF sur https://ebpf.io/

Ce RFC avait fait l'objet de pas mal de débats à l'IETF car, normalement, l'IETF ne normalise pas de langages de programmation ou de jeux d'instructions. (La première réunion était à l'IETF 116 en mars 2023 donc c'est quand même allé assez vite.)

L'article seul

RFC 9636: The Time Zone Information Format (TZif)

Date de publication du RFC : Octobre 2024

Auteur(s) du RFC : A.D. Olson, P. Eggert

(UCLA), K. Murchison (Fastmail)

Chemin des normes

Première rédaction de cet article le 31 octobre 2024

Ce nouveau RFC

documente un format déjà ancien et largement déployé, TZif, un

format de description des fuseaux

horaires. Il définit également des types MIME pour ce format,

application/tzif et

application/tzif-leap. Il remplace le premier

RFC de normalisation de ce format, le RFC 8536, mais il y a très peu de changements. Bienvenue donc

à la version 4 du format, spécifiée dans ce RFC.

Ce format existe depuis quarante ans (et a pas mal évolué pendant ce temps) mais n'avait apparemment jamais fait l'objet d'une normalisation formelle avant le RFC 8536 en 2019. La connaissance des fuseaux horaires est indispensable à toute application qui va manipuler des dates, par exemple un agenda. Un fuseau horaire se définit par un décalage par rapport à UTC, les informations sur l'heure d'été, des abréviations pour désigner ce fuseau (comme CET pour l'heure de l'Europe dite « centrale ») et peut-être également des informations sur les secondes intercalaires. Le format iCalendar du RFC 5545 est un exemple de format décrivant les fuseaux horaires. TZif, qui fait l'objet de ce RFC, en est un autre. Contrairement à iCalendar, c'est un format binaire.

TZif vient à l'origine du monde Unix et est apparu dans les années 1980, quand le développement de l'Internet, qui connecte des machines situées dans des fuseaux horaires différents, a nécessité que les machines aient une meilleure compréhension de la date et de l'heure. Un exemple de source faisant autorité sur les fuseaux horaires est la base de l'IANA décrite dans le RFC 6557 et dont l'usage est documenté à l'IANA. Pour la récupérer, voir par exemple le RFC 7808.

La section 2 de notre RFC décrit la terminologie du domaine :

- Temps Universel Coordonné (UTC est le sigle officiel) : la base du temps légal. Par exemple, en hiver, la France métropolitaine est en UTC + 1. (GMT n'est utilisé que par les nostalgiques de l'Empire britannique.)

- Heure d'été (le terme français est incorrect, l'anglais DST - Daylight Saving Time est plus exact) : le décalage ajouté ou retiré à certaines périodes, pour que les activités humaines, et donc la consommation d'énergie, se fassent à des moments plus appropriés (cette idée est responsable d'une grande partie de la complexité des fuseaux horaires).

- Temps Atomique International (TAI) : contrairement à UTC, qui suit à peu près le soleil, TAI est déconnecté des phénomènes astronomiques. Cela lui donne des propriétés intéressantes, comme la prédictibilité (alors qu'on ne peut pas savoir à l'avance quelle sera l'heure UTC dans un milliard de secondes) et la monotonie (jamais de sauts, jamais de retour en arrière, ce qui peut arriver à UTC). Cela en fait un bon mécanisme pour les ordinateurs, mais moins bon pour les humains qui veulent organiser un pique-nique. Actuellement, il y a 37 secondes de décalage entre TAI et UTC.

- Secondes intercalaires : secondes ajoutées de temps en temps à UTC pour compenser les variations de la rotation de la Terre.

- Correction des secondes intercalaires : TAI - UTC - 10 (lisez le RFC pour savoir pourquoi 10). Actuellement 27 secondes.